Warum neue KI-Modelle ihren Vorsprung in Rekordzeit verlieren

Führende Entwickler stehen unter Druck. Konkurrenten kopieren teure Modelle durch Model Distillation oft schon nach wenigen Wochen.

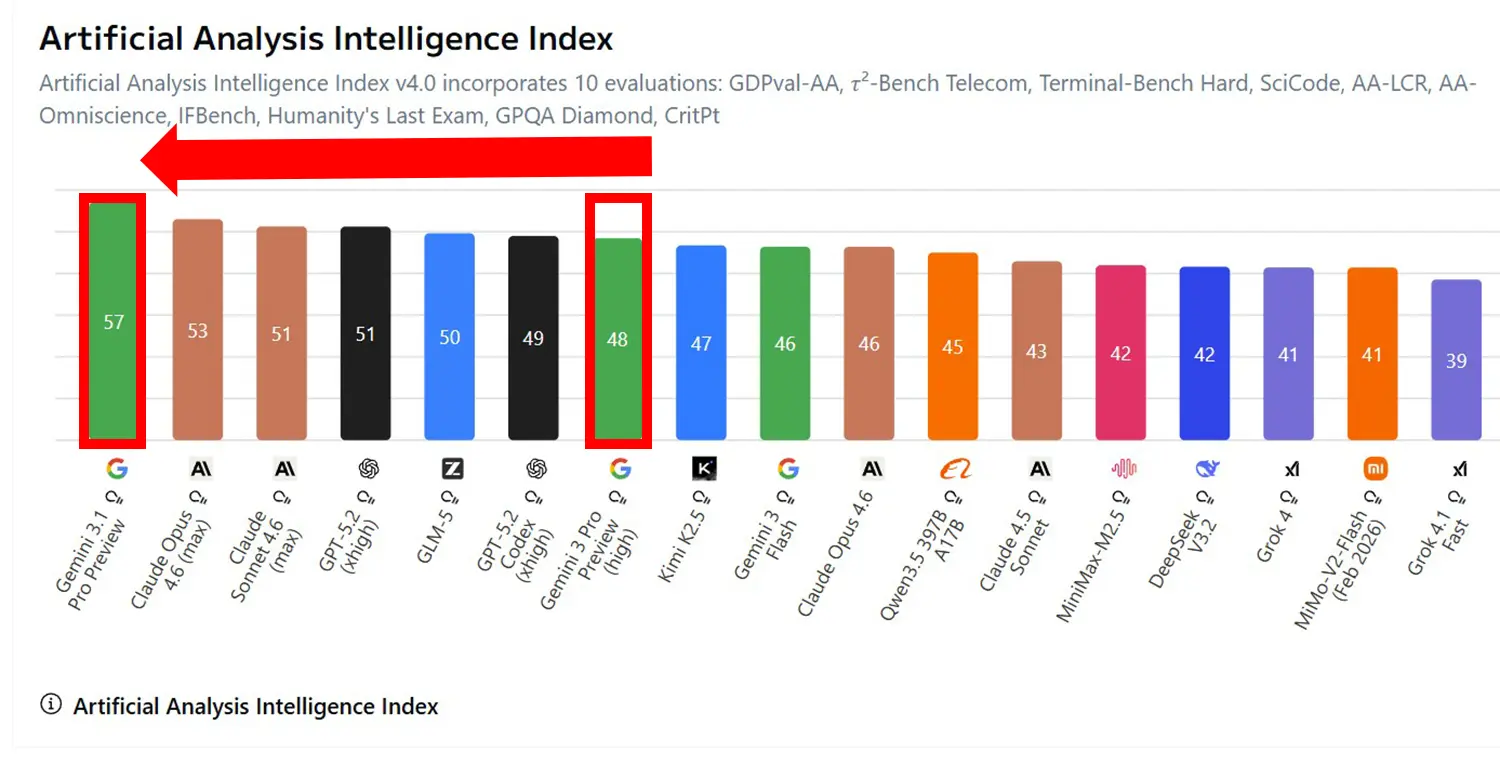

Führende KI-Unternehmen können ihren technologischen Vorsprung am Markt kaum noch verteidigen. Konkurrenzmodelle und Open-Weight-Alternativen schließen durch Methoden wie Model Distillation und gezielte Datenextraktion oft schon innerhalb weniger Wochen zur Leistungsspitze auf.

Anzeige

Kurze Halbwertszeit für neue Systeme

Die Entwicklungszyklen in der künstlichen Intelligenz verdichten sich spürbar. Anthropic präsentierte vor gar nicht langer Zeit Claude Opus 4.6, das mit neuen Funktionen für autonome Agenten ausgestattet ist. Doch der chinesische Konkurrent Zhipu legte kurz darauf mit dem Modell GLM-5 nach. Zusätzlich sind in den letzten 2 Wochen MiniMax 2.5, Seed 2.0, Sonnet 4.6 und ganz aktuelle Gemini 3.1 Pro erschienen.

Open-Weight-Modelle hinken dabei dem "State-of-the-Art" laut einer Analyse von Epoch AI durchschnittlich nur noch drei Monate hinterher. Etablierte Anbieter stehen daher massiv unter Zugzwang. Ihre kostenintensiv trainierten Modelle werden fast unmittelbar nach der Veröffentlichung von günstigeren Alternativen eingeholt.

Quelle: artificialanalysis

Datenextraktion und Klon-Versuche

Ein wesentlicher Grund für das schnelle Aufholen der Konkurrenz sind gezielte Techniken zur Datengewinnung. Entwickler nutzen häufig die Outputs der Marktführer, um die eigenen Systeme zu trainieren. Laut einem internen Memo wirft OpenAI dem chinesischen Entwickler DeepSeek vor, US-Modelle durch sogenanntes Distilling systematisch kopiert zu haben.

Solche Verfahren extrahieren die Logik und das Wissen eines großen Netzes in ein kompaktes, effizienteres Modell.

Auch direkte Angriffe auf die Infrastruktur häufen sich zunehmend. Google registrierte bei Gemini über 100.000 gezielte Prompts, die offensichtlich dem Klonen der Systemarchitektur dienten.

Anbieter versuchen, sich gegen diese Model Extraction abzusichern, stoßen aber auf technische Grenzen. Sobald ein Modell über eine API für Entwickler zugänglich ist, lassen sich dessen Antworten automatisiert abgreifen.

Anzeige

Lokale Ausführung beschleunigt Adaption

Die schnelle Verfügbarkeit von optimierten Versionen verschärft diesen Trend zusätzlich. Plattformen wie Unsloth bieten bereits quantisierte Fassungen von GLM-5 an, die eine lokale Ausführung auf handelsüblicher Hardware ermöglichen.

Die Community adaptiert neue Architekturen in extrem kurzer Zeit. Der exklusive Zugang zu leistungsstarken Modellen schrumpft damit auf ein minimales Zeitfenster zusammen.

Und das Problem an der Sache? Wie sollen die großen US-Anbieter ihre finanziellen Ausgaben jemals wieder einspielen? ...