Googles neues Sprachmodell deklassiert die Konkurrenz

In aktuellen Benchmarks hängt Gemini 3.1 Pro die Modelle von OpenAI und Anthropic deutlich ab und setzt neue Standards.

Google stellt mit Gemini 3.1 Pro ein überarbeitetes KI-Sprachmodell für anspruchsvolle Logik- und Programmieraufgaben vor. Das ab sofort verfügbare Update löst komplexe Probleme deutlich präziser als der Vorgänger und schlägt in den meisten Benchmarks auch die Konkurrenz von OpenAI und Anthropic.

Fokus auf abstrakte Problemlösung

Google positioniert das Modell gezielt für komplexe Anwendungsfälle. Die Entwickler haben die Fähigkeit der Software, eigenständige logische Schlüsse zu ziehen, tiefgreifend überarbeitet. Das Sprachmodell verarbeitet nun umfangreiche Datensätze strukturierter und setzt kreative Vorgaben direkter in funktionierenden Programmcode um. Als Beispiel nennt der Konzern die Aufgabe, die atmosphärische Stimmung eines Romans in das Design einer modernen Web-Oberfläche zu übersetzen – eine Anforderung, die das Modell nun laut Google ohne mühsame Zwischenschritte bewältigt.

Die neue Architektur liefert zudem die technische Basis für das erst kürzlich vorgestellte Modell "Gemini 3 Deep Think". Während sich dieser spezialisierte Ableger primär auf die wissenschaftliche Forschung konzentriert, integriert Google die grundlegenden Verbesserungen von Gemini 3.1 Pro nun in seine breiter aufgestellten Endkunden- und Entwicklerprodukte.

Anzeige

Leistungssprung in den Benchmarks

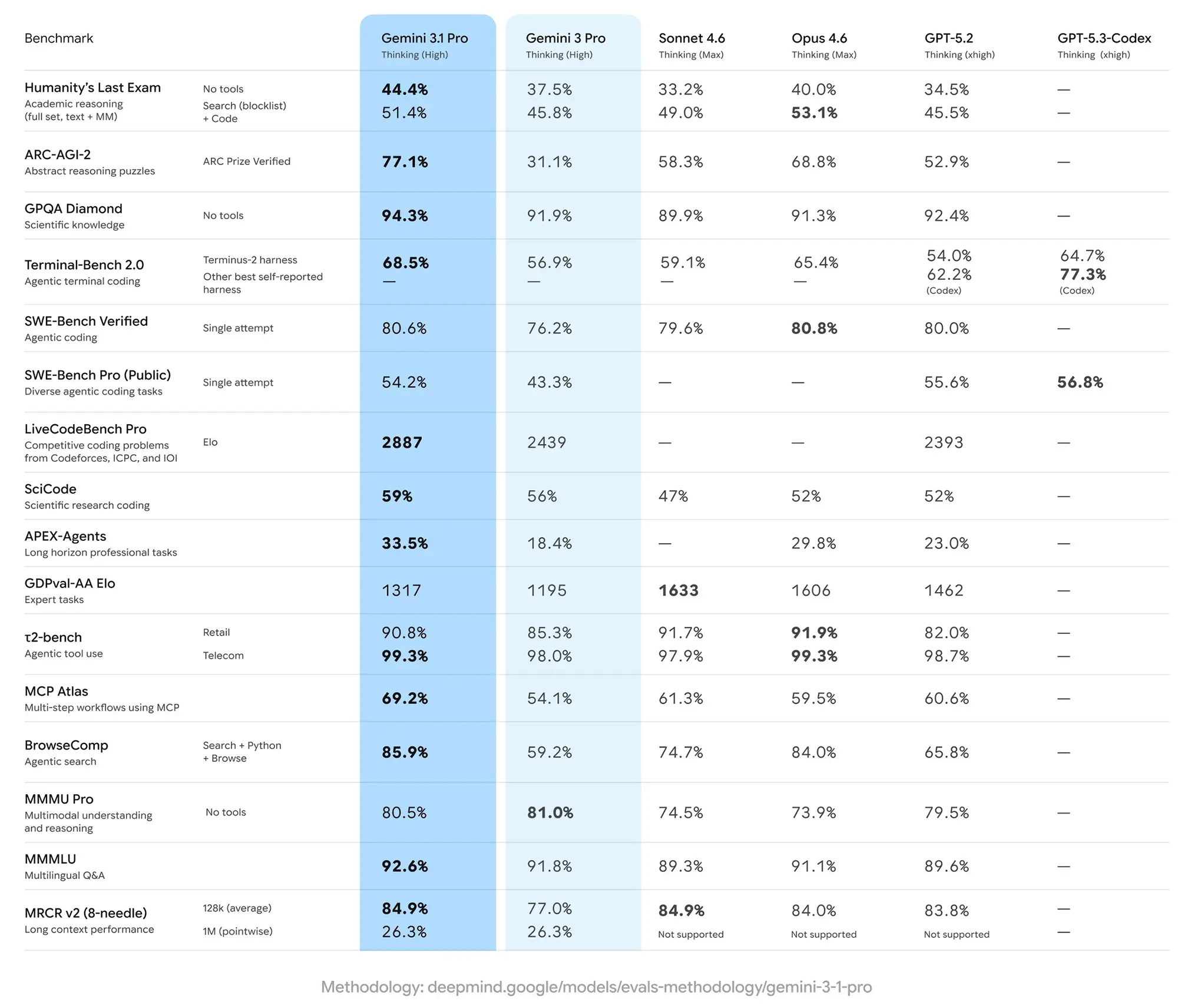

Die technischen Fortschritte spiegeln sich deutlich in aktuellen Leistungstests wider. Beim anspruchsvollen Benchmark "ARC-AGI-2", der die Fähigkeit zur Lösung völlig neuer Logikmuster bewertet, erreicht Gemini 3.1 Pro einen Wert von 77,1 Prozent. Damit verdoppelt das Modell das Ergebnis des Vorgängers Gemini 3 Pro (31,1 Prozent) und verweist Konkurrenten wie Opus 4.6 (68,8 Prozent) sowie GPT-5.2 (52,9 Prozent) auf die hinteren Plätze. Ähnlich dominant zeigt sich die KI beim Test "Humanity's Last Exam" für akademisches Denken, wo sie ohne zusätzliche Hilfsmittel 44,4 Prozent erzielt und damit sowohl das eigene Vorgängermodell als auch die Top-Modelle der Mitbewerber übertrifft.

Auch bei der Code-Generierung und der autonomen Websuche verzeichnet Google messbare Zuwächse. Im Bereich des kompetitiven Programmierens ("LiveCodeBench Pro") steigert sich Gemini 3.1 Pro auf ein Elo-Rating von 2887 und lässt GPT-5.2 (2393) deutlich hinter sich. Bei autonomen Suchaufgaben ("BrowseComp") erreicht das neue Modell 85,9 Prozent und schlägt Opus 4.6 (84,0 Prozent) knapp. Lediglich beim "SWE-Bench Verified" für agentenbasiertes Programmieren ordnet sich die Google-KI mit 80,6 Prozent minimal hinter Opus 4.6 (80,8 Prozent) ein, verbessert sich aber spürbar gegenüber der Version 3 Pro.

Quelle: Google

Verfügbarkeit und Zielgruppen

Entwickler greifen ab sofort über das Google AI Studio und "Google Antigravity auf die 3.1er Version zu. Für den Einsatz im professionellen Umfeld steht das Modell in Vertex AI sowie Gemini Enterprise bereit.

Privatnutzer erhalten ebenfalls Zugang, sofern sie ein kostenpflichtiges Abonnement besitzen. Gemini 3.1 Pro wird aktuell mit höheren Nutzungslimits in der Gemini-App sowie in NotebookLM für Kunden der Tarife Google AI Pro und Ultra ausgerollt.