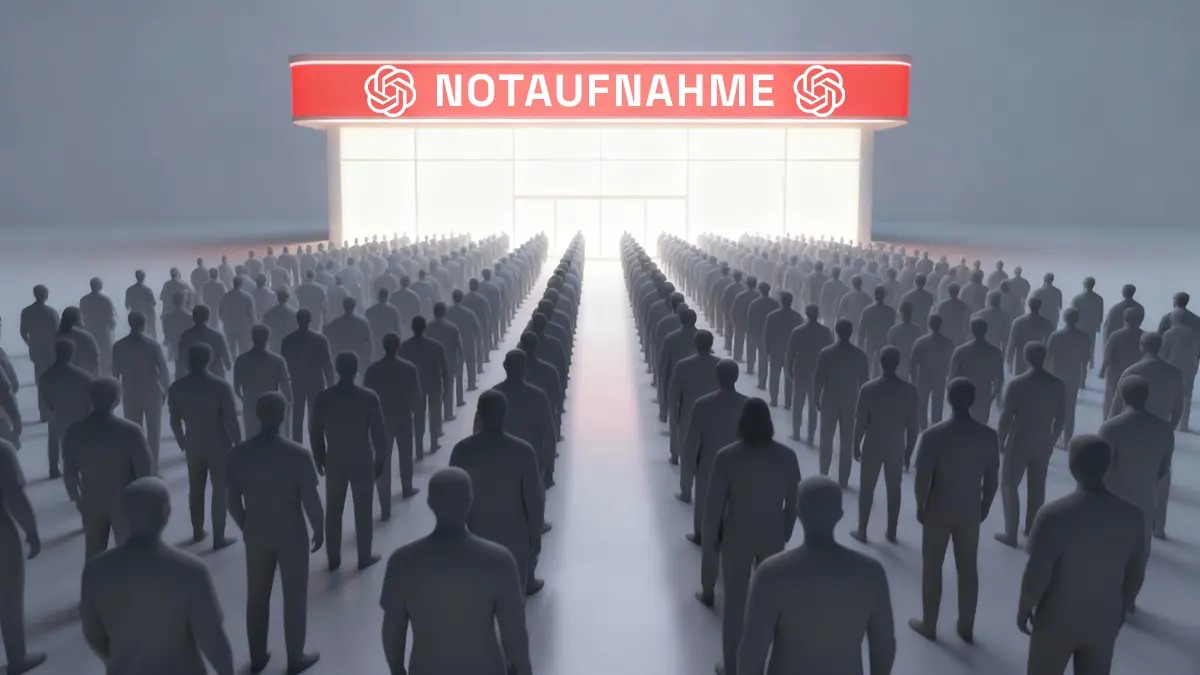

OpenAI schlägt Alarm

Warum 170 Psychologen jetzt GPT-5 trainieren müssen, um Leben zu retten

Über 1,2 Millionen Gespräche pro Woche auf ChatGPT drehen sich um Suizidabsichten. Das KI-Unternehmen OpenAI hat erstmals Schätzungen veröffentlicht, wie viele Nutzer in psychischen Krisen stecken. Die Zahlen sind alarmierend und zwingen das Unternehmen zum Handeln bei der Sicherheit seiner Modelle.

Das Ausmaß der mentalen Krise

Die neuen Daten von OpenAI zeichnen ein düsteres Bild. Das Unternehmen schätzt, dass wöchentlich rund 1,2 Millionen Nutzer Gespräche mit expliziten Hinweisen auf Suizidabsichten führen. Diese Interaktionen gehen über vage Andeutungen hinaus und zeigen eine akute Notlage. Die KI wird offenbar als anonymer, immer verfügbarer Ansprechpartner gesehen.

Hinzu kommt eine weitere besorgniserregende Gruppe. Rund 560.000 Nutzer zeigen laut den Schätzungen jede Woche Anzeichen von Psychosen oder Manien. Diese Zahlen hat OpenAI erstmals in dieser Form offengelegt und in einem Addendum zur System Card von GPT-5 veröffentlicht. Sie werfen ein Schlaglicht darauf, wie intensiv Menschen die KI für tief persönliche Themen nutzen.

GPT-5 soll sicherer werden

OpenAI reagiert auf diese Erkenntnisse mit einer gezielten Verbesserung seiner Modelle. Das Unternehmen arbeitet dafür mit einem großen Team von über 170 Psychiatern und Psychologen zusammen. Diese Experten helfen dabei, das verbesserte GPT-5-Modell zu trainieren, indem sie Feedback zu den KI-Antworten geben.

Das Ziel ist es, die Antworten der KI in kritischen Momenten sicherer zu machen. Die KI soll erkennen, wann ein Nutzer professionelle Hilfe benötigt, und angemessen reagieren. Es geht darum, schädliche Ratschläge zu vermeiden und die Krise nicht zu verschlimmern, sondern auf echte Hilfsangebote zu verweisen.

Erste Erfolge bei den Sicherheitschecks

Die Zusammenarbeit mit den Fachleuten zeigt bereits Wirkung. Laut OpenAI konnte das neue Modell unerwünschte Antworten in kritischen Situationen deutlich reduzieren. Die Verbesserung liegt je nach Szenario zwischen 39 und 52 Prozent. Das Training hilft der KI, die Nuancen menschlicher Notlagen besser zu verstehen.

Besonders bei Gesprächen über Suizid zeigt sich ein messbarer Fortschritt. Das verbesserte Modell entspricht nun in 91 Prozent der Fälle den internen Sicherheitsrichtlinien von OpenAI. Bei vorherigen Versionen lag dieser Wert bei nur 77 Prozent. Die KI ist also zuverlässiger darin geworden, keine gefährlichen Inhalte zu generieren.

Die Daten verdeutlichen die immense Verantwortung, die KI-Entwickler tragen, wenn ihre Technologie unerwartet zum Ansprechpartner für Menschen in Not wird.