Meta SAM 3 ist da: So stark verbessert sich die Bilderkennung

Neue KI-Modelle verstehen Videos per Textbefehl und erstellen 3D-Objekte aus simplen Fotos.

Meta bringt mit SAM 3 und SAM 3D zwei neue Open-Source-Modelle auf den Markt. Die Software versteht Inhalte in Videos präziser als bisher und wandelt flache Fotos in räumliche Objekte um. Entwickler erhalten damit mächtige Werkzeuge für Robotik, Videobearbeitung und Augmented Reality.

Sprung in der visuellen Wahrnehmung

Das ursprüngliche Segment Anything Model (SAM) setzte Standards bei der Freistellung von Objekten in Standbildern. Die dritte Version geht nun einen entscheidenden Schritt weiter. SAM 3 verknüpft visuelle Daten eng mit Sprache. Nutzer markieren Objekte in Videos nicht mehr zwingend per Mausklick. Ein einfacher Textbefehl reicht aus. Die Software identifiziert das gesuchte Element, schneidet es frei und verfolgt es über die gesamte Videolaufzeit hinweg.

Die Stärke liegt im sogenannten offenen Vokabular. Das Modell erkennt Konzepte und Gegenstände, die während des Trainings nicht explizit definiert waren. Zeigt ein Video eine seltene Hunderasse, genügt der Oberbegriff oder eine Umschreibung. SAM 3 analysiert den visuellen Kontext und ordnet die Pixel korrekt zu. Diese Flexibilität fehlte früheren Versionen oft. Roboter profitieren hiervon besonders, da sie in unstrukturierten Umgebungen auf unbekannte Objekte reagieren müssen.

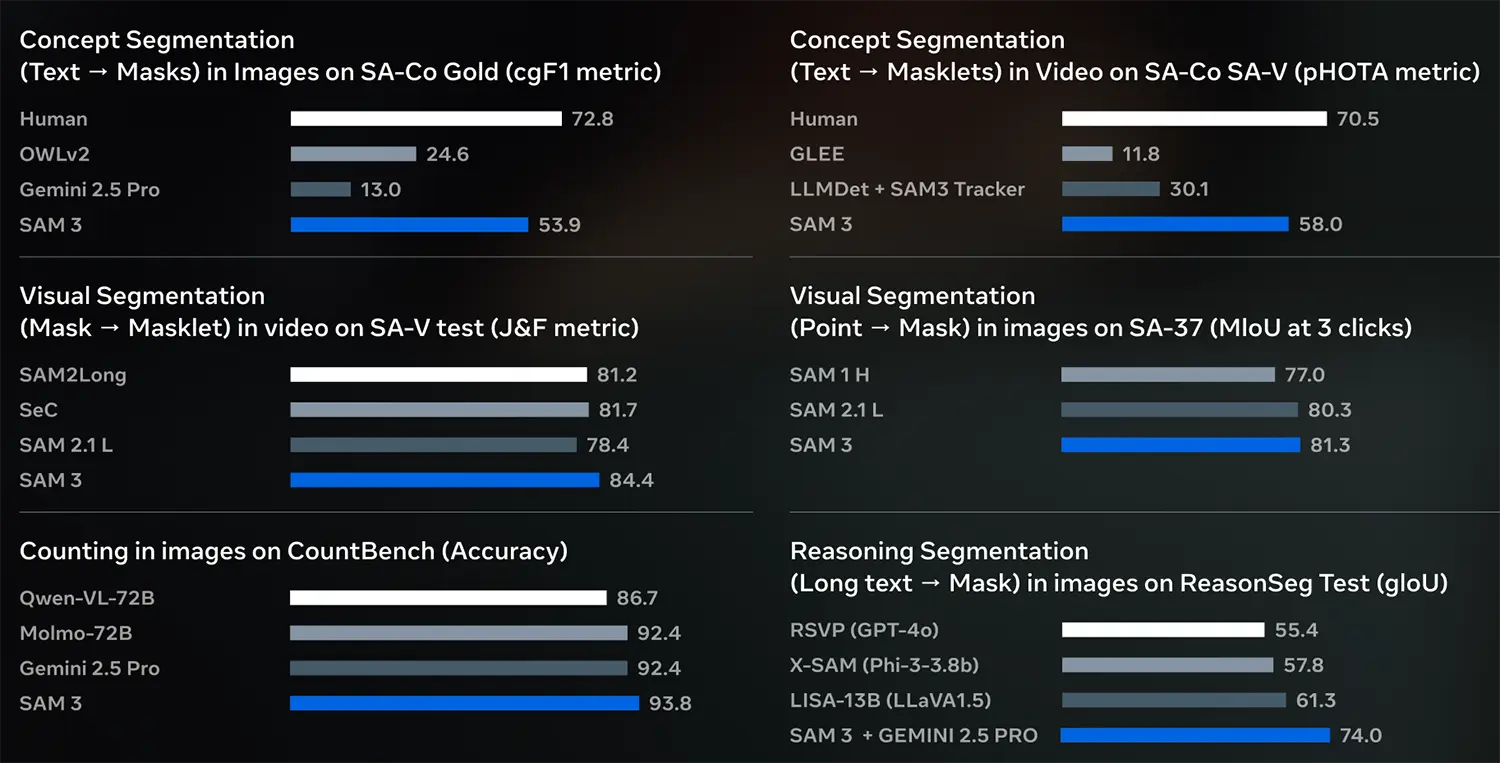

Quelle: Meta

Dreidimensionale Welten aus einem Foto

Parallel zu SAM 3 führt Meta das Modell SAM 3D ein. Diese Technologie adressiert ein altes Problem der Computergrafik: den hohen Aufwand der 3D-Modellierung. SAM 3D generiert aus einem einzigen 2D-Bild ein räumliches Netzgitter. Die KI schätzt dabei die Tiefe und die verdeckte Rückseite eines Objekts.

Der Prozess dauert nur wenige Sekunden. Ein Nutzer lädt ein Foto eines Stuhls hoch. SAM 3D analysiert die Geometrie und erstellt ein drehbares, digitales Objekt. Spieleentwickler und Designer sparen durch diesen Automatismus viel Zeit. Auch für Virtual-Reality-Anwendungen senkt dies die Hürde, echte Umgebungen schnell zu digitalisieren. Die Qualität der Texturen und die geometrische Genauigkeit übertreffen dabei bisherige Lösungen, die oft mehrere Kamerawinkel benötigten.

Offener Quellcode für schnelle Verbreitung

Meta bleibt seiner Strategie treu und stellt beide Modelle als Open Source zur Verfügung. Der Konzern veröffentlicht den Code sowie die Gewichtungen auf GitHub. Forscher und Unternehmen können die Technologie lizenzfrei nutzen und weiterentwickeln. Dieser Schritt zielt darauf ab, den Industriestandard für Computer Vision weiter zu diktieren.

Die Integration von SAM 3 in bestehende Workflows verläuft nahtlos. Das Modell akzeptiert multimodale Eingaben. Neben Text und Bildern verarbeitet es auch visuelle Hinweise wie Punkte oder Boxen, die ein Nutzer über ein Objekt legt. Diese Vielseitigkeit macht die Modelle für eine breite Palette an Anwendungen interessant – von der automatischen Videoüberwachung bis zur medizinischen Bildanalyse. Mit diesem Update festigt Meta seine Position in der KI-Entwicklung und liefert die Basis für die nächste Generation sehender Maschinen.