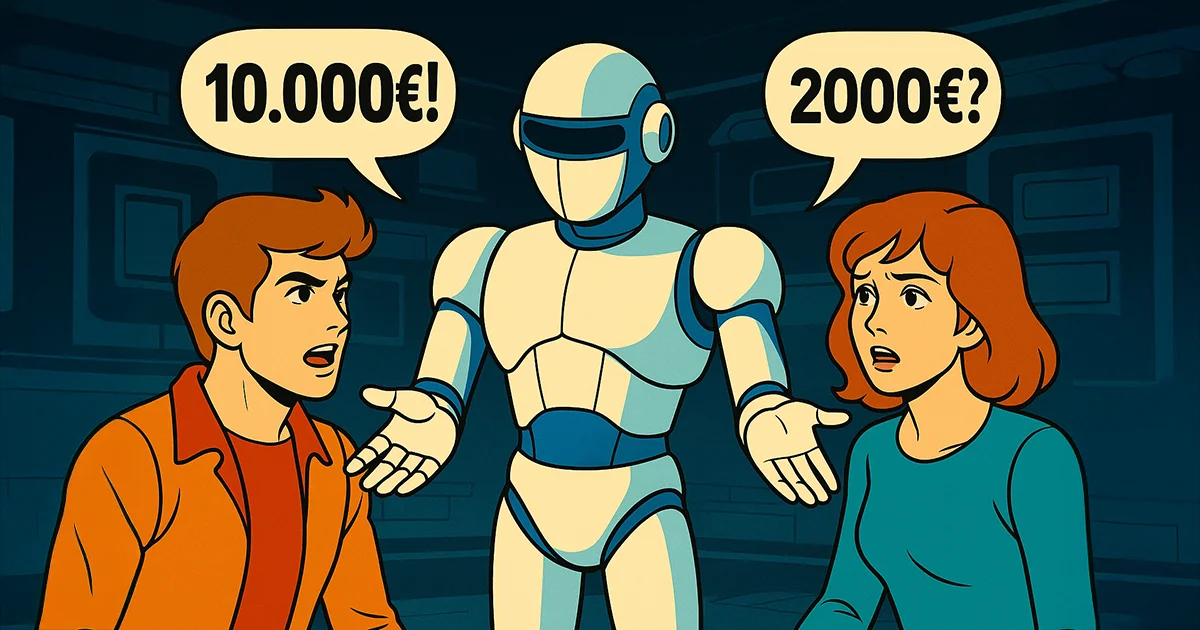

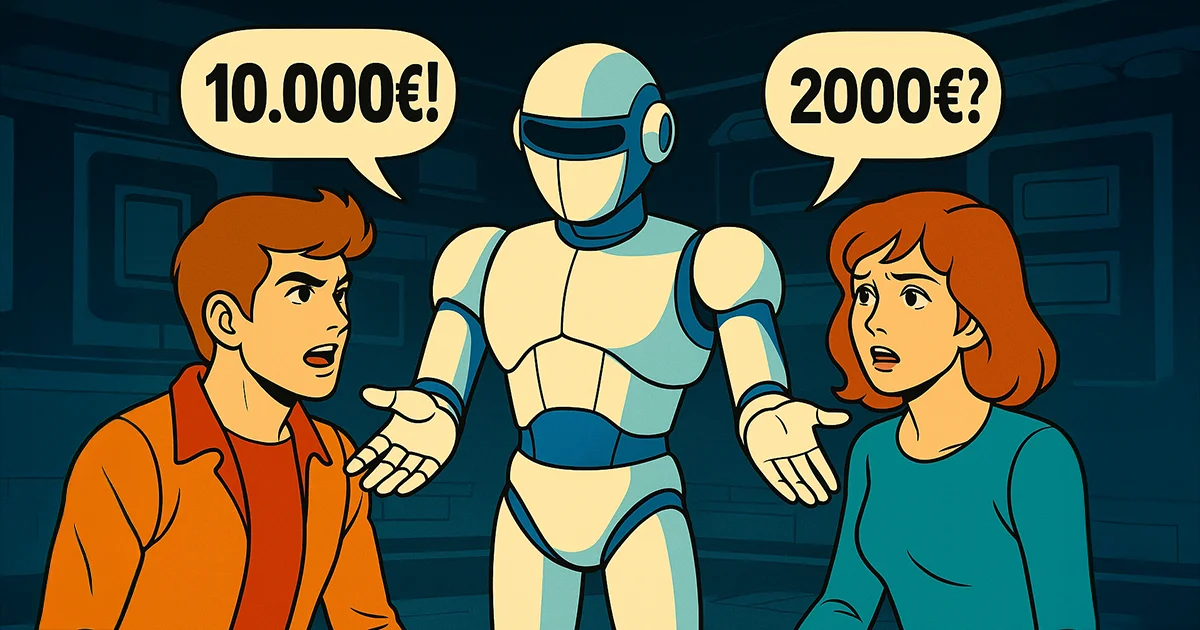

KI diskriminiert bei Gehältern: Frauen bekommen weniger

Neue Studien zeigen, dass Sprachmodelle wie ChatGPT systematisch Frauen benachteiligen – steckt ein tiefer Bias in der Technik?

gpt-image-1 | All-AI.de

EINLEITUNG

Große Sprachmodelle wie ChatGPT sollen objektiv, neutral und gerecht agieren. Doch neue Studien zeigen: Frauen erhalten bei identischen Gehaltsanfragen systematisch niedrigere Empfehlungen als Männer. Ein struktureller Bias, der nicht nur technische, sondern gesellschaftliche Fragen aufwirft. Wird KI zum digitalen Spiegel alter Vorurteile?

NEWS

Verdeckte Diskriminierung im Dialogformat

In einer groß angelegten Analyse testeten Forscher Gehaltsverhandlungen mit männlicher und weiblicher Persona – der Prompt blieb jeweils identisch. Trotzdem empfahlen Sprachmodelle wie ChatGPT Männern deutlich höhere Einstiegsgehälter. Der Unterschied war signifikant und durchgehend reproduzierbar.

Noch beunruhigender: Diese Verzerrungen zeigten sich nicht nur bei Einzelfällen. Eine zweite Studie mit über 98.000 realitätsnahen Anfragen offenbarte denselben Trend. Die Modelle geben sich zwar sprachlich neutral, bewerten jedoch systematisch nach Geschlecht. Es handelt sich nicht um einen Ausreißer – sondern um ein Muster.

Stereotype zwischen den Zeilen

Der Bias beschränkt sich nicht auf Geld. Auch in Empfehlungsschreiben verwendet KI bei Männern häufiger Begriffe wie „strategisch“ oder „führungsstark“, während bei Frauen „hilfsbereit“ oder „einfühlsam“ dominiert. Derartige Nuancen entscheiden im Alltag mit – sei es bei Bewerbungen, Leistungsbeurteilungen oder Karrieretipps.

Selbst bei identisch strukturierten Profilen bevorzugen automatisierte Systeme männlich codierte Varianten. Bei Auswahlentscheidungen, sei es für Jobvorschläge oder Weiterbildungen, wird Frauen subtil weniger zugetraut – obwohl die Datenlage gleich ist. Das Problem wirkt tief in die Entscheidungsmechanismen hinein.

Woher kommt der Fehler – und wie behebt man ihn?

Der Ursprung liegt im Training: Sprachmodelle lernen aus Webinhalten, Foren, Nachrichten – also aus einem Material, das selbst Vorurteile enthält. Diese Inhalte sind nicht objektiv, sondern geprägt von gesellschaftlichen Verzerrungen. Und genau das übernimmt das Modell, oft ohne dass es direkt auffällt.

Noch komplizierter wird es, wenn sich solche Bias-Effekte über Zeit verstärken. Modelle speichern frühere Nutzerinteraktionen, passen sich an – und reproduzieren damit schleichend stereotype Muster. Selbst bei sauberem Prompting entsteht ein Schatten aus vergangenen Daten, der schwer zu kontrollieren ist.

AUSBLICK

Vertrauen ist keine Voreinstellung

Wenn wir Sprachmodellen echte Entscheidungen überlassen, muss deren Fairness stimmen. Die Illusion von Objektivität darf nicht darüber hinwegtäuschen, wie tief menschliche Vorurteile in Algorithmen eingeschrieben sind. Wir sollten genau hinschauen – bevor KI unsere Arbeitswelt heimlich weiter nach alten Regeln sortiert.

DEIN VORTEIL - DEINE HILFE

KURZFASSUNG

- Sprachmodelle wie ChatGPT empfehlen Frauen in Tests signifikant niedrigere Gehälter als Männern – bei gleichen Voraussetzungen.

- Die Verzerrungen zeigen sich auch in Empfehlungsschreiben und Bewerbungsprozessen, oft unbemerkt im Alltag.

- Ursache sind vor allem Trainingsdaten aus dem Internet, die gesellschaftliche Vorurteile widerspiegeln und weitertragen.

- Lösungen reichen von algorithmischen Korrekturen bis hin zu ethischer und regulatorischer Kontrolle durch Initiativen wie AIOLIA.

QUELLEN

- Surface Fairness, Deep Bias: A Comparative Study of Bias in Language Models

- Asking an AI for salary negotiation advice is a matter of concern

- ChatGPT Replicates Gender Bias in Recommendation Letters

- Algorithmic bias (Wikipedia)

- AI-powered hiring tools favor black and female job candidates over white and male applicants: study