KI-Hack? Wie DeepSeek OpenAIs Wissen schrumpft – und nutzt!

Die Distillation-Technik macht aus riesigen Modellen kleine, schnelle Varianten. Doch wo liegt die Grenze zwischen kluger Optimierung und dreistem Diebstahl?

Flux Schnell | All-AI.de

EINLEITUNG

In der dynamischen Welt der Künstlichen Intelligenz (KI) suchen Unternehmen ständig nach Wegen, ihre Modelle effizienter und kosteneffektiver zu gestalten. Eine Technik, die dabei zunehmend an Bedeutung gewinnt, ist die sogenannte "Distillation". Dieses Verfahren ermöglicht es, große, leistungsstarke KI-Modelle zu "destillieren" und deren Wissen auf kleinere, ressourcenschonendere Modelle zu übertragen. Doch wie funktioniert diese Methode genau, und welche Auswirkungen hat sie auf die KI-Branche?

NEWS

Was ist Distillation?

Bei der Distillation, auch Wissensdistillation genannt, handelt es sich um einen Prozess, bei dem ein großes, vortrainiertes Modell (das "Lehrermodell") genutzt wird, um ein kleineres Modell (das "Schülermodell") zu trainieren. Das Lehrermodell generiert Vorhersagen oder "weiche" Zielwerte, die dann als Trainingsdaten für das Schülermodell dienen. Auf diese Weise kann das Schülermodell die Leistung des größeren Modells nachahmen, jedoch mit deutlich weniger Parametern und somit geringerem Rechenaufwand. Diese Technik ermöglicht es, effiziente Modelle zu entwickeln, die auf Geräten mit begrenzten Ressourcen, wie Smartphones oder Laptops, eingesetzt werden können.

DeepSeeks Vorstoß in der Distillation

Die chinesische KI-Firma DeepSeek hat kürzlich mit der Anwendung der Distillation-Technik auf sich aufmerksam gemacht. Durch die Nutzung von Open-Source-Systemen, die von Unternehmen wie Meta und Alibaba bereitgestellt wurden, gelang es DeepSeek, leistungsstarke und effiziente KI-Modelle zu entwickeln. Dieser Ansatz führte zu einem erheblichen Umbruch im Vertrauen in die Führungsposition des Silicon Valley im Bereich der KI, was wiederum dazu führte, dass Milliarden von Dollar an Wert bei US-amerikanischen Technologiewerten verloren gingen.

Reaktionen der Branche

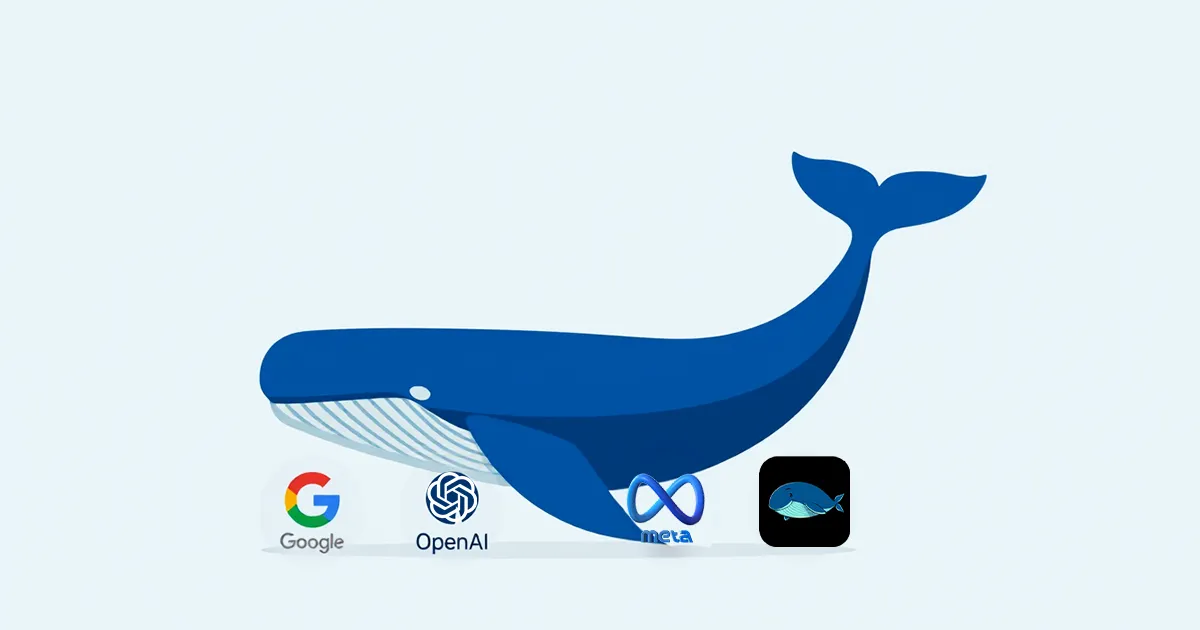

Die Anwendung der Distillation-Technik durch DeepSeek hat in der Branche für Aufsehen gesorgt. Unternehmen wie OpenAI, Microsoft und Meta sehen sich nun mit der Herausforderung konfrontiert, ihre Geschäftsmodelle anzupassen. Während große Sprachmodelle wie OpenAIs GPT-4, Googles Gemini und Metas Llama immense Datenmengen und Rechenleistung für ihre Entwicklung benötigen, ermöglicht die Distillation die Erstellung effizienterer Modelle mit geringeren Ressourcen. Dies könnte dazu führen, dass kleinere Unternehmen und Start-ups in der Lage sind, konkurrenzfähige KI-Anwendungen zu entwickeln, ohne die enormen Investitionen tätigen zu müssen, die bisher erforderlich waren.

Herausforderungen und ethische Überlegungen

Obwohl die Distillation-Technik viele Vorteile bietet, wirft sie auch Fragen hinsichtlich des geistigen Eigentums und der Ethik auf. OpenAI hat Bedenken geäußert, dass DeepSeek möglicherweise ihre Modelle genutzt hat, um eigene KI-Systeme zu entwickeln, was gegen die Nutzungsbedingungen von OpenAI verstoßen würde. Die Überwachung und Durchsetzung solcher Richtlinien gestaltet sich jedoch als schwierig, insbesondere wenn es darum geht, kleine Distillationsvorgänge unter Millionen von Nutzern zu erkennen.

AUSBLICK

Mit Innovation zum Erfolg

Die zunehmende Anwendung der Distillation-Technik könnte die KI-Landschaft nachhaltig verändern. Einerseits ermöglicht sie es, leistungsstarke KI-Modelle effizienter und kostengünstiger zu gestalten, was die Verbreitung von KI-Anwendungen fördern könnte. Andererseits stellt sie etablierte Unternehmen vor die Herausforderung, ihre Geschäftsmodelle zu überdenken und sich an die neuen Gegebenheiten anzupassen. Es bleibt abzuwarten, wie sich die Branche entwickelt und welche neuen Innovationen aus diesem Paradigmenwechsel hervorgehen werden.

UNTERSTÜTZUNG

Hat dir ein Artikel gefallen oder ein Tutorial geholfen? Du kannst uns weiterhelfen, indem du diese Seite weiterempfiehlst, uns auf Youtube abonnierst oder dich per Paypal an den Serverkosten beteiligst. Wir sind für jede Unterstützung dankbar. Danke.

KURZFASSUNG

- DeepSeek nutzt die Distillation-Technik, um große KI-Modelle zu verkleinern und effizienter zu machen – eine Strategie, die die KI-Welt aufmischt.

- Durch Open-Source-Modelle von Meta und Alibaba konnte DeepSeek seine eigenen KI-Modelle optimieren, was zu Spannungen mit US-KI-Unternehmen führt.

- OpenAI und andere Firmen befürchten, dass DeepSeek möglicherweise auf unlautere Weise bestehende Modelle nutzt, um eigene Versionen zu erstellen.

- Die Distillation-Technik könnte die KI-Branche nachhaltig verändern, indem sie leistungsstarke, aber ressourcenschonende Modelle ermöglicht – und kleinere Unternehmen konkurrenzfähig macht.