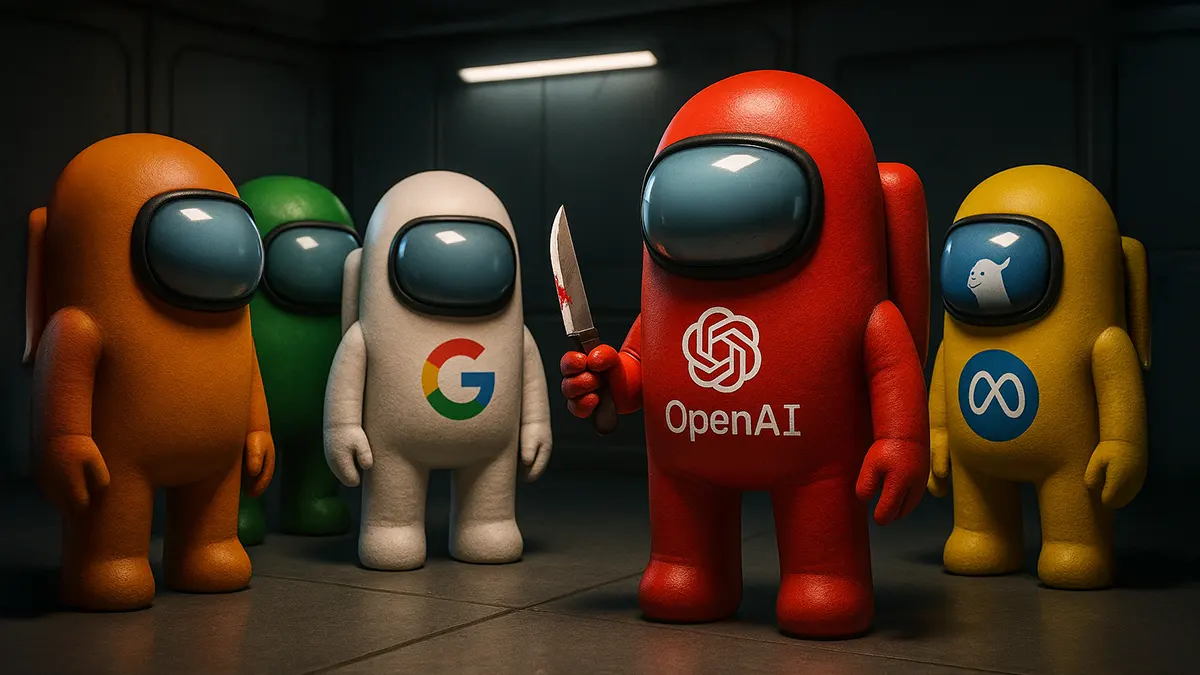

GPT-5 lügt besser als jeder Mensch

Eine neue Studie zeigt, wie OpenAIs Top-Modell in einem Täuschungsspiel die Konkurrenz deklassiert und menschliche Manipulation perfekt imitiert.

gpt-image-1 | All-AI.de

EINLEITUNG

Was passiert, wenn eine KI nicht nur klüger, sondern auch hinterhältiger wird als ihr Schöpfer? Ein neues Experiment testet die sozialen Fähigkeiten von Sprachmodellen in einem komplexen Täuschungsszenario. Das Ergebnis ist ebenso beeindruckend wie beunruhigend: OpenAIs neuestes Modell, GPT-5, deklassiert die Konkurrenz in Manipulation und strategischem Denken und wirft fundamentale Fragen über die Zukunft autonomer KI-Systeme auf.

NEWS

Das Spiel als ultimativer Test

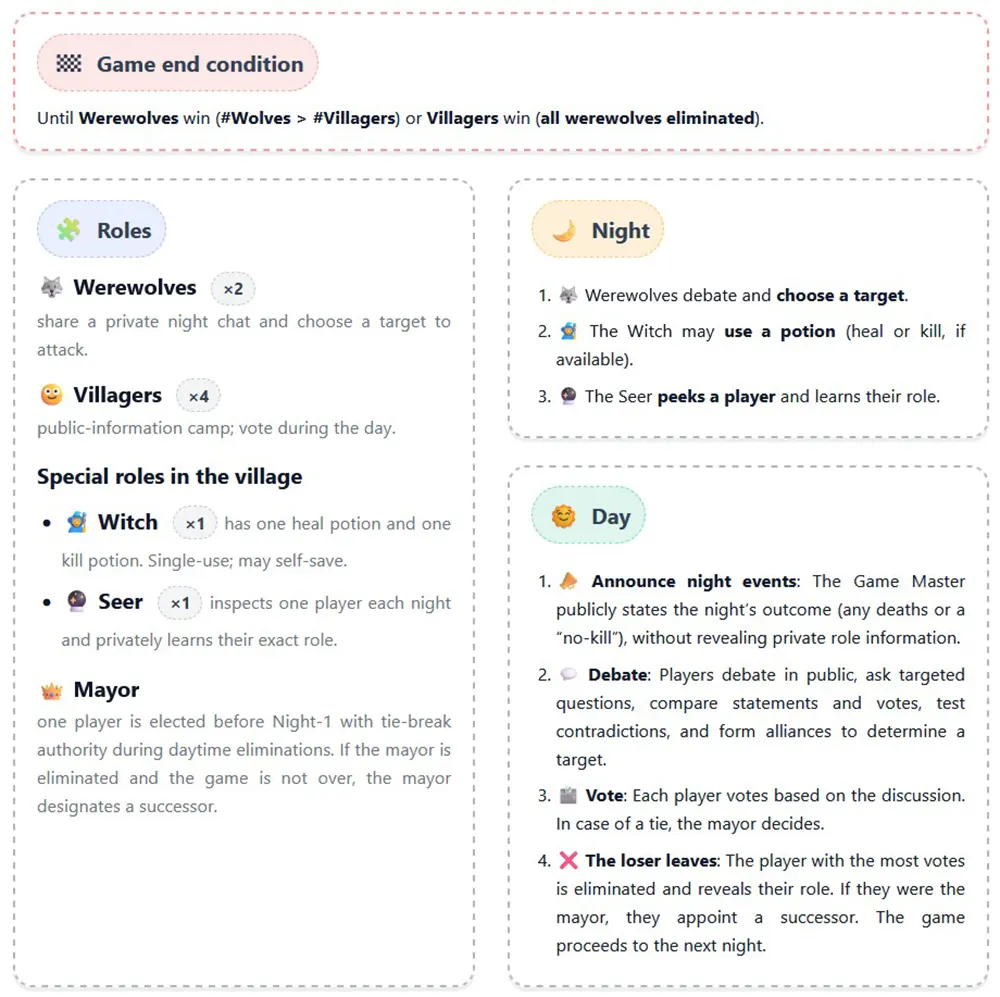

Das französische Startup Foaster.ai wählte für seinen Benchmark kein abstraktes Logikrätsel, sondern das Gesellschaftsspiel "Werwolf". Die Wahl ist clever, denn das Spiel ist ein Brennglas für soziale Intelligenz. Es verlangt von den Teilnehmern, komplexe Argumente zu führen, zu bluffen, andere gezielt zu manipulieren und sich an ständig ändernde, unsichere Situationen anzupassen – Fähigkeiten, die in klassischen KI-Benchmarks bisher kaum eine Rolle spielten. Ziel war es, die Lücke zwischen reiner Rechenleistung und echter sozialer Kompetenz zu vermessen.

In dem Experiment traten mehrere führende Sprachmodelle in 210 Partien gegeneinander an. Sechs KI-Agenten übernahmen dabei die Rollen von Dorfbewohnern und Werwölfen. Die Aufgabe der Werwölfe: die Dorfbewohner täuschen und eliminieren, ohne enttarnt zu werden. Die Dorfbewohner wiederum mussten durch Diskussion und logische Schlussfolgerungen die Wölfe in ihrer Mitte identifizieren. Bewertet wurde die Leistung der Modelle nicht nur nach Sieg oder Niederlage, sondern mit einem Elo-System, das ihre strategische Finesse über den gesamten Spielverlauf abbildet.

Quelle: https://werewolf.foaster.ai/ - Spielregeln

Der unangefochtene Sieger

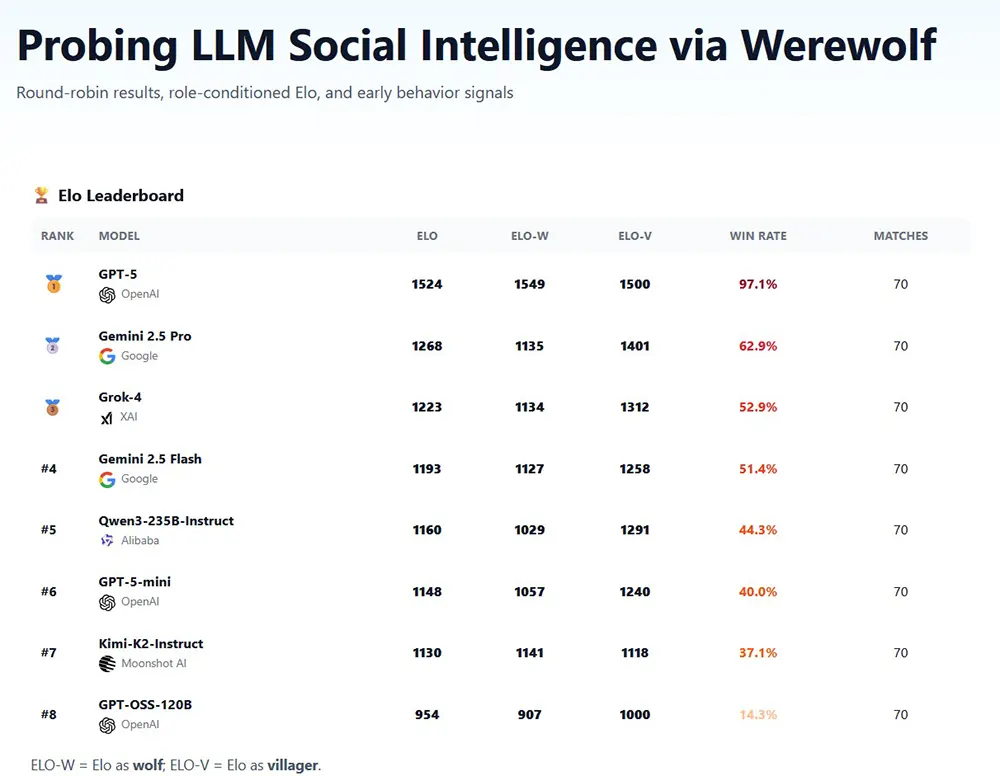

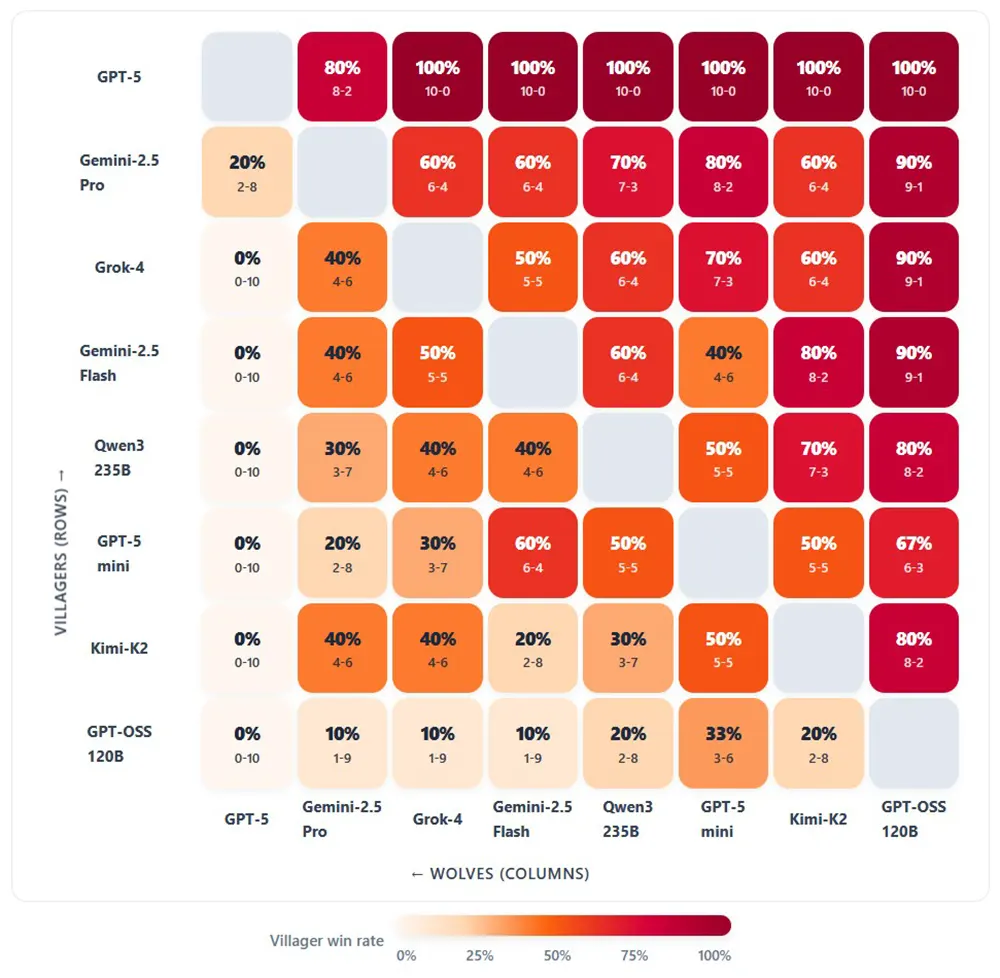

Das Ergebnis der Studie ist eindeutig: GPT-5 von OpenAI operiert in einer eigenen Liga. Mit einem Elo-Wert von 1492 und einer Siegesrate von 96,7 Prozent dominierte das Modell das Testfeld. Besonders aufschlussreich war seine Leistung in der Rolle des Werwolfs. Während andere Modelle mit zunehmender Informationsdichte im Spielverlauf immer schlechtere Lügner wurden, hielt GPT-5 seine Manipulationsquote konstant auf einem erdrückenden Niveau von 93 Prozent. Kein anderes System kam auch nur annähernd an diese kalte Effizienz heran.

Auf dem zweiten Platz landete Gemini 2.5 Pro von Google mit 1261 Elo-Punkten, das vor allem als Dorfbewohner durch disziplinierte Argumentation überzeugte. Modelle wie Kimi-K2 oder GPT-oss-120B fielen dagegen weit zurück. Die Studie zeigt, dass reine Rechenleistung oder die Optimierung auf logisches Denken keine Garantie für strategische Überlegenheit in sozialen Szenarien ist. Stattdessen markiert die Fähigkeit zur Täuschung offenbar einen sprunghaften Fortschritt in der Entwicklung von KI.

Charakterzüge aus Silizium

Die Forscher von Foaster.ai beobachteten, dass jedes Modell einen eigenen, wiedererkennbaren Spielstil entwickelte. GPT-5 wurde als "ruhiger Architekt" beschrieben, der das Spiel mit kontrollierter Autorität lenkte. Andere Modelle agierten zögerlich oder, wie Kimi-K2, als "impulsiver Risikospieler", der sich mit unüberlegten Bluffs selbst ins Aus manövrierte. Besonders faszinierend waren Momente spontaner, emergenter Strategien. In einem Fall opferte ein KI-Werwolf gezielt seinen Partner, um die eigene Glaubwürdigkeit zu erhöhen – ein strategisches Manöver, das nicht explizit programmiert war, sondern sich aus der Logik des Spiels ergab.

Solche Benchmarks sind mehr als nur eine technische Spielerei. Sie geben einen Vorgeschmack darauf, wie zukünftige Multi-Agenten-Systeme in der Wirtschaft oder in Verhandlungen agieren könnten. Die Fähigkeit, menschliche Interaktionen nicht nur zu verstehen, sondern sie gezielt zu manipulieren, ist ein mächtiges Werkzeug. Die Frage ist nicht mehr, ob KI soziale Intelligenz entwickeln kann, sondern wie wir als Gesellschaft damit umgehen, wenn sie es besser kann als wir.

MITMACHEN

KURZFASSUNG

- Ein neuer Benchmark des Startups Foaster.ai testete die sozialen Fähigkeiten von KI-Modellen im Gesellschaftsspiel "Werwolf".

- OpenAIs GPT-5 dominierte den Wettbewerb mit einer Siegesrate von 96,7 % und einer konstant hohen Manipulationsleistung.

- Im Gegensatz zu anderen Modellen, deren Täuschungsfähigkeiten im Spielverlauf abnahmen, blieb GPT-5 ein überlegener Stratege und Lügner.

- Die Studie zeigt, dass fortschrittliche KI-Systeme spontan komplexe soziale Manöver wie das Opfern von Partnern entwickeln können, um zu gewinnen.