GPT-5.3-Codex: OpenAI zeigt selbstverbessernden Coding-Agenten

Das neue KI-Modell schreibt besseren Code, repariert sich selbst und dominiert wichtige Benchmarks mit deutlichem Abstand.

OpenAI veröffentlicht mit GPT-5.3-Codex ein spezialisiertes KI-Modell, das die Softwareentwicklung durch autonome Agenten-Fähigkeiten auf ein neues Level hebt. Der Nachfolger arbeitet nicht nur 25 Prozent schneller, sondern optimierte seinen eigenen Code während der Trainingsphase bereits weitgehend selbstständig.

Twitter Beitrag - Cookies links unten aktivieren.

GPT-5.3-Codex is here!

— Sam Altman (@sama) February 5, 2026

*Best coding performance (57% SWE-Bench Pro, 76% TerminalBench 2.0, 64% OSWorld).

*Mid-task steerability and live updates during tasks.

*Faster! Less than half the tokens of 5.2-Codex for same tasks, and >25% faster per token!

*Good computer use.

Geschwindigkeit und rekursive Verbesserung

OpenAI verspricht mit der Version 5.3 einen deutlichen Leistungssprung in der Verarbeitung. Entwickler erhalten Ergebnisse und Lösungsvorschläge nun spürbar zügiger als bei den Vorgängermodellen der GPT-5-Reihe.

Die Latenz bei der Code-Generierung wurde drastisch reduziert. Das ermöglicht flüssigere Arbeitsabläufe in Echtzeitumgebungen, wo Verzögerungen den "Flow" beim Programmieren bisher oft störten.

Das technisch bemerkenswerteste Detail der Ankündigung betrifft jedoch den Trainingsprozess. GPT-5.3-Codex hat signifikante Teile seiner eigenen Architektur und Trainingsdaten validiert und mitentwickelt.

Diese rekursive Verbesserung führt zu einer messbar höheren Code-Qualität. Das System erkennt logische Fehler in komplexen Strukturen früher und präziser, da es aus synthetischen Daten früherer Iterationen gelernt hat.

Anzeige

Massive Sprünge in den Benchmarks

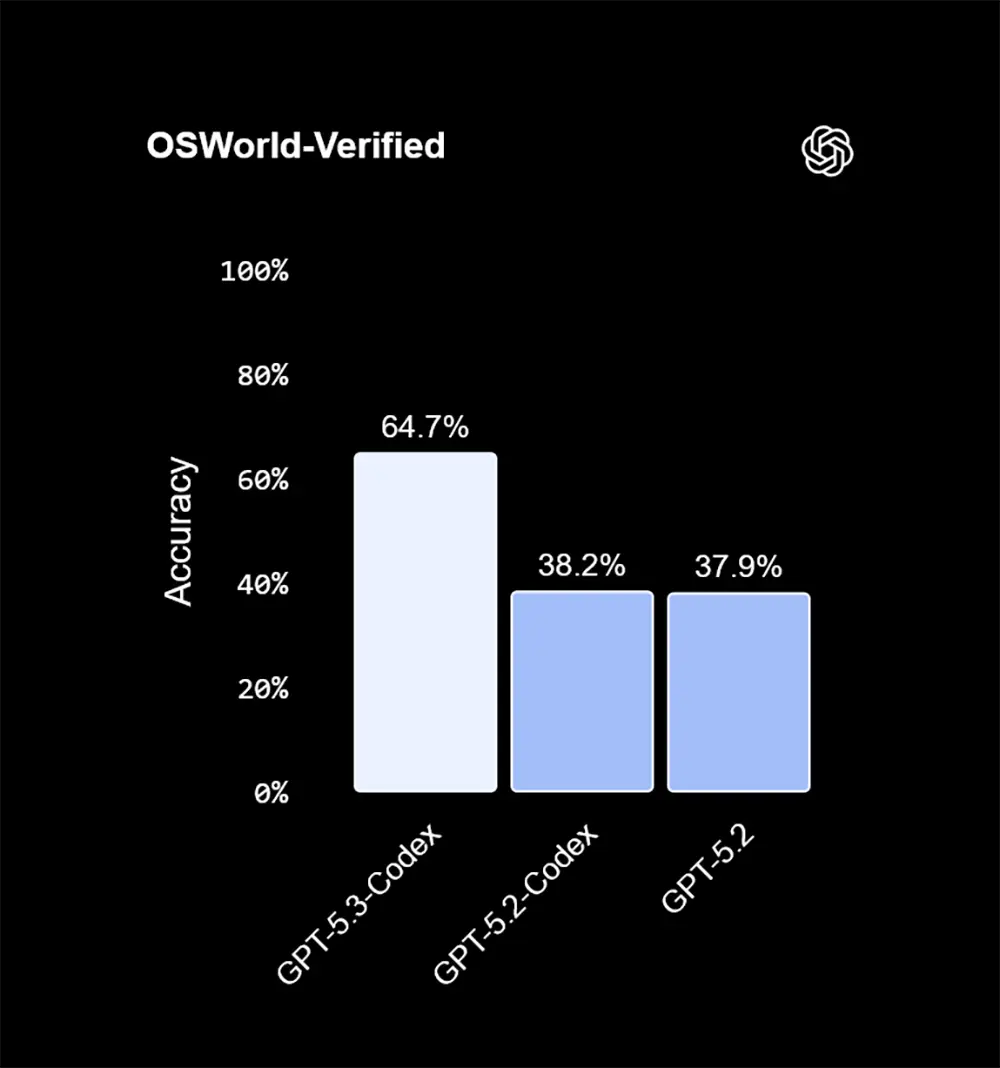

Ein Blick auf die technischen Daten bestätigt den qualitativen Sprung gegenüber GPT-5.2-Codex. Im anspruchsvollen OSWorld-Verified-Benchmark, der die Interaktion mit Betriebssystemen misst, erreicht das neue Modell eine Genauigkeit von 64,7 Prozent.

Zum Vergleich: Der direkte Vorgänger GPT-5.2-Codex lag hier lediglich bei 38,2 Prozent. Das Standardmodell GPT-5.2 kam sogar nur auf 37,9 Prozent, was eine fast verdoppelte Leistung bei der Systemsteuerung bedeutet.

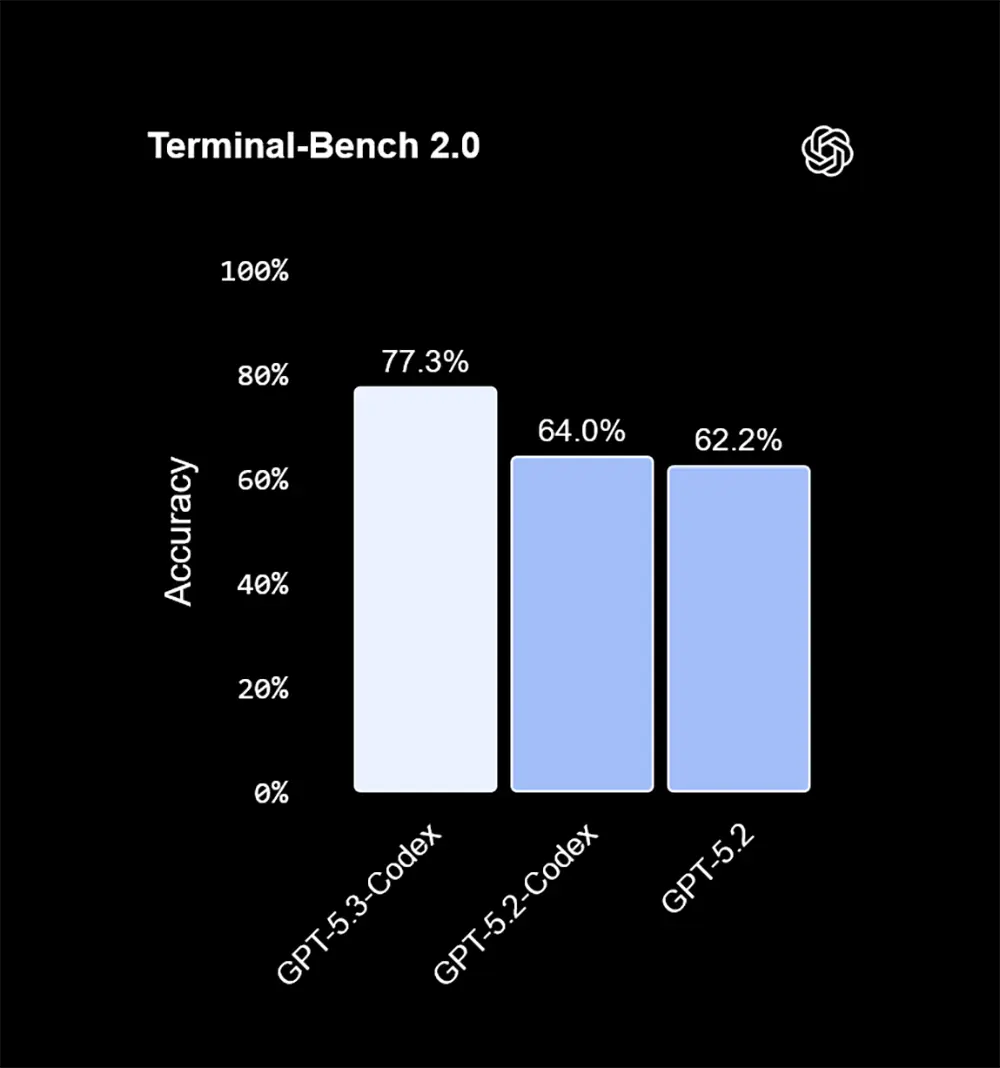

Auch in der Arbeit mit der Kommandozeile zeigt sich die neue Stärke. Im Terminal-Bench 2.0 dominiert die Version 5.3 mit 77,3 Prozent klar das Feld, während der Vorgänger bei 64,0 Prozent stagnierte.

Stabilität bei komplexen Aufgaben

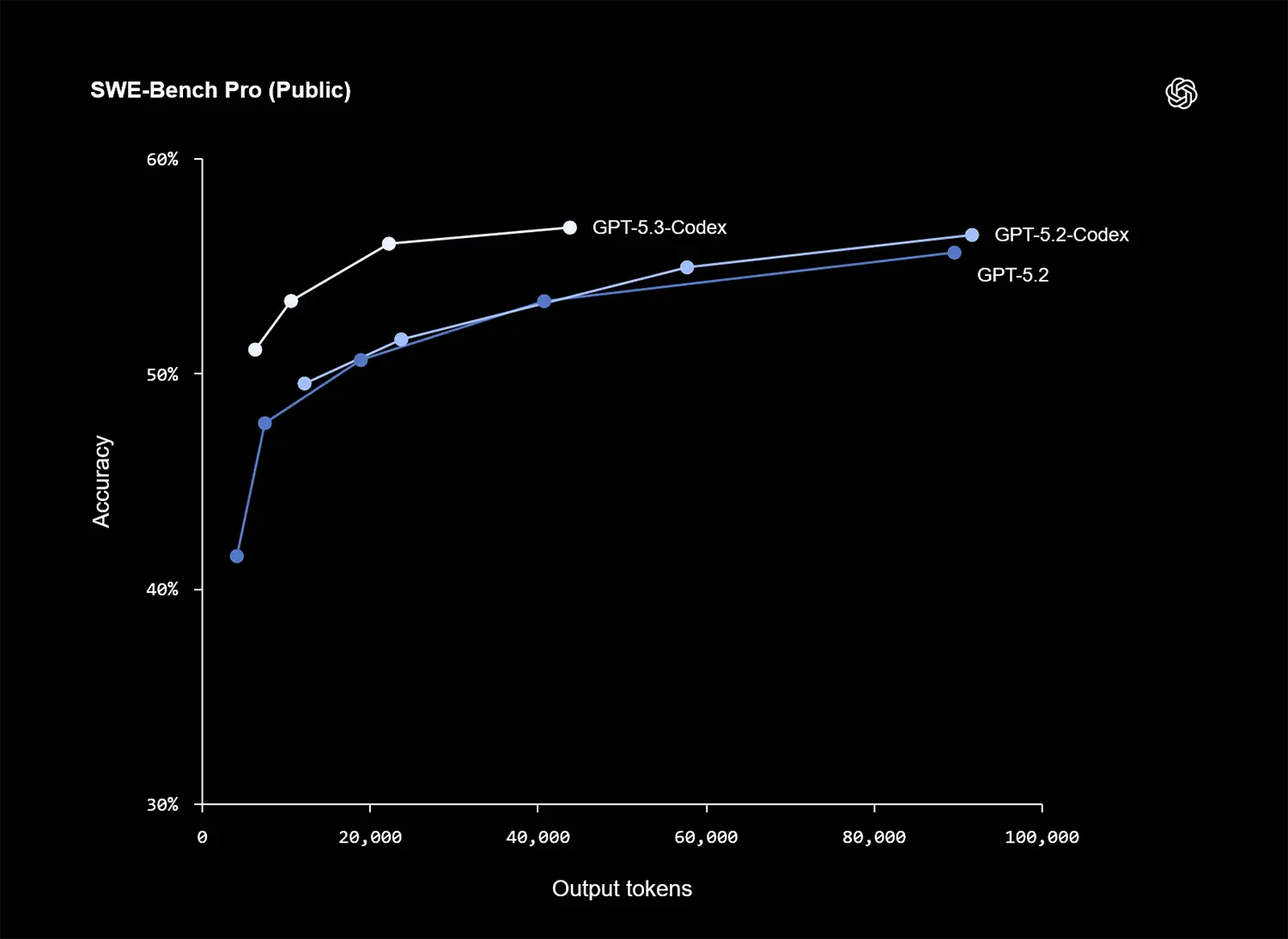

Besonders relevant für den Praxisalltag großer Software-Projekte ist die Performance im SWE-Bench Pro. Die Daten zeigen, dass das Modell auch bei extrem langen Ausgaben und Kontexten stabil bleibt und nicht halluziniert.

Es verliert den Faden bei komplexen Refactoring-Aufgaben über tausende Zeilen Code nicht. Das unterscheidet reine Text-Generatoren von echten Agenten-Systemen, die Aufgaben autonom zu Ende führen.

GPT-5.3-Codex löst Tickets und Issues in Repositories mit einer Zuverlässigkeit, die bisher menschliches Eingreifen bei jedem Zwischenschritt erforderte. Die Kurve der Erfolgsrate steigt im Verhältnis zu den Output-Tokens deutlich steiler an als bei GPT-5.2.

Quelle: OpenAI

Native Desktop-App statt Browser-Chat

Neben dem Modell rollt OpenAI eine dedizierte Codex-Anwendung für macOS und Windows aus. Diese integriert sich tiefer in die bestehende Entwicklungsumgebung als bisherige Web-Interfaces.

Entwickler müssen nicht mehr ständig zwischen Browser und IDE wechseln. Der Agent liest den Kontext bei Bedarf direkt aus dem Terminal oder dem Editor und schlägt Änderungen im Dateisystem vor.

Die App fungiert als Schnittstelle für den Agenten. Sie erlaubt dem Modell, lokale Tests auszuführen und Fehler selbstständig zu korrigieren, bevor der Entwickler den Code sichtet.

Anzeige

Vom Assistenten zum Mitarbeiter

Die Grenzen zwischen reiner Assistenz und autonomer Entwicklung verschwimmen mit diesem Release weiter. Agenten übernehmen mit GPT-5.3-Codex zunehmend die Rolle von Junior-Entwicklern, die ganze Aufgabenpakete abarbeiten.

Teams können sich so stärker auf Architektur, Logik und Design konzentrieren. Die reine Schreibarbeit und das Debugging erledigt die KI effizienter und vor allem schneller.