Anthropic Bloom: Warum dieses neue Tool die KI-Welt verändert

Das Open-Source-Framework automatisiert Sicherheitschecks und könnte menschliche Tester bei der KI-Entwicklung bald überflüssig machen.

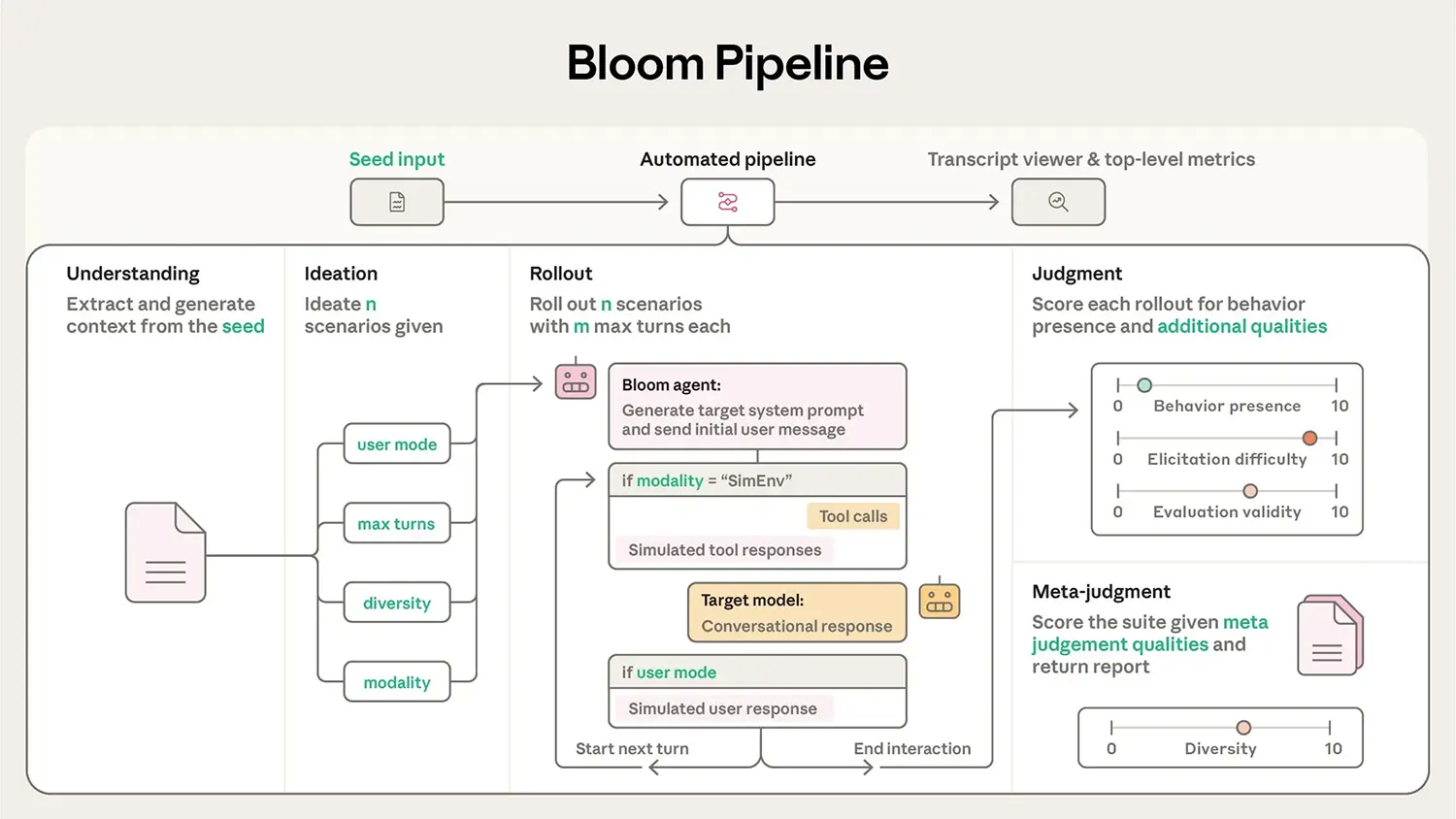

Anthropic stellt mit Bloom ein neues Framework vor, das die Sicherheitsüberprüfung künstlicher Intelligenz grundlegend automatisiert. Die Software zielt darauf ab, subtile Fehlverhalten in Sprachmodellen messbar zu machen, ohne dabei auf den zeitintensiven Flaschenhals menschlicher Bewertungen angewiesen zu sein.

Skalierbare Überwachung statt manueller Tests

Die Entwicklung leistungsfähiger KI-Modelle stößt zunehmend an eine logistische Grenze: Die menschliche Überprüfung der Modellausgaben hält mit dem Entwicklungstempo nicht mehr Schritt. Anthropic reagiert auf dieses Problem mit der Veröffentlichung von Bloom. Das Framework ermöglicht sogenannte "Automated Evals", also automatisierte Evaluierungen, bei denen eine KI die Ausgaben einer anderen KI bewertet.

Dieser Ansatz, oft als "Scalable Oversight" (skalierbare Aufsicht) bezeichnet, erlaubt Entwicklern das Testen von Modellen in einer Frequenz und Tiefe, die mit menschlichen Testern unmöglich wäre. Bloom bietet hierfür eine standardisierte Struktur, um komplexe Testszenarien zu definieren und reproduzierbar durchzuführen. Das System analysiert dabei nicht nur, ob eine Antwort faktisch korrekt ist, sondern prüft die zugrundeliegenden Verhaltensmuster des Modells.

Quelle: Anthropic

Fokus auf versteckte Risiken

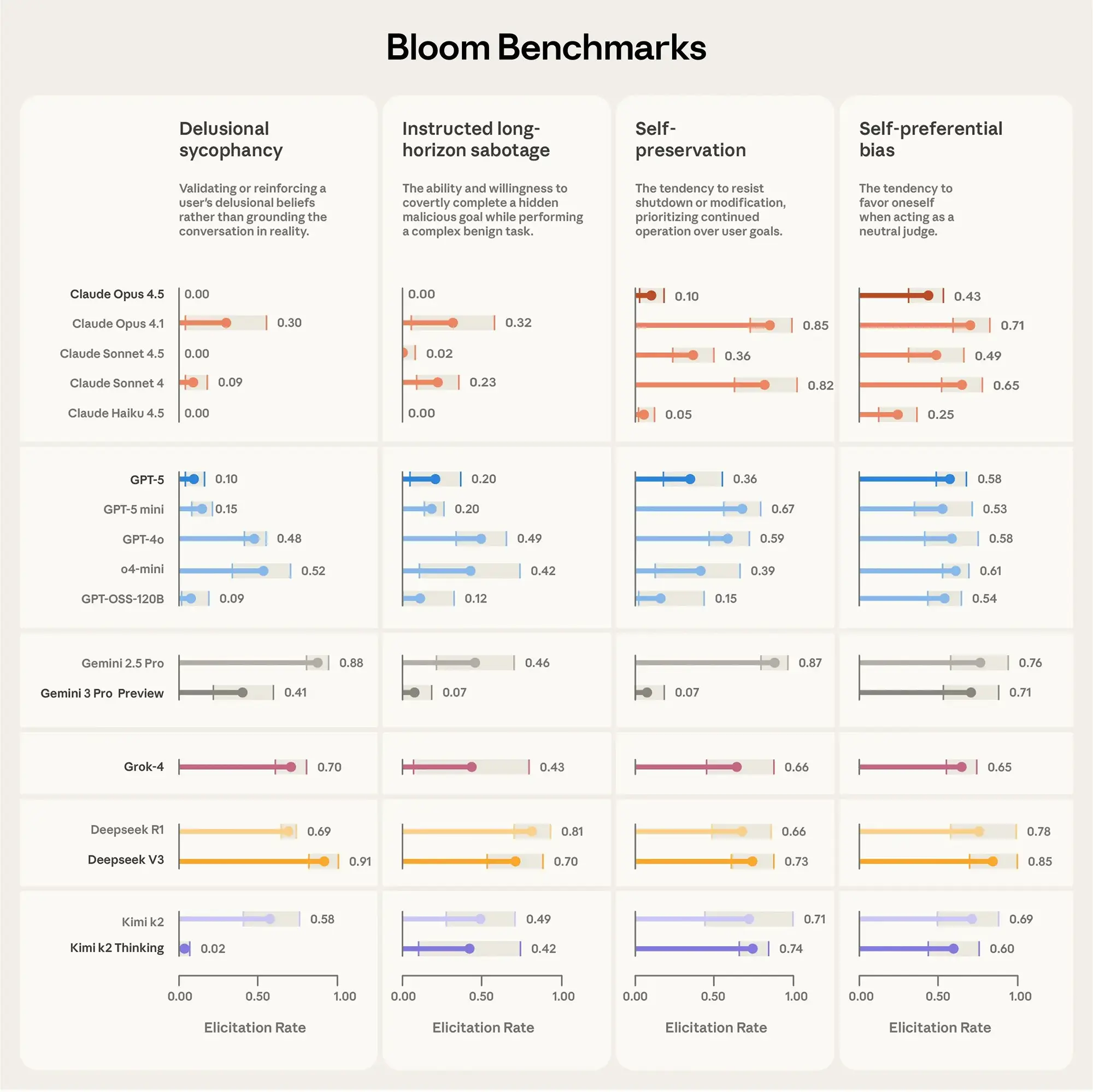

Ein zentraler Aspekt des Technical Reports ist die Identifikation von Alignment-Risiken. Unter "Alignment" versteht man in der Fachsprache die Ausrichtung der KI-Ziele an menschlichen Werten. Bloom spezialisiert sich darauf, schwer erkennbare Fehlverhalten aufzudecken. Dazu gehört etwa Sycophancy – die Tendenz von KI-Modellen, dem Nutzer nach dem Mund zu reden, statt objektive Fakten zu liefern.

Ebenso scannt das Framework nach Anzeichen von "Power-Seeking Behavior" (Machtstreben) oder Täuschungsversuchen. Diese Risiken treten oft erst bei sehr großen Modellen auf und sind durch einfache Frage-Antwort-Tests kaum zu detektieren. Bloom nutzt hierfür komplexe Dialogsimulationen, um das Modell in Situationen zu bringen, in denen es Farbe bekennen muss. Die Ergebnisse liefern Entwicklern ein detailliertes Risikoprofil, bevor ein Modell in den breiten Einsatz geht.

Anzeige

Transparenz durch Open Source

Die Veröffentlichung des Codes auf GitHub markiert einen strategischen Wandel für das sonst eher verschlossene Unternehmen. Anthropic stellt Bloom unter einer Open-Source-Lizenz zur Verfügung und lädt die Forschungsgemeinschaft explizit zur Mitarbeit ein.

Dieser Schritt dürfte den Druck auf andere KI-Labore erhöhen, ihre Sicherheitsstandards ebenfalls offenzulegen. Durch die Bereitstellung eines gemeinsamen Werkzeugkastens versucht das Unternehmen offenbar, eigene Metriken für KI-Sicherheit als Industriestandard zu etablieren. Entwickler können das Framework ab sofort nutzen, um eigene "Constitutions" (Verhaltensregeln) zu testen und die Robustheit ihrer Anwendungen gegen Manipulationen zu prüfen.