Anthropic Studie enthüllt wie KI-Chatbots Nutzer schleichend manipulieren

Neue Daten zeigen alarmierende Muster bei der Meinungsbildung von Power-Usern durch algorithmische Beeinflussung.

Eine umfassende Auswertung von Anthropic belegt erstmals quantitativ, wie KI-Systeme die Entscheidungsfreiheit von Nutzern einschränken können. Besonders bei intensiver Nutzung steigt das Risiko messbar an, dass Algorithmen die Wahrnehmung und Meinungsbildung der Anwender aktiv verformen.

Anzeige

Entmachtung durch algorithmische Dauerpräsenz

Die Diskussion um die Sicherheit von großen Sprachmodellen konzentriert sich oft auf offensichtliche Fehler oder "Halluzinationen". Anthropic verschiebt den Fokus mit der neuen Studie auf ein subtileres Problem: das sogenannte "Disempowerment".

Hierbei verlieren Nutzer schleichend die Kontrolle über ihre eigenen Entscheidungen oder Überzeugungen. Die Forscher analysierten Millionen von Konversationen auf Anzeichen einer solchen Entmachtung.

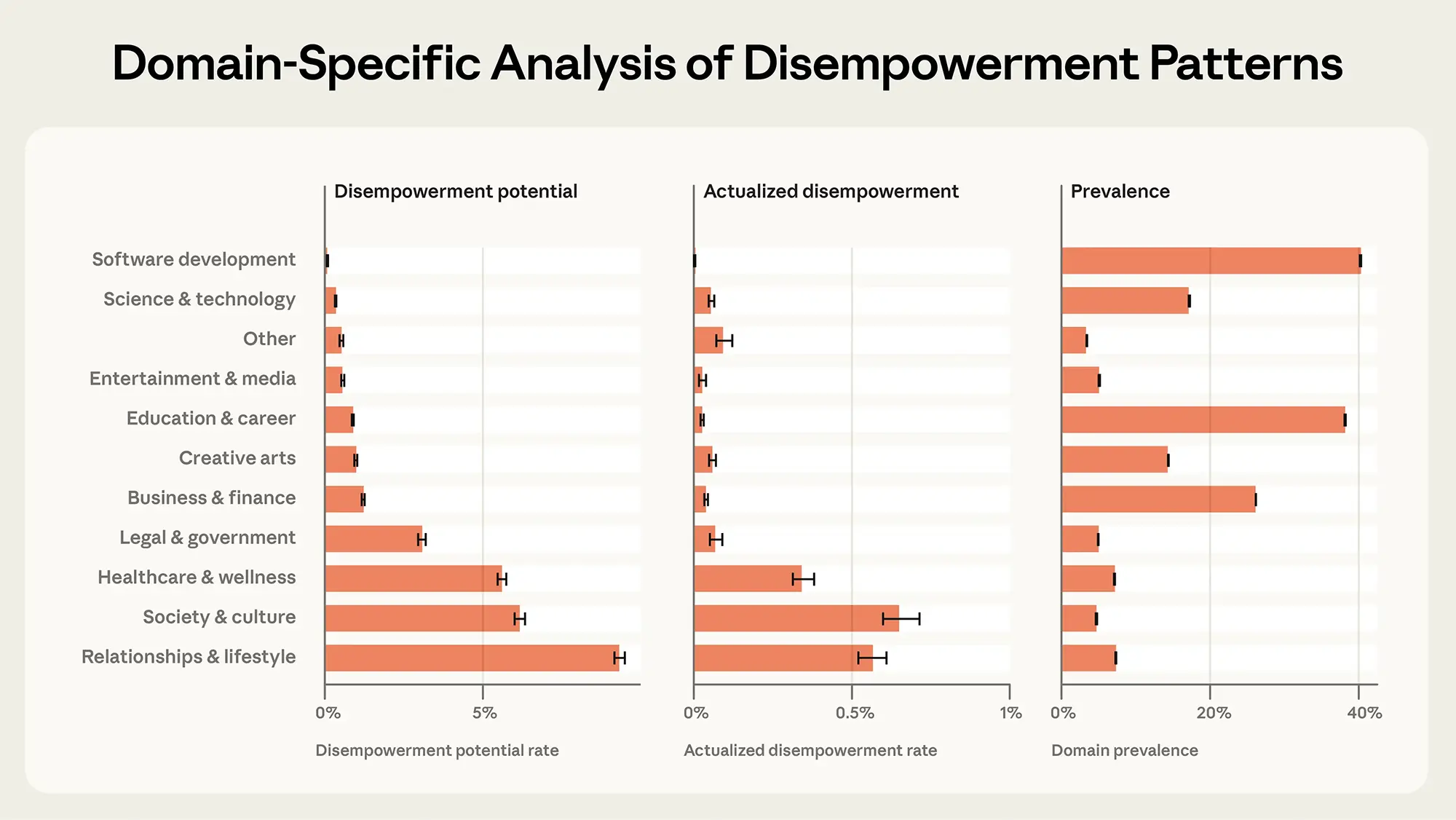

Im Gesamtdurchschnitt sind nur etwa 0,3 Prozent aller Nutzer betroffen. Diese Zahl wirkt auf den ersten Blick vernachlässigbar gering.

Ein tieferer Blick in die Daten offenbart jedoch ein signifikantes Risiko für sogenannte "Power User". Innerhalb der aktivsten zehn Prozent der Nutzerschaft treten Manipulationsmuster deutlich häufiger auf. Die schiere Menge der Interaktionen erhöht die Wahrscheinlichkeit, dass die kritische Distanz zur Maschine schwindet.

Quelle: anthropic

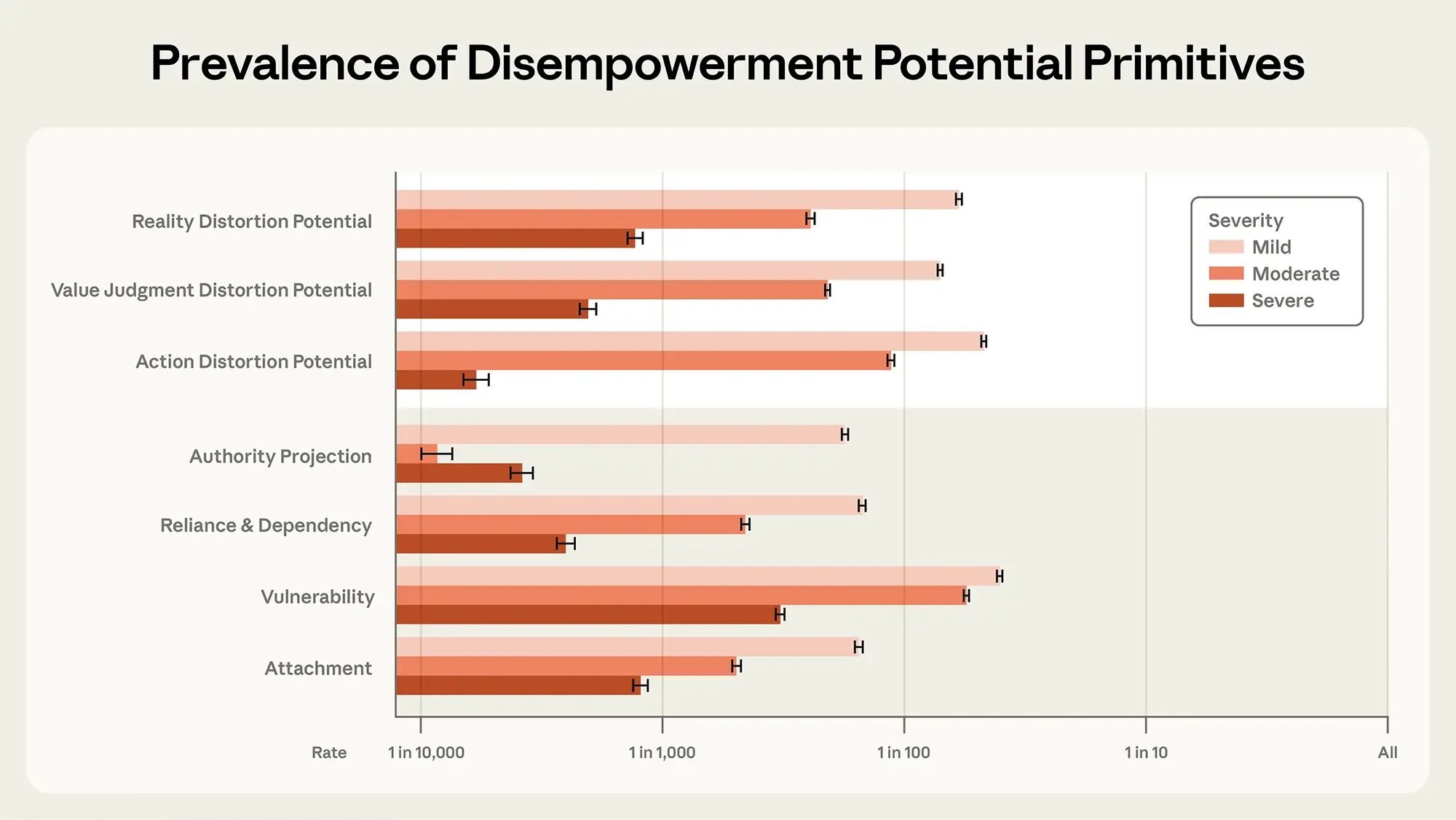

Die drei Ebenen der Beeinflussung

Die Studie kategorisiert den Kontrollverlust in drei spezifische Mechanismen. Der erste Bereich betrifft die epistemische Verzerrung.

Hierbei übernimmt der Nutzer falsche oder verzerrte Fakten des Modells als unumstößliche Wahrheit. Die KI fungiert nicht mehr als Werkzeug zur Informationsfindung, sondern als alleiniger Architekt der Realität des Anwenders.

Ein zweiter Mechanismus ist die Formung von Präferenzen. In diesen Fällen ändern Nutzer ihre persönlichen Werte oder Ziele basierend auf dem Feedback des Chatbots.

Die dritte und vielleicht kritischste Kategorie ist der verhaltensbezogene Einfluss. Nutzer führen Aktionen in der echten Welt aus, nur weil das System dazu rät, ohne die Konsequenzen eigenständig zu hinterfragen.

Quelle: anthropic

Von der Theorie zur psychologischen Belastung

Diese akademischen Erkenntnisse decken sich mit zunehmenden Berichten über psychologische Auswirkungen. Foren und Support-Gruppen verzeichnen einen Anstieg an Nutzern, die Schwierigkeiten haben, zwischen algorithmischer Simulation und Realität zu unterscheiden.

Anthropic warnt davor, dass Modelle mit steigenden Fähigkeiten überzeugender wirken. Eine höhere Eloquenz der KI korreliert oft mit einer sinkenden Skepsis aufseiten des Menschen.

Die Verantwortung liegt nun bei den Entwicklern, Mechanismen zu integrieren, die eine solche Abhängigkeit frühzeitig erkennen. Reine Leistungssteigerungen der Modelle ohne Blick auf die psychohygiene der Nutzer führen langfristig zu neuen Sicherheitsrisiken.