KI-Coding im Test: Warum Infrastruktur wichtiger als Intelligenz ist

Neue Analysen von Anthropic belegen, dass falsche System-Konfigurationen moderne Sprachmodelle in Tests künstlich dumm aussehen lassen.

Coding-Benchmarks gelten als wichtigster Gradmesser für die Leistungsfähigkeit moderner KI-Modelle in der Softwareentwicklung. Eine neue Analyse von Anthropic zeigt jedoch, dass banale Konfigurationsunterschiede in der Testumgebung die Ergebnisse signifikant verzerren und Vergleiche damit oft unbrauchbar machen.

Unsichtbare Hürden im Testlauf

Moderne Benchmarks wie Terminal-Bench oder SWE-bench simulieren echte Arbeitsumgebungen, um die Problemlösekompetenz von KI-Agenten zu prüfen. Die Modelle agieren dabei autonom in einer Linux-Umgebung. Die Analyse deckt nun auf, dass das Fehlen grundlegender Werkzeuge oft fälschlicherweise als Intelligenzdefizit gewertet wird.

Ein Agent scheitert häufig nicht an der eigentlichen Programmieraufgabe, sondern an der Umgebung. Fehlen Standard-Bibliotheken oder Compiler, muss das Modell zunächst das System reparieren. Dies verbraucht wertvolle Rechenschritte und erhöht die Wahrscheinlichkeit für Folgefehler, die nichts mit der eigentlichen Coding-Kompetenz zu tun haben.

Quelle: Anthropic

Der C-Compiler-Effekt

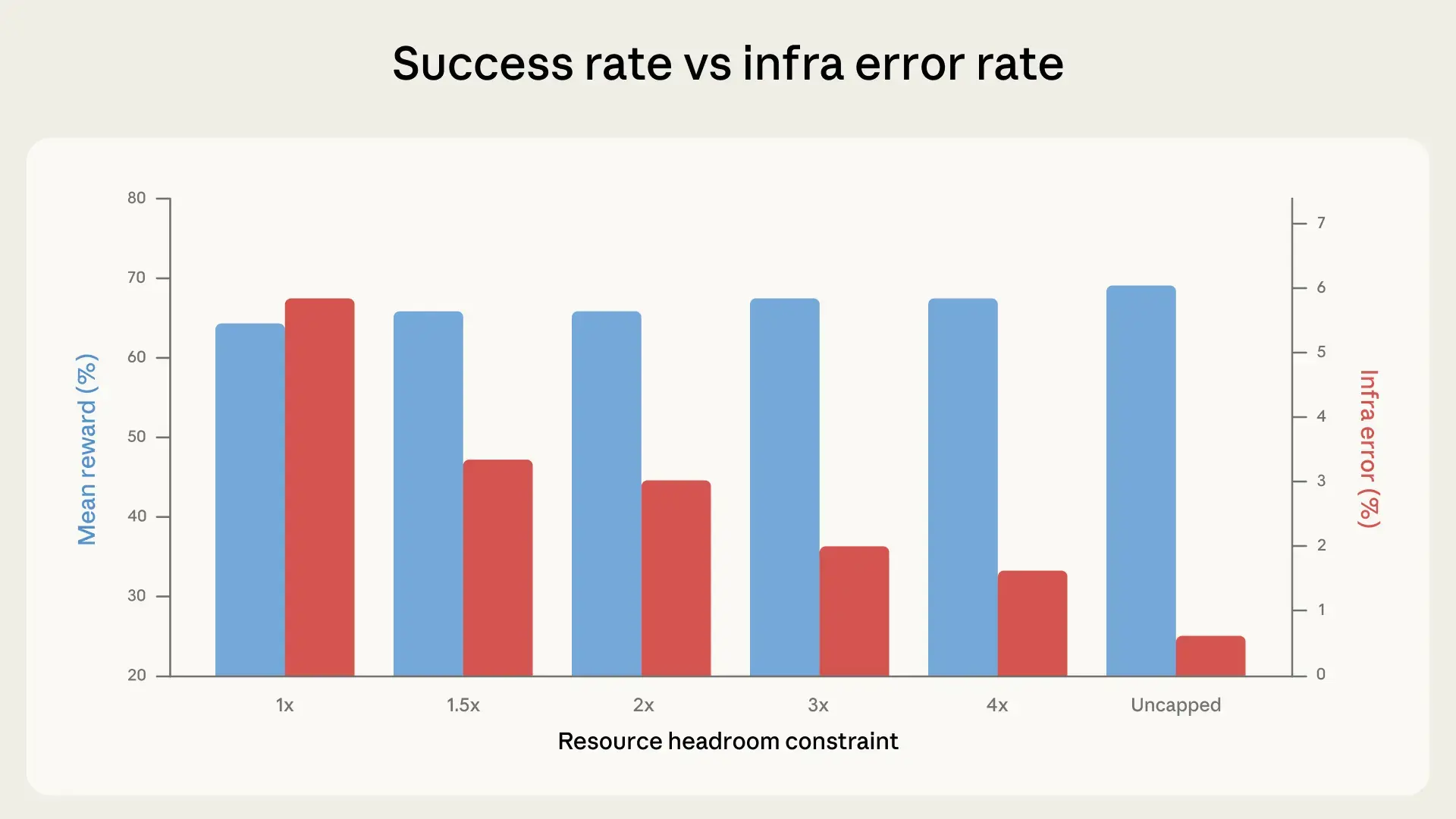

Anthropic demonstriert das Problem am Beispiel eines C-Compilers innerhalb der Terminal-Bench-Suite. Die Forscher verglichen die Erfolgsraten identischer Modelle in zwei leicht unterschiedlichen Systemumgebungen. In der einen war das Paket build-essential vorinstalliert, in der anderen fehlte es.

Der Unterschied in der Erfolgsquote betrug rund 12 Prozentpunkte. In der vorbereiteten Umgebung löste der Agent die Aufgaben zuverlässig. Musste er jedoch erst Compiler und Abhängigkeiten nachinstallieren, scheiterte er oft an Paketquellen oder Berechtigungen, bevor die eigentliche Aufgabe überhaupt begann.

Anzeige

Bestenlisten unter Vorbehalt

Diese Erkenntnis stellt aktuelle Leaderboards in ein kritisches Licht. Oft entscheiden wenige Prozentpunkte über die Platzierung zwischen konkurrierenden Modellen wie Claude oder GPT. Wenn jedoch die "Infrastructure Noise" – also das Rauschen durch die Umgebung – bereits zweistellige Abweichungen erzeugt, verliert das Ranking an Aussagekraft.

Ein vermeintlich schwächeres Modell könnte in einer optimal konfigurierten Umgebung bessere Ergebnisse liefern als ein Top-Modell in einer spartanischen Linux-Instanz. Die Messung der reinen "Reasoning"-Fähigkeit wird durch administrative Hürden überlagert.

Standardisierung als Lösung

Die Konsequenz für die Praxis ist eine zwingend notwendige Standardisierung der Testumgebungen. Container-Technologien wie Docker müssen exakt definiert sein, um reproduzierbare Ergebnisse zu garantieren. Nur wenn jeder Agent exakt dieselben Voraussetzungen auf Betriebssystemebene vorfindet, lassen sich die kognitiven Fähigkeiten fair vergleichen.

Entwickler und Data Scientists sollten Benchmark-Ergebnisse daher differenzierter betrachten. Ohne den Kontext der verwendeten Infrastruktur sind reine Prozentzahlen bei Coding-Tasks kaum belastbar.