Qwen3-Max: Alibaba zeigt 1-Billionen-KI

Größer als alles zuvor: Qwen3-Max-Preview startet mit über 1 Billion Parametern, 262k Kontext, gestaffelten API-Preisen und ersten Benchmarks gegen die Konkurrenz.

gpt-image-1 | All-AI.de

EINLEITUNG

Alibaba hat sein bislang größtes Sprachmodell vorgestellt: Qwen3-Max-Preview. Mit mehr als einer Billion Parametern, einem großem Kontextfenster und starker Benchmark-Leistung will das Modell direkt mit den US-Giganten konkurrieren. Es ist ab sofort per API verfügbar – allerdings nur als Vorschauversion.

NEWS

Größer, länger, schneller

Während viele KI-Labs zuletzt kleinere, effizientere Modelle entwickelt haben, geht Alibaba bewusst den entgegengesetzten Weg. Qwen3-Max setzt mit über einer Billion Parametern ein klares Zeichen: Größe zählt wieder. Mehr Parameter bedeuten zwar nicht automatisch bessere Ergebnisse, eröffnen aber neue Spielräume – etwa bei komplexem Denken, langen Dialogen oder datenintensiven Aufgaben.

Qwen verfolgt damit ein Ziel: den Anschluss an die westliche Konkurrenz nicht nur halten, sondern offensiv überholen. Die Infrastruktur dafür steht – mit Verfügbarkeit über Qwen Chat, die Alibaba-Cloud und OpenRouter.

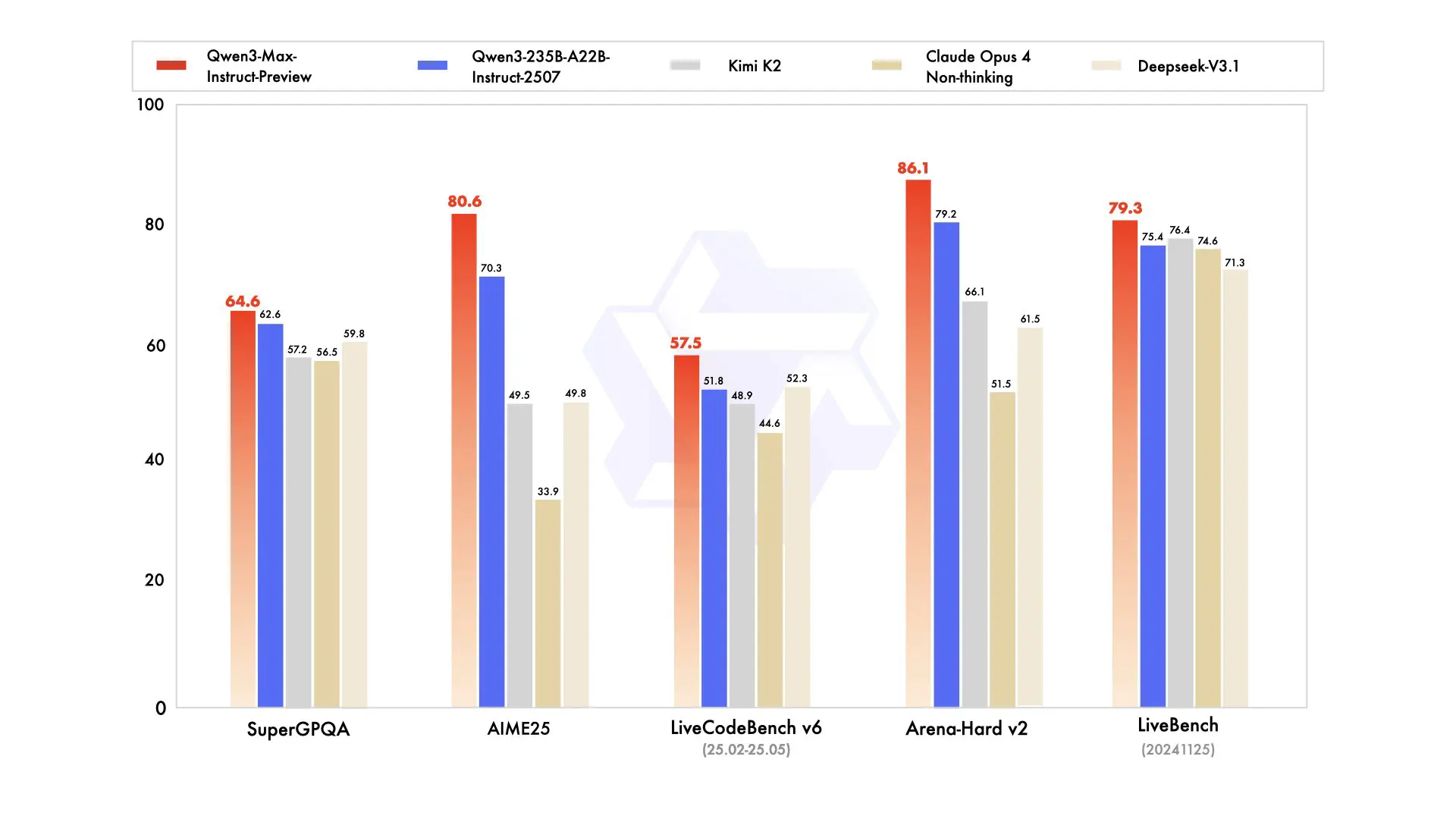

Quelle: Alibaba - Benchmark von Qwen-3-max

Leistung mit Ausdauer

In ersten Benchmarks schlägt Qwen3-Max nicht nur das Vorgängermodell, sondern liefert auch beachtliche Werte gegen etablierte Systeme wie Claude Opus 4 und Deepseek. Besonders auffällig: starke Ergebnisse bei Mathematik, Programmierlogik und kniffligen Reasoning-Aufgaben. Frühtester berichten sogar von strukturierten Schritt-für-Schritt-Antworten bei Aufgaben, an denen GPT-5 Thinking scheiterte.

Technisch beeindruckt vor allem das Kontextfenster: Bis zu 262.144 Tokens lassen sich verarbeiten – das entspricht einem ganzen Buch. Dank Context Caching kann das Modell auch über längere Chats hinweg schnell reagieren. Für Agent-Workflows oder umfangreiche Dokumentanalysen ist das ein echter Vorteil.

Zugang und Preisgestaltung

Das Modell ist bereits in mehreren Umgebungen verfügbar: Qwen Chat, Alibaba Cloud API und OpenRouter. Für Entwickler und Unternehmen bedeutet das eine einfache Integration – inklusive Unterstützung für OpenAI-kompatible Schnittstellen. Der Zugriff ist allerdings nicht kostenlos, sondern erfolgt über ein gestaffeltes Preismodell.

Je nach Eingabelänge steigen die Preise deutlich: Wer unter 32.000 Tokens bleibt, zahlt 0,861 US-Dollar pro Million Input-Tokens. Bei größeren Prompts steigen die Kosten auf bis zu 2,151 US-Dollar pro Million – plus Ausgabegebühren. Das macht kurze Anfragen günstig, stellt aber klare Grenzen für Dauerbelastung.

Viel Potenzial – mit Vorsicht

Für technische Teams kann das Modell vieles erleichtern: lange Inputs, strukturierte Ausgaben, weniger Notwendigkeit für Nachbearbeitung. Ob beim Auswerten von Logfiles, beim Erstellen von JSON oder im Coding-Alltag – Qwen3-Max verspricht Effizienz. Wer mit großen Datenmengen arbeitet, bekommt hier ein potentes Werkzeug.

Doch der Haken liegt im Detail: Es handelt sich um eine Preview-Version. Wie stabil, skalierbar und verlässlich das Modell unter Dauerlast ist, muss sich erst noch zeigen. Und wie bei allen Cloud-Modellen gilt: Sensible Daten sollten nur mit Bedacht verarbeitet werden. Wer jetzt einsteigt, testet auf eigenes Risiko – aber mit spannenden Möglichkeiten.

DEIN VORTEIL - DEINE HILFE

KURZFASSUNG

- Alibaba bringt Qwen3-Max-Preview mit „über 1 Billion Parametern“ an den Start.

- Das Modell bietet 262.144 Tokens Kontext, Context Caching und starke interne Benchmarks.

- Verfügbar sind Qwen Chat, Alibaba-Cloud-API und OpenRouter; die Preise sind gestaffelt.

- Für Teams winken Vorteile bei langen Dokumenten und Agent-Workflows, trotz Preview-Risiken.