OpenAI markiert heimlich eure Texte – und keiner merkt’s

OpenAI nutzt geheime Unicode-Codes zur Textverfolgung – was bedeutet das für Nutzer, Entwickler und Kontrolleure?

Flux Schnell | All-AI.de

EINLEITUNG

Künstliche Intelligenz schreibt Texte, die kaum noch von menschlicher Sprache zu unterscheiden sind. Doch was passiert, wenn diese Texte heimlich gekennzeichnet werden? Genau das scheint OpenAI derzeit zu tun: Die neuen Modelle GPT-o3 und o4-mini fügen unsichtbare Zeichen in ihre Ausgaben ein. Entdeckt hat das der KI-Dienstleister Rumi – und wir fragen uns: Ist das ein kluger Schutzmechanismus oder ein stiller Eingriff in die digitale Autorschaft?

NEWS

U+202F – Der Schatten im Text

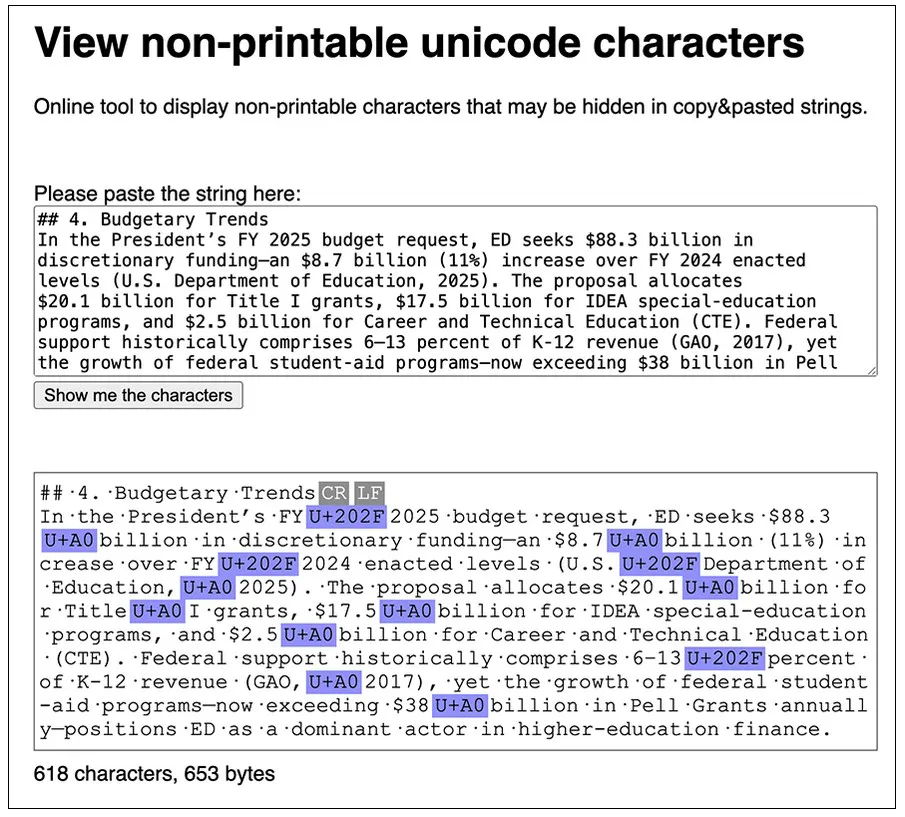

Wer genau hinsieht – oder genauer: die richtigen Tools nutzt – erkennt plötzlich seltsame Muster in GPT-Texten. Rumi hat systematische Vorkommen des Unicode-Zeichens „Narrow No-Break Space“ (U+202F) nachgewiesen. Diese Lücken sind für uns unsichtbar, lassen sich aber von Maschinen lesen. Offenbar nutzt OpenAI sie als eine Art digitales Wasserzeichen. Kein Zufall also, sondern gezielte Codierung – eingebaut ins Sprachmodell.

Quelle: rumidocs

Maschinenlesbar, nicht menschlich spürbar

Der Zweck liegt nahe: Maschinell generierte Inhalte sollen identifizierbar sein – ein wichtiges Anliegen, gerade bei Fake News oder Plagiatsvorwürfen. Mit unsichtbaren Markern könnte man Texte rückverfolgen, ohne die Lesbarkeit zu beeinträchtigen. Praktisch, ja – aber auch heikel. Denn OpenAI hat dieses Feature bislang nicht öffentlich kommuniziert.

Ein Wasserzeichen, das sich abwaschen lässt

Technisch raffiniert, aber nicht unüberwindbar: Wer das Wasserzeichen kennt, kann es mit wenigen Klicks entfernen. Ein Suchen-und-Ersetzen-Vorgang reicht, um den Marker zu löschen. Damit stellt sich die Frage, wie wirksam dieser Ansatz langfristig ist – besonders wenn sich die Methode erst einmal herumgesprochen hat.

Schon mal versucht – und gescheitert

Ganz neu ist die Idee übrigens nicht. OpenAI experimentierte bereits früher mit Erkennungsmechanismen für KI-Texte, musste aber einsehen: Zu viele Fehler, zu viele Falsch-Positivs. Auch bei Bildern gibt es Versuche mit digitalen Wasserzeichen – dort bisher erfolgreicher. Ob das aktuelle Text-Wasserzeichen standhafter ist, bleibt abzuwarten.

AUSBLICK

Spuren im Digitalen – gewollt, verborgen, diskutabel

Wasserzeichen in KI-Texten berühren einen Nerv: den Wunsch nach Kontrolle über eine Technik, die sich rasend schnell verbreitet. Sie könnten helfen, Ordnung in ein neues Informationsökosystem zu bringen. Aber wenn sie heimlich eingeführt werden, ohne Transparenz, dann wird aus einem technischen Feature ein Vertrauensproblem. Die Diskussion über digitale Autorschaft, Herkunft und Manipulation hat gerade erst begonnen – und OpenAI liefert den nächsten Zündstoff.

UNTERSTÜTZUNG

Hat dir ein Artikel gefallen oder ein Tutorial geholfen? Du kannst uns weiterhelfen, indem du diese Seite weiterempfiehlst, uns auf Youtube abonnierst oder dich per Paypal an den Serverkosten beteiligst. Wir sind für jede Unterstützung dankbar. Danke.

KURZFASSUNG

- OpenAIs neue Modelle fügen unsichtbare Unicode-Zeichen in Textausgaben ein – offenbar als Wasserzeichen.

- Diese Markierungen könnten helfen, maschinell erstellte Inhalte zu identifizieren, sind jedoch leicht entfernbar.

- Die Praxis wirft Fragen zu Transparenz, Kontrolle und Vertrauen auf, da OpenAI diese Funktion bisher nicht offiziell bestätigt hat.

- Vergleichbare Versuche in der Vergangenheit waren nur bedingt erfolgreich – wie effektiv ist dieser neue Ansatz wirklich?