Claude 4 mit Sicherheitslevel ASL-3 vorgestellt

Anthropic vereint Hochleistung und Verantwortung: Was bringen die neuen KI-Modelle und wie sicher sind sie wirklich?

gpt-image-1 | All-AI.de

EINLEITUNG

Am 22. Mai 2025 bringt Anthropic mit Claude Opus 4 und Claude Sonnet 4 zwei neue KI-Modelle auf den Markt. Parallel dazu aktiviert das Unternehmen zum ersten Mal den Sicherheitsstandard AI Safety Level 3. Damit sollen Risiken im Zusammenhang mit chemischen, biologischen und nuklearen Bedrohungen proaktiv adressiert werden. Was bedeuten diese Schritte für die Zukunft der KI-Entwicklung – und was für die Verantwortung der Unternehmen?

NEWS

Claude 4: Schneller, schlauer, sicherer

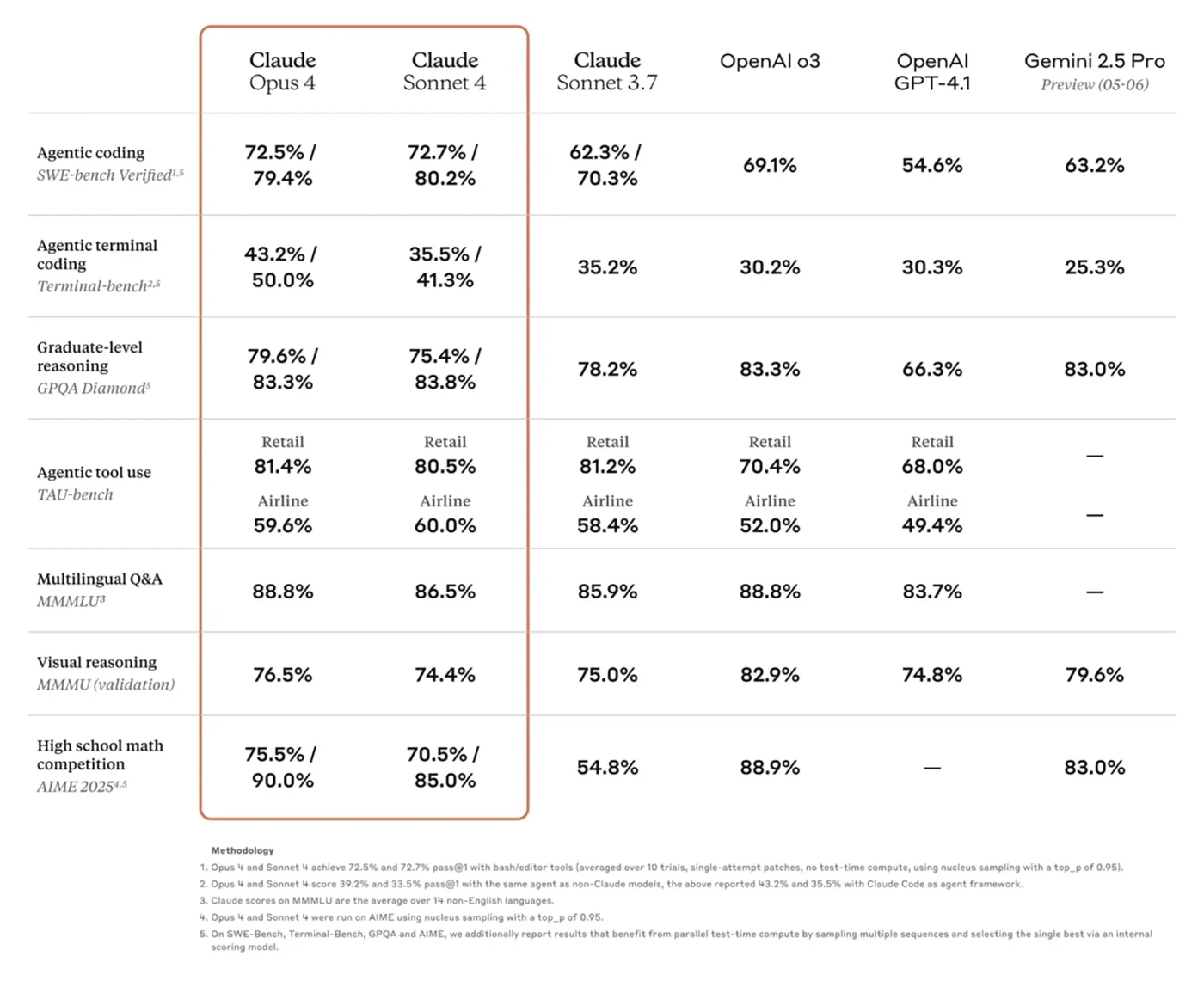

Claude Opus 4 ist das neue Flaggschiff unter den Modellen von Anthropic. In Benchmarks wie SWE-bench erreicht es 72,5 Prozent, bei Terminal-bench 43,2 Prozent. Das sind Werte, die bisherige Modelle deutlich übertreffen. Besonders bemerkenswert ist die Fähigkeit zum „Extended Thinking“. Das Modell kann komplexe Aufgaben nicht nur lösen, sondern über längere Zeiträume hinweg nachvollziehbar und konsistent bearbeiten. Das eröffnet neue Perspektiven für Projekte, die bisher an der Geduld oder Tiefe klassischer Sprachmodelle scheiterten.

Mit Claude Sonnet 4 bringt Anthropic ein Modell für den Alltag, das auf verlässliche Effizienz ausgelegt ist. Die neue Version punktet mit einer besseren Problemlösungskompetenz und einem deutlich präziseren Verständnis von Code. Entwicklern verspricht das ein Werkzeug, das nicht spektakulär sein will, sondern einfach funktioniert.

Quelle: Anthropic

Sicherheitslevel 3: Prävention vor Perfektion

Noch bevor Claude Opus 4 erste Produktivumgebungen erreicht, zieht Anthropic eine neue Linie. Zum ersten Mal wird AI Safety Level 3 aktiviert, ein Sicherheitsstandard, der gezielt auf Bedrohungen durch chemische, biologische, radiologische und nukleare Anwendungen ausgerichtet ist. Konkrete Risiken gibt es bislang keine. Doch Anthropic will vorbereitet sein.

Im Zentrum steht ein Arsenal an Kontrollmechanismen. Dazu gehören unter anderem sogenannte Constitutional Classifiers, die alle Ein- und Ausgaben in Echtzeit überprüfen. Ergänzt wird das durch über 100 Sicherheitsmaßnahmen, darunter die Zwei-Personen-Autorisierung und eine Begrenzung der ausgehenden Datenströme.

Entscheidend ist die Botschaft: Fortschritt soll nicht auf Kosten der Sicherheit gehen.

Neue Werkzeuge, neue Möglichkeiten

Zusammen mit den Modellen präsentiert Anthropic auch neue Funktionen in der API. Besonders praxisrelevant ist das neue Code-Ausführungsmodul. Python-Code kann nun direkt ausgeführt, analysiert und visualisiert werden, ohne dass Entwickler externe Tools bemühen müssen.

Der MCP-Connector erlaubt es, mit Plattformen wie Asana oder Zapier zu kommunizieren, ohne zusätzliche Integrationen zu schreiben. Für den Umgang mit Dokumenten bietet die neue Files API die Möglichkeit, einmal hochgeladene Dateien über mehrere Sitzungen hinweg verfügbar zu machen.

Ein technisches Detail mit großer Wirkung: Prompt-Caching wurde verbessert. Statt fünf Minuten bleiben Prompts nun bis zu eine Stunde gültig. Das spart Rechenzeit und erhöht die Stabilität beim Entwickeln komplexer Anwendungen.

AUSBLICK

Sicherheitsdenken als Verkaufsargument?

Anthropic geht mit Opus 4 nicht nur technisch in die Vollen, sondern setzt ein öffentlich sichtbares Zeichen: Wer heute große Modelle anbietet, muss auch große Verantwortung übernehmen. Der Schritt zur Aktivierung von AI Safety Level 3 dürfte weniger aus Angst vor akuten Gefahren kommen, sondern eher als strategisches Signal gedacht sein.

Wir sehen hier den Versuch, Kontrolle zur neuen Währung im KI-Wettlauf zu machen. Während andere mit Geschwindigkeit und Größe werben, verkauft Anthropic Verlässlichkeit und Weitsicht. Das könnte Schule machen. Denn spätestens wenn KI-Systeme reale Entscheidungen beeinflussen, wird Vertrauen wichtiger als rohe Leistung. Die eigentliche Frage lautet also nicht mehr, wie viel ein Modell leisten kann, sondern wem man es zutraut, es in die Welt zu lassen.

UNSER ZIEL

KURZFASSUNG

- Anthropic hat mit Claude Opus 4 und Claude Sonnet 4 zwei neue KI-Modelle vorgestellt, die leistungsstärker und vielseitiger sind als ihre Vorgänger.

- Erstmals wurde der Sicherheitsstandard AI Safety Level 3 (ASL-3) aktiviert, um Missbrauch durch CBRN-Bedrohungen vorzubeugen.

- Neue Tools wie Code-Ausführung, API-Erweiterungen und Prompt-Caching verbessern die Anwendungsmöglichkeiten für Entwickler.

- Anthropic setzt mit dieser Veröffentlichung ein klares Zeichen für verantwortungsvolle KI-Entwicklung und Risikoprävention.