BitNet: Microsofts CPU-KI fordert die Großen heraus

Weniger Bits, aber nicht weniger Leistung: Mit BitNet b1.58 bringt Microsoft ein Modell, das Effizienz und Performance vereint – ein neuer Standard?

Flux Schnell | All-AI.de

EINLEITUNG

Während große KI-Modelle immer komplexer und rechenintensiver werden, geht Microsoft einen radikal anderen Weg. BitNet b1.58, ein Modell mit nur drei Gewichtszuständen, verzichtet auf Spezialhardware und setzt neue Maßstäbe in Sachen Effizienz. Was kann ein 1-Bit-Modell leisten – und könnte das die KI-Architektur von morgen verändern?

NEWS

Ternäre Einfachheit statt Hardwarewahn

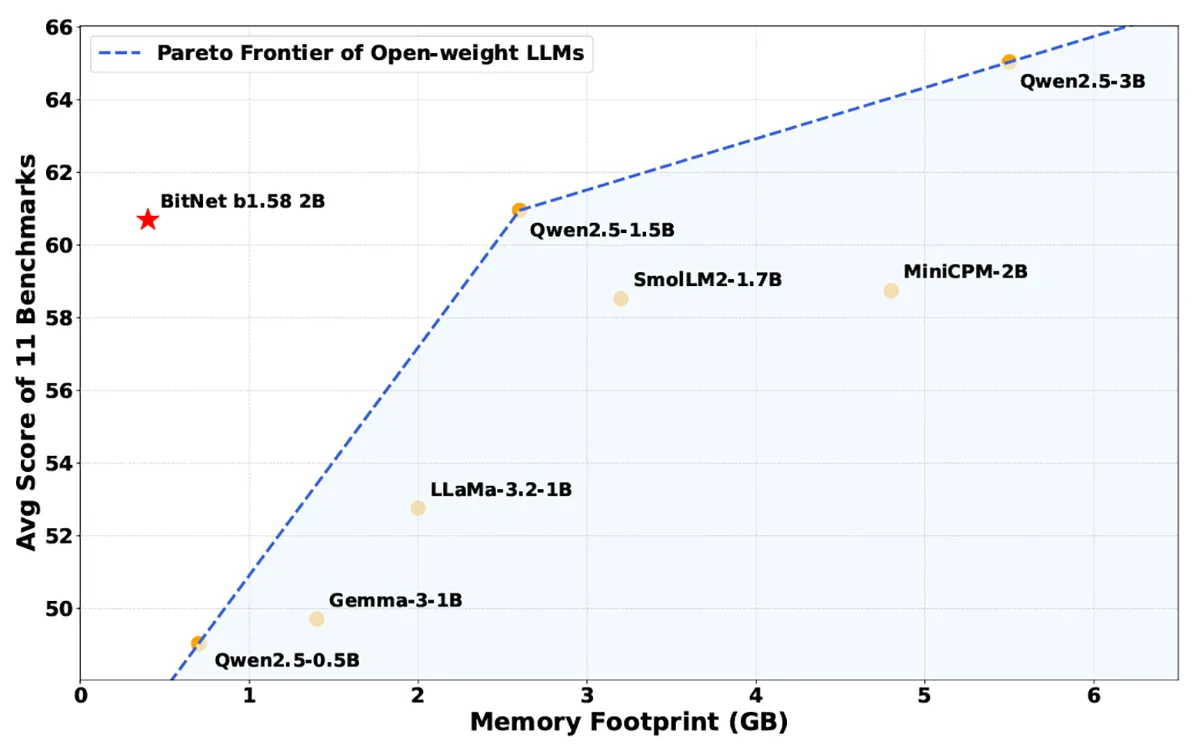

BitNet b1.58 basiert auf einem ungewöhnlich simplen Prinzip: Jedes Gewicht im Modell kann nur -1, 0 oder 1 sein. Diese sogenannte ternäre Quantisierung senkt den Speicherbedarf drastisch – auf nur 0,4 Gigabyte für ein Sprachmodell mit zwei Milliarden Parametern. Während andere Modelle auf GPUs und TPUs angewiesen sind, läuft BitNet auf Standard-CPUs. Das senkt nicht nur die Kosten, sondern macht das Modell auch für Edge- und Mobilgeräte interessant.

Benchmark-Power trotz Minimalismus

Effizienz ohne Einbußen – das klingt wie ein Paradoxon, funktioniert hier aber erstaunlich gut. In Benchmarks wie GSM8K (Mathematikaufgaben) und PIQA (physikalische Alltagslogik) schlägt BitNet b1.58 etablierte Leichtgewichte wie LLaMa 3.2 1B oder Gemma 3 1B. Dass ein Modell mit so begrenzter numerischer Präzision derart performt, zeigt, wie viel Potenzial in quantisierten Architekturen steckt – wenn sie richtig trainiert sind.

Quelle: Microsoft

bitnet.cpp: Inferenz mit Lesegeschwindigkeit

Zur Laufzeit setzt Microsoft auf das eigens entwickelte Framework „bitnet.cpp“. Es ermöglicht Inferenz auf CPUs mit Geschwindigkeiten von bis zu 7 Tokens pro Sekunde – was etwa der Lesegeschwindigkeit eines Menschen entspricht. Noch interessanter: Der Energieverbrauch ist im Vergleich zu klassischen Modellen deutlich reduziert. Damit ist bitnet.cpp nicht nur ein technisches Experiment, sondern ein reales Werkzeug für nachhaltige KI-Anwendungen.

AUSBLICK

Effizienz wird zum Wettbewerbsvorteil

BitNet b1.58 zeigt, wohin die Reise gehen könnte: weg von gigantischen Modellen mit absurd hohem Ressourcenbedarf – hin zu eleganten, sparsamen Lösungen, die auf Alltagsgeräten laufen. Besonders in Zeiten wachsender Rechenkosten und steigenden Energiebedarfs ist dieser Ansatz mehr als nur ein technischer Gag. Wenn es gelingt, die Trainingsmethoden weiter zu verfeinern, könnte Microsoft mit BitNet eine neue Generation von KI-Modellen einläuten – leistungsstark, energieeffizient und endlich massentauglich.

UNTERSTÜTZUNG

Hat dir ein Artikel gefallen oder ein Tutorial geholfen? Du kannst uns weiterhelfen, indem du diese Seite weiterempfiehlst, uns auf Youtube abonnierst oder dich per Paypal an den Serverkosten beteiligst. Wir sind für jede Unterstützung dankbar. Danke.

KURZFASSUNG

- Microsoft hat mit BitNet b1.58 ein hocheffizientes KI-Modell vorgestellt, das nur mit den Gewichtswerten -1, 0 und 1 arbeitet.

- Das Modell benötigt kaum Speicher, läuft effizient auf CPUs und übertrifft dabei sogar Modelle großer Anbieter wie Meta und Google.

- Mit dem Tool bitnet.cpp ermöglicht Microsoft eine schnelle Inferenz bei gleichzeitig deutlich reduziertem Energieverbrauch.

- BitNet könnte der Beginn einer neuen Ära besonders ressourcenschonender KI-Modelle sein, ideal für mobile und Edge-Anwendungen.