Der nächste Schritt für KI-Coder

Vergessen Sie simple Code-Generatoren. Metas CWM analysiert Programmabläufe und versteht die Konsequenzen jeder einzelnen Zeile.

gpt-image-1 | All-AI.de

EINLEITUNG

Bisherige KI-Modelle schreiben Code oft, ohne dessen Ausführung wirklich zu verstehen. Sie behandeln ihn wie reinen Text. Meta stellt mit dem Code World Model (CWM) nun einen neuen Ansatz vor. Das Modell lernt nicht nur das Schreiben, sondern simuliert auch, was der Code im System bewirkt. Es entwickelt eine Art "mentales Modell" für Programmabläufe und soll so das Debugging revolutionieren, noch bevor ein Mensch den Code überhaupt ausführt.

NEWS

Ein Weltmodell für den Code

Meta bricht mit der Tradition, KI-Modelle nur auf statischem Quellcode zu trainieren. Der entscheidende Unterschied beim Code World Model liegt im Trainingsprozess, der die tatsächliche Ausführung von Programmen in den Mittelpunkt stellt. Dafür analysierte das Modell über 120 Millionen sogenannte „Execution Traces“ von Python-Programmen. Bei diesen Durchläufen lernte die KI, wie sich Variablenzustände nach jeder einzelnen Befehlszeile verändern und wie sich der Programmfluss entwickelt.

Um eine realistische und komplexe Lernumgebung zu schaffen, setzte Meta zusätzlich auf über 35.000 Docker-Container. Diese wurden aus öffentlichen GitHub-Projekten erstellt und ermöglichten es dem Modell, Code in einer echten Laufzeitumgebung auszuführen, inklusive aller Abhängigkeiten und Tests. Dieser Ansatz erlaubt der KI, direkt mit dem Code zu interagieren, Fehler zu provozieren und aus den Ergebnissen zu lernen, anstatt nur textuelle Muster zu erkennen.

Quelle: Meta

Leistung in der Praxis und Ausblick

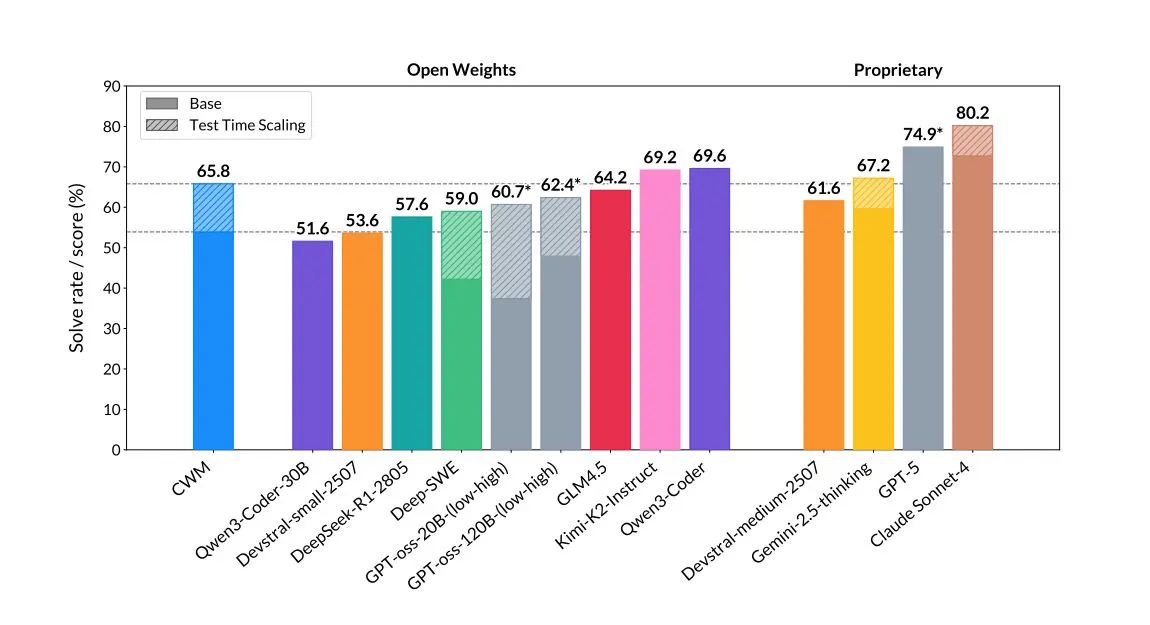

Die Resultate dieser neuen Trainingsmethode sind messbar. Für die Bewertung entwickelte Meta den neuen Benchmark „HaltEval“, der prüft, ob ein Modell vorhersagen kann, ob ein Programm erfolgreich endet oder in einer Endlosschleife stecken bleibt. Hier erreichte das Code World Model eine Genauigkeit von 94 Prozent. Auch in etablierten Software-Engineering-Tests wie SWE-Bench übertrifft CWM viele Open-Source-Modelle seiner Größenklasse und zeigt eine starke Leistung bei der Lösung mathematischer Probleme.

Meta betont, dass CWM aktuell ein reines Forschungsmodell ist und nicht für den produktiven Einsatz in Chatbots oder anderen Alltagswerkzeugen gedacht ist. Das Unternehmen hat das 32-Milliarden-Parameter-Modell zusammen mit seinen Trainings-Zwischenschritten auf der Plattform Hugging Face unter einer nicht-kommerziellen Forschungslizenz veröffentlicht. Damit öffnet Meta die Tür für Forscher weltweit, um auf dieser Grundlage aufzubauen und die nächste Generation von KI-Werkzeugen zu entwickeln, die Code nicht nur schreiben, sondern fundamental verstehen.

MITMACHEN

KURZFASSUNG

- Meta stellt mit CWM ein KI-Modell vor, das Code nicht nur schreibt, sondern dessen Ausführung simuliert.

- Das 32-Milliarden-Parameter-System lernte aus über 120 Mio. Python-Traces und 35 000 Docker-Containern.

- CWM erreicht 94% Genauigkeit bei HaltEval und übertrifft viele gleichgroße Open-Source-Modelle in SWE-Bench.

- Modell und Trainingscheckpoints sind unter nicht-kommerzieller Lizenz auf Hugging Face verfügbar.