Googles KI-Offensive: Gemma 3 für alle!

Dank cleverer Quantisierung läuft Googles KI-Monster sogar auf Consumer-Hardware – wie hat Google das geschafft?

Flux Schnell | All-AI.de

EINLEITUNG

Künstliche Intelligenz galt lange als Domäne großer Rechenzentren – teuer, energiehungrig und für Endnutzer kaum direkt nutzbar. Doch Google will das ändern. Mit Gemma 3 bringt der Konzern ein Sprachmodell auf den Markt, das auch auf Consumer-Hardware wie der RTX 3090 läuft – und das trotz 27 Milliarden Parametern. Möglich macht das eine clevere Technik namens Quantisierung. Aber wie schafft Google den Spagat zwischen Kompression und Leistung?

NEWS

Quantisierung: Wenn weniger mehr ist

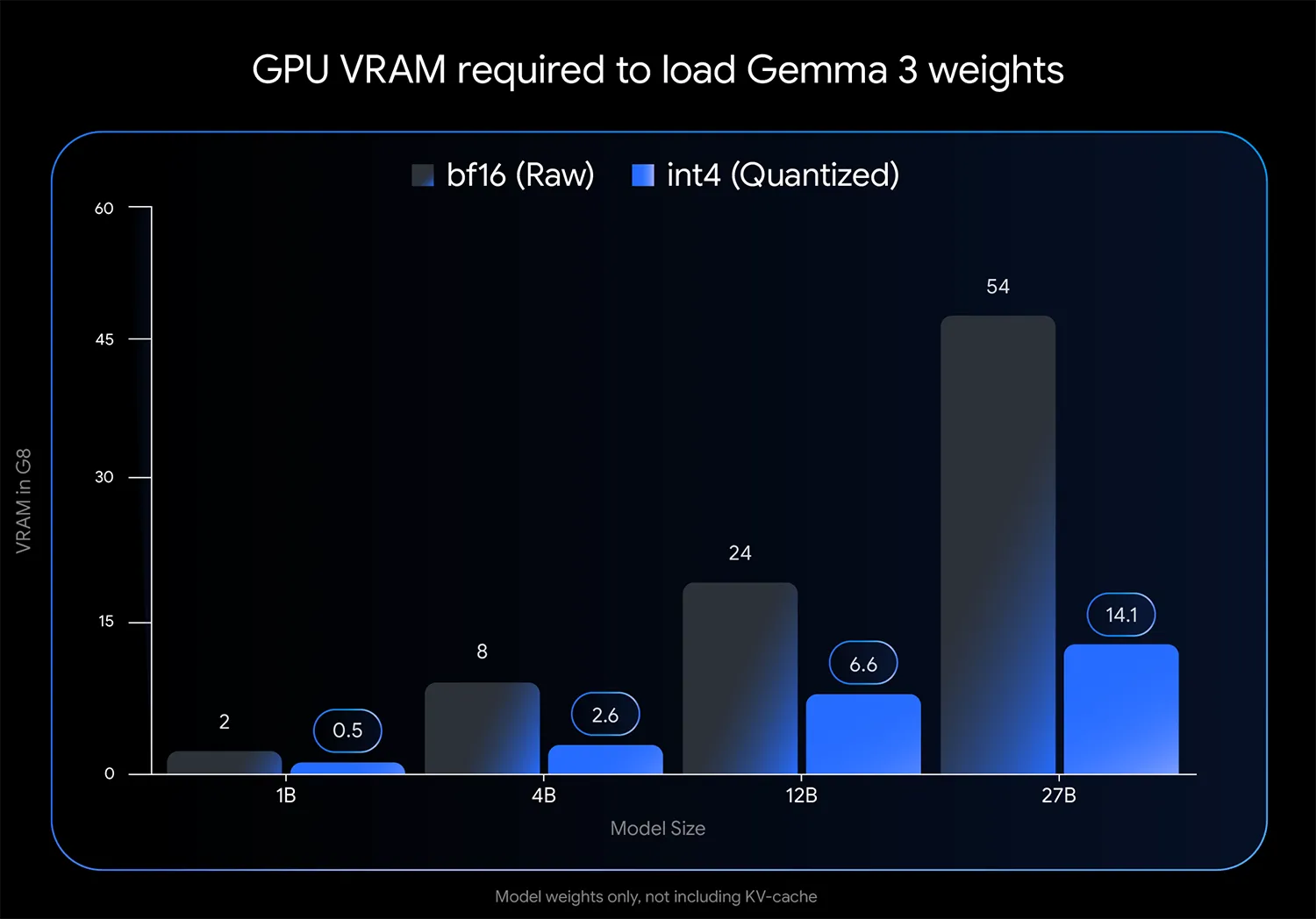

Was zunächst nach technischer Fußnote klingt, ist in Wahrheit ein Schlüsselelement der neuen KI-Strategie: Quantisierung. Statt die Rechenleistung weiter nach oben zu treiben, setzt Google auf Optimierung. Durch sogenanntes Quantization-Aware Training (QAT) lernen die Modelle schon während der Trainingsphase, mit geringerer Rechengenauigkeit zu arbeiten. Das Ergebnis: Modelle wie Gemma 3 27B, die im int4-Format mit gerade einmal 14,1 GB VRAM auskommen – früher waren dafür 54 GB nötig. Die Qualität bleibt dabei laut Google nahezu erhalten, was das Modell erstmals für viele Nutzer überhaupt praktikabel macht.

Quelle: Google

Offen, integriert, einsatzbereit

Doch Technik allein reicht nicht. Entscheidend ist, wie einfach sich die Modelle in bestehende Workflows einfügen. Und hier punktet Gemma 3 besonders. Die quantisierten Modelle laufen bereits mit Tools wie Ollama, LM Studio und Apples MLX. Auch llama.cpp und das eigens entwickelte gemma.cpp unterstützen die neuen Varianten im offenen GGUF-Format. Wer also bereits mit LLMs arbeitet, kann Gemma 3 fast plug-and-play nutzen – ganz ohne komplexe Anpassungen.

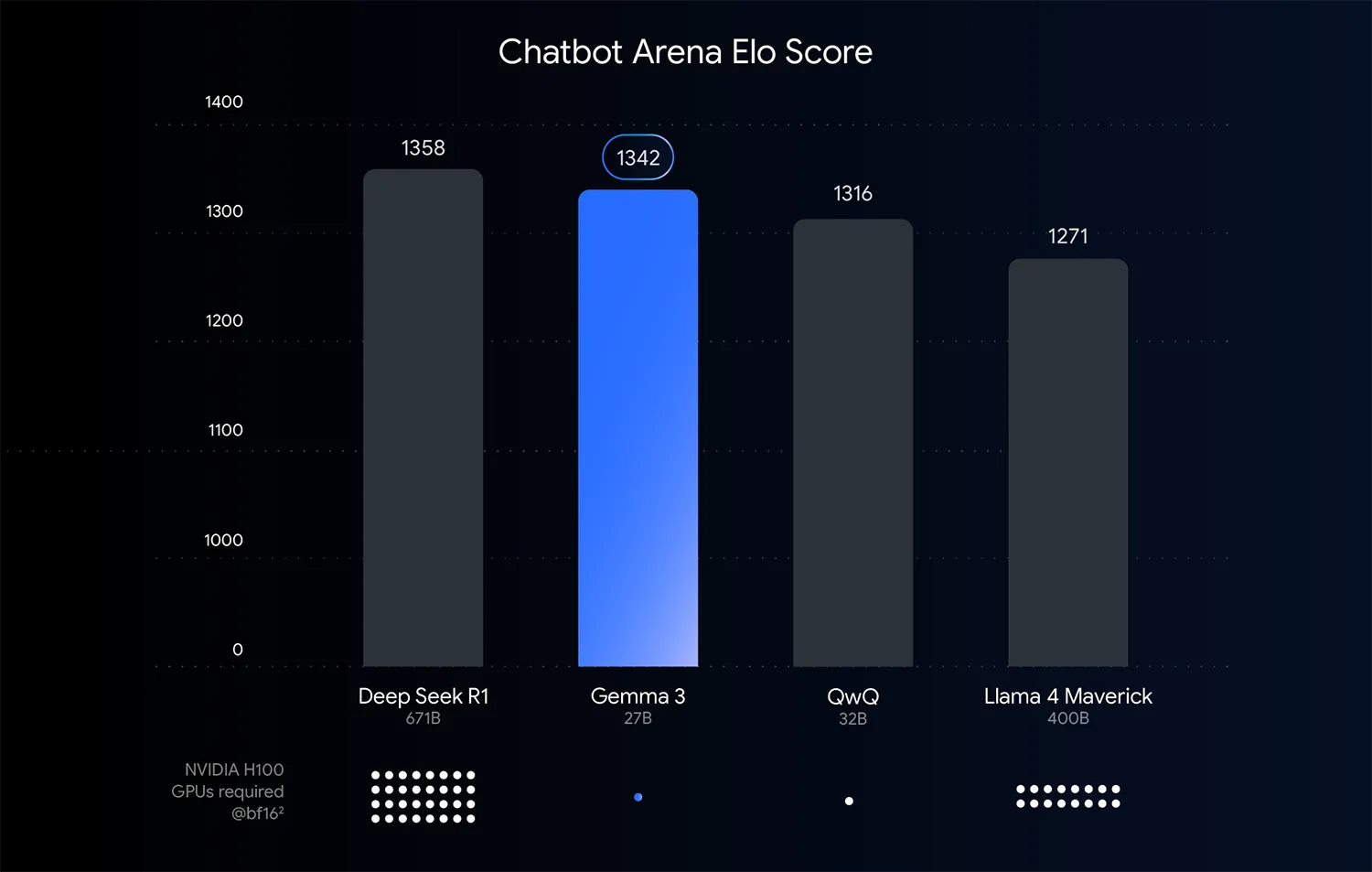

Viel kleiner (27B), trotzdem stark - Quelle: Google

Das Gemmaverse: Mehr als nur Google

Was das Modell zusätzlich spannend macht, ist die Community. Unter dem Namen „Gemmaverse“ entstehen täglich neue Varianten: feingetunte Derivate, andere Quantisierungsarten, experimentelle Features. Oft setzen diese auf klassische Nachbearbeitungs-Quantisierung statt QAT – das senkt die Einstiegshürde für Entwickler und bringt Vielfalt ins Spiel. So entsteht ein Ökosystem, das über Google hinauswächst und kreative Anwendungen jenseits des Mainstreams möglich macht.

AUSBLICK

KI für alle – oder zumindest für viele

Gemma 3 zeigt, dass große Modelle nicht zwangsläufig große Maschinen brauchen. Indem Google auf technische Eleganz statt rohe Power setzt, wird Hochleistungs-KI für deutlich mehr Menschen greifbar. Entwickler, Start-ups oder Bildungseinrichtungen – sie alle können nun KI auf Consumer-Hardware testen und nutzen. Wenn sich dieser Trend fortsetzt, könnte bald jeder Laptop zur Plattform für generative Intelligenz werden. Die große Frage bleibt: Wer nutzt diese neue Freiheit – und wofür?

UNTERSTÜTZUNG

Hat dir ein Artikel gefallen oder ein Tutorial geholfen? Du kannst uns weiterhelfen, indem du diese Seite weiterempfiehlst, uns auf Youtube abonnierst oder dich per Paypal an den Serverkosten beteiligst. Wir sind für jede Unterstützung dankbar. Danke.

KURZFASSUNG

- Google hat mit Gemma 3 ein leistungsstarkes Sprachmodell vorgestellt, das selbst auf Consumer-GPUs lauffähig ist.

- Durch Quantization-Aware Training wird eine effiziente Nutzung ohne Qualitätsverlust möglich.

- Die Integration in bestehende Tools und Workflows erleichtert die Nutzung erheblich.

- Das "Gemmaverse" erweitert durch Community-Initiativen die Vielfalt und Anwendbarkeit der Modelle.