BSI warnt: KI-Verzerrungen sind echte Sicherheitslücken

Ein praxisnaher Leitfaden zur Bias-Erkennung, Abwehr und Prävention – wie Unternehmen KI endlich verantwortungsvoll nutzen können?

gpt-image-1 | All-AI.de

EINLEITUNG

Das Bundesamt für Sicherheit in der Informationstechnik (BSI) warnt in einem aktuellen Whitepaper vor systematischen Verzerrungen in KI-Systemen – sogenannten Bias. Diese können nicht nur zu unfairen Entscheidungen führen, sondern stellen auch ein reales Sicherheitsrisiko dar. Das Dokument liefert konkrete Methoden zur Erkennung und Korrektur – und formuliert neue Anforderungen an den sicheren Umgang mit KI.

NEWS

Wo Bias entsteht – und warum er so gefährlich ist

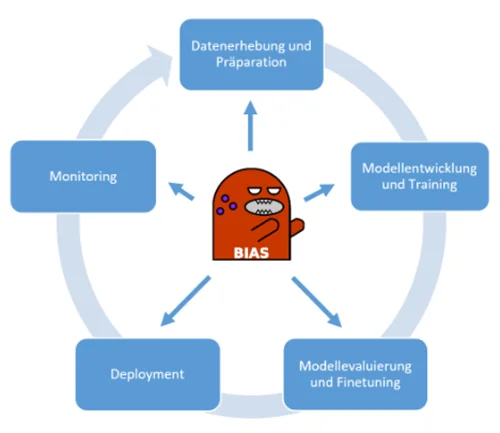

Bias kann in allen Phasen eines KI-Projekts entstehen: von der Datenerhebung über das Modelltraining bis zur konkreten Anwendung. Das BSI unterscheidet dabei unter anderem zwischen historischem Bias – etwa durch diskriminierende Trainingsdaten – und Repräsentationsbias, der aus ungleich verteilten Datensätzen resultiert. Wer also etwa ein Sprachmodell mit zu wenig Daten aus bestimmten Bevölkerungsgruppen füttert, riskiert falsche oder unausgewogene Antworten.

Das Whitepaper kartiert diese Verzerrungen entlang des gesamten KI-Lebenszyklus und bietet damit eine Art Frühwarnsystem für Entwickler, Projektleiter und Betreiber. Ziel ist es, Bias nicht nur rückblickend zu analysieren, sondern frühzeitig zu erkennen und proaktiv gegenzusteuern – etwa durch Datenanalysen oder gezielte Auditierungsprozesse.

Technische Ansätze zur Bias-Kontrolle

Im Zentrum der vorgeschlagenen Maßnahmen steht eine Kombination aus qualitativen und quantitativen Verfahren. Fairnessmetriken, Varianztests und Balanced Sampling sollen helfen, strukturelle Ungleichgewichte im Training zu erkennen und zu beheben. Auch Modellanpassungen nach dem Training werden explizit empfohlen, etwa über gezielte Regularisierungen.

Besonders wichtig sei es laut BSI, diesen Prozess nicht als einmalige Aufgabe zu sehen. Stattdessen müsse Bias-Kontrolle über den gesamten Lebenszyklus eines KI-Produkts hinweg etabliert werden. Hierfür soll jede KI-Anwendung eine benannte Ansprechperson erhalten, die für Monitoring und Gegenmaßnahmen verantwortlich ist – ähnlich wie bei klassischen Sicherheitsbeauftragten.

Quelle: BSI

Wenn Bias zur Schwachstelle wird

Was das Whitepaper besonders lesenswert macht, ist der sicherheitstechnische Blickwinkel. Bias sei nicht nur ein ethisches Problem, sondern ein potenzieller Angriffsvektor. Besonders bei sogenannten Poisoning-Angriffen könne gezielter Bias genutzt werden, um Systeme zu manipulieren oder sogar lahmzulegen.

Das betrifft vor allem kritische Infrastrukturen, in denen KI-Systeme automatisierte Entscheidungen treffen – sei es in der Energieversorgung, im Finanzsektor oder im Gesundheitswesen. Werden solche Systeme durch manipulative Daten bewusst verzerrt, können sie falsche Einschätzungen liefern oder Sicherheitslücken offenbaren.

Organisatorische Vorgaben für mehr Robustheit

Neben technischen Lösungen empfiehlt das BSI auch strukturelle Maßnahmen. Für jede KI-gestützte Anwendung soll eine Art Bias-Logbuch geführt werden, das Datenquellen, Bearbeitungsmethoden und getroffene Fairnessmaßnahmen dokumentiert. Zusätzlich fordert das Whitepaper regelmäßige Bias-Audits – idealerweise durch externe Stellen.

Damit entsteht ein Framework, das Bias nicht nur sichtbar macht, sondern auch nachvollziehbar behandelt. Besonders für Unternehmen, die auf regulatorische Anforderungen reagieren müssen, bietet der Leitfaden praxisnahe Ansätze, um sich auf kommende Vorschriften vorzubereiten.

Eine klare Botschaft an die Praxis

Das Whitepaper hebt sich durch seinen nüchternen, sicherheitsorientierten Fokus von vielen ethisch aufgeladenen Debatten ab. Bias wird hier als technisches und organisatorisches Problem behandelt – mit klaren Handlungsempfehlungen. Für alle, die KI nicht nur nutzen, sondern verantworten, ist dieser Leitfaden ein Werkzeugkasten. Wer ihn ignoriert, riskiert nicht nur schlechte Ergebnisse, sondern auch reale Schäden.

DEIN VORTEIL - DEINE HILFE

KURZFASSUNG

- Das BSI warnt in einem neuen Whitepaper vor Bias in KI-Systemen und deren potenziellen Sicherheitsrisiken.

- Verzerrungen entstehen im gesamten Lebenszyklus eines KI-Projekts und lassen sich mit technischen und organisatorischen Maßnahmen erkennen und minimieren.

- Besonders kritisch: Angriffe können gezielt vorhandene Bias-Schwächen ausnutzen, um Systeme zu manipulieren.

- Das Whitepaper fordert klare Verantwortlichkeiten, permanente Kontrollen und dokumentierte Fairnessanalysen.