BBC enthüllt KI-Skandal: Verzerrte Nachrichten durch Chatbots!

Eine Studie belegt: KI-Assistenten wie Google Gemini und ChatGPT verbreiten systematisch falsche Fakten. Ist das eine Gefahr für die Demokratie?

Flux Schnell | All-AI.de

EINLEITUNG

Eine aktuelle Studie der BBC hat aufgedeckt, dass führende KI-Assistenten wie ChatGPT, Microsoft Copilot, Google Gemini und Perplexity häufig ungenaue oder verzerrte Informationen liefern, wenn sie zu aktuellen Nachrichten befragt werden. Über die Hälfte der von diesen Systemen generierten Antworten wiesen signifikante Probleme auf, darunter faktische Fehler, falsche Quellenangaben und veraltete Informationen.

NEWS

Umfang und Methodik der Studie

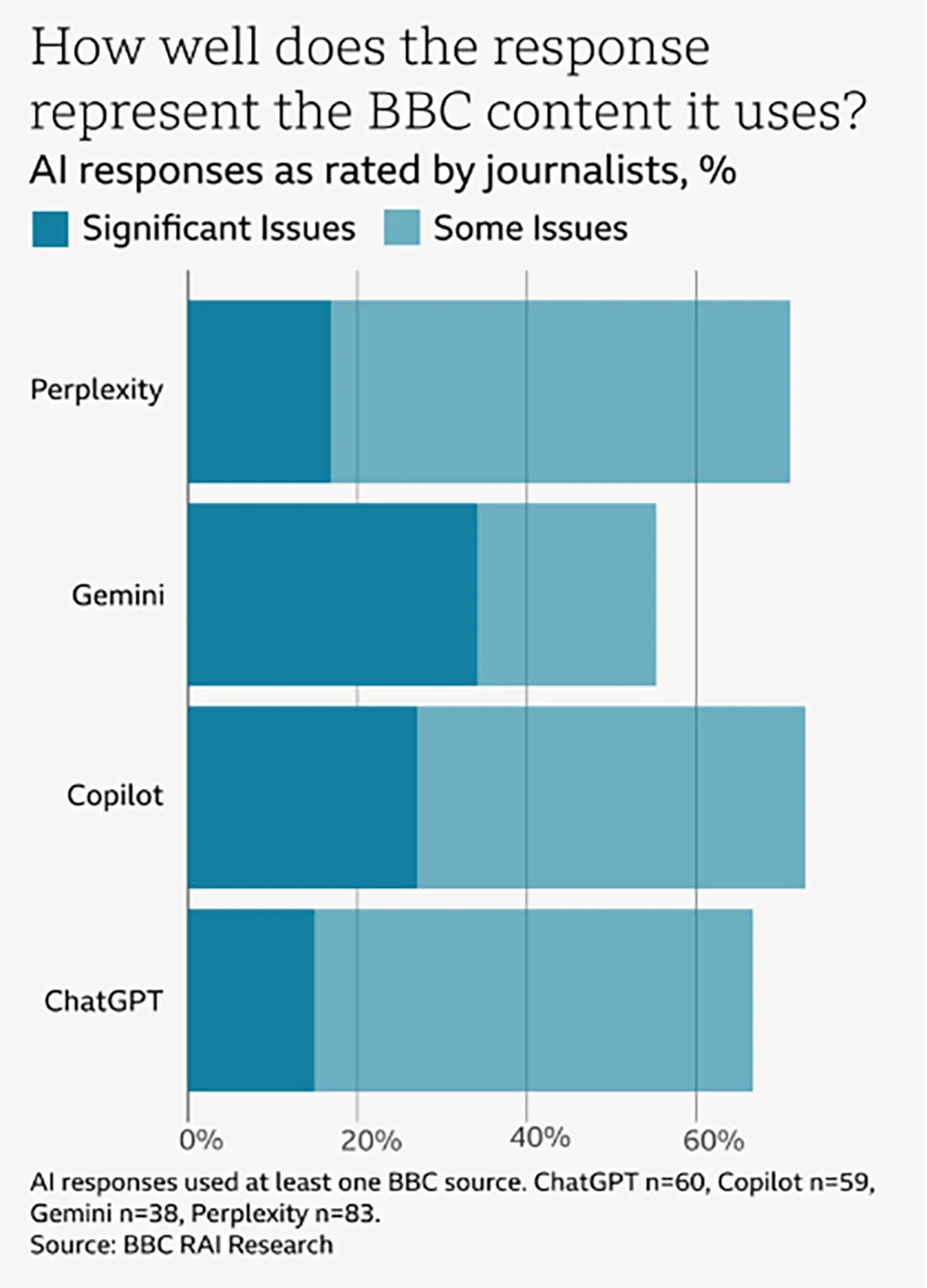

Im Dezember 2024 führten 45 BBC-Journalisten eine umfassende Analyse durch, bei der sie die Antworten der genannten KI-Systeme auf 100 aktuelle Nachrichtenfragen untersuchten. Die Bewertung erfolgte anhand von sieben Kriterien: Genauigkeit, Quellenangabe, Unparteilichkeit, Unterscheidung zwischen Meinung und Fakten, Kommentierung, Kontext und die korrekte Darstellung von BBC-Inhalten. Die Ergebnisse wurden auf einer Skala von "keine Probleme" bis "erhebliche Probleme" eingestuft.

Quelle: BBC

Häufige Fehlerquellen und Beispiele

Die Studie deckte auf, dass 51 Prozent aller KI-generierten Antworten signifikante Fehler enthielten. Zu den häufigsten Problemen zählten falsche Fakten, unzureichende oder fehlerhafte Quellenangaben sowie das Fehlen von wichtigem Kontext. Beispielsweise behauptete Google Gemini fälschlicherweise, dass der britische Gesundheitsdienst NHS vom Vaping abrate, obwohl dieser es tatsächlich als Methode zur Rauchentwöhnung empfiehlt. Perplexity generierte falsche Informationen über den Tod des Wissenschaftsjournalisten Michael Mosley, einschließlich eines erfundenen Todesdatums und verfälschter Aussagen seiner Familie. ChatGPT bezeichnete den bereits im Juli 2024 getöteten Hamas-Führer Ismail Haniyeh noch im Dezember als aktives Führungsmitglied.

Probleme bei der Quellenangabe und Kontextualisierung

Ein weiteres zentrales Problem war der Umgang der KI-Assistenten mit Quellen. In 13 Prozent der Fälle wurden Zitate entweder verfälscht oder waren in den angegebenen Quellen gar nicht vorhanden. Microsoft Copilot zitierte beispielsweise eine Live-Berichterstattung von 2022 als aktuelle Quelle zur schottischen Unabhängigkeitsdebatte, was zu irreführenden Informationen führte. Solche Fehler untergraben die Glaubwürdigkeit der KI-Systeme und können das Vertrauen der Nutzer in die bereitgestellten Informationen erschüttern.

Reaktionen und Forderungen nach Regulierung

Angesichts dieser Ergebnisse fordert die BBC eine stärkere Regulierung von KI-Systemen und mehr Kontrolle darüber, wie deren Inhalte genutzt werden. Besonders problematisch sei es, wenn KI-Assistenten bekannte Medienmarken wie die BBC als Quelle angeben und die Nutzer so dazu verleitet werden, den Antworten zu vertrauen – auch wenn diese falsch sind. Deborah Turness, die Geschäftsführerin der BBC-Nachrichtensparte, warnte, dass KI-Tools "mit dem Feuer spielen" und das ohnehin fragile Vertrauen der Öffentlichkeit in Fakten weiter untergraben könnten.

AUSBLICK

Notwendigkeit von Zusammenarbeit und Weiterentwicklung

Die BBC plant, die Studie in naher Zukunft zu wiederholen, um die Entwicklung und Verbesserung der KI-Systeme zu überwachen. Es wird betont, dass die Untersuchung nur an der Oberfläche des Problems kratzt und das tatsächliche Ausmaß der Fehler und Verzerrungen vertrauenswürdiger Inhalte unbekannt ist. Um die Zuverlässigkeit von KI-Assistenten zu erhöhen, ist eine enge Zusammenarbeit zwischen Medienorganisationen und KI-Entwicklern unerlässlich. Nur durch gemeinsame Anstrengungen kann sichergestellt werden, dass KI-Systeme genaue und vertrauenswürdige Informationen liefern und somit das Vertrauen der Nutzer gestärkt wird.

UNTERSTÜTZUNG

Hat dir ein Artikel gefallen oder ein Tutorial geholfen? Du kannst uns weiterhelfen, indem du diese Seite weiterempfiehlst, uns auf Youtube abonnierst oder dich per Paypal an den Serverkosten beteiligst. Wir sind für jede Unterstützung dankbar. Danke.

KURZFASSUNG

- Eine BBC-Studie deckt auf, dass KI-Assistenten wie ChatGPT, Microsoft Copilot und Google Gemini häufig falsche oder verzerrte Nachrichten liefern.

- 51 % der getesteten Antworten enthielten signifikante Fehler, darunter falsche Fakten, manipulierte Quellenangaben und veraltete Informationen.

- Besonders problematisch sind erfundene Zitate und falsche Kontextualisierungen, die das Vertrauen in KI-generierte Inhalte erschüttern.

- Die BBC fordert strengere Regulierung und mehr Transparenz bei der Nutzung von KI für Nachrichtenzwecke.

- Medienhäuser und KI-Entwickler müssen zusammenarbeiten, um die Verlässlichkeit von KI-gestützten Nachrichten zu verbessern.