Llama 3.2: Metas KI-Revolution für Smartphones und Bildanalyse

So bringt Meta KI auf dein Smartphone – schneller, sicherer und leistungsstärker!

Meta | All-AI.de

Worum geht es?

Meta hat mit Llama 3.2 die nächste Generation seiner KI-Modelle vorgestellt. Diesmal richtet sich die Veröffentlichung sowohl an Entwickler mobiler Anwendungen als auch an diejenigen, die Vision-Modelle für die Bildverarbeitung benötigen. Neben einer verbesserten Leistung setzt Meta dabei auf offene Zugänglichkeit und einen breiten Hardware-Support. Doch welche Neuerungen bringt Llama 3.2 tatsächlich, und welche Auswirkungen könnte dies auf den KI-Markt haben?

News

Die neuen Llama-Modelle: Flexibel und vielseitig

Llama 3.2 beinhaltet insgesamt vier Modelle, die in zwei Kategorien unterteilt sind: kleine und leichte Textmodelle sowie große Vision-Modelle. Die leichten Textmodelle umfassen Versionen mit 1 Milliarde (1B) und 3 Milliarden (3B) Parametern. Diese wurden speziell für den Einsatz auf mobilen Geräten und für lokale Anwendungen optimiert. Die beiden größeren Vision-Modelle besitzen 11 Milliarden (11B) und 90 Milliarden (90B) Parameter und eignen sich für anspruchsvolle Aufgaben im Bereich der Bildverarbeitung.

Optimierung für mobile Geräte

Eine der Hauptinnovationen der neuen Llama-Modelle liegt in ihrer Optimierung für mobile Endgeräte. Um dies zu ermöglichen, hat Meta eng mit wichtigen Hardware-Herstellern wie Qualcomm, MediaTek und Arm zusammengearbeitet. Die beiden neuen Textmodelle (1B und 3B) sind auf eine schnelle lokale Verarbeitung ausgelegt, wodurch Datenschutz und Geschwindigkeit profitieren. Die Daten bleiben auf dem Gerät, ohne dass eine Verbindung zu einem Cloud-Service erforderlich ist.

Um die Modelle auf mobilen Geräten betreiben zu können, setzt Meta auf eine Kombination aus „Pruning“ (Beschneidung) und „Knowledge Distillation“ (Wissensübertragung). Beim „Pruning“ werden Teile des neuronalen Netzes entfernt und die Gewichte angepasst, um eine effiziente Performance bei geringem Ressourcenverbrauch zu gewährleisten. „Knowledge Distillation“ hilft dabei, Wissen von größeren Modellen auf die kleineren Modelle zu übertragen, was deren Leistungsfähigkeit trotz geringerer Größe erhöht.

Quelle: Meta

Leistungsstarke Vision-Modelle für Bildverarbeitung

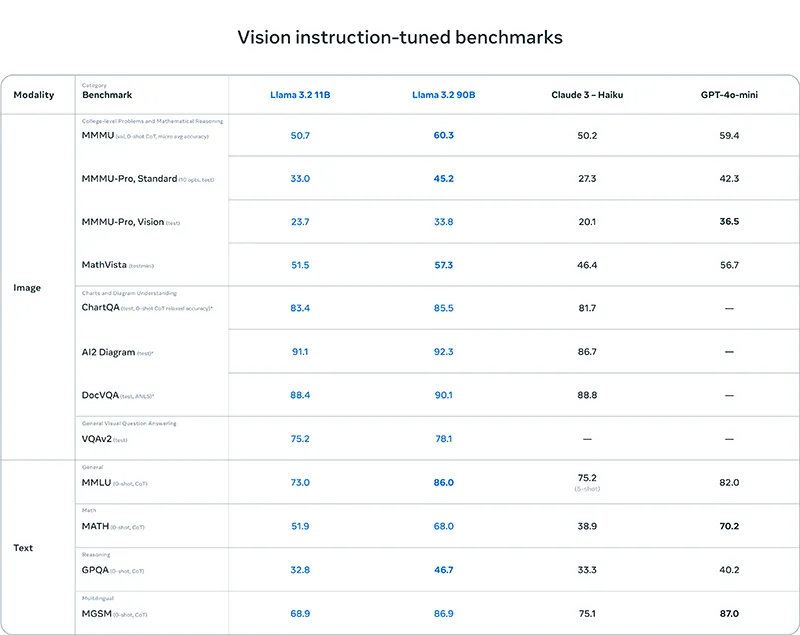

Die zweite Gruppe der neuen Llama-Modelle richtet sich an den Bereich der Bildverarbeitung. Llama 3.2 präsentiert erstmals zwei Vision-Modelle (11B und 90B), die in der Lage sind, komplexe Bildverarbeitungsaufgaben zu übernehmen. Sie können Dokumente verstehen, Grafiken analysieren und sogar Objekte in Bildern basierend auf natürlichen Sprachbeschreibungen erkennen.

Die Vision-Modelle wurden speziell trainiert, um eine nahtlose Integration zwischen Sprache und Bild zu ermöglichen. Dank einer neuen Architektur, die zusätzliche Adapter-Gewichte einsetzt, kann der vortrainierte Bildencoder in das Sprachmodell integriert werden. Dies schafft die Grundlage für vielseitige Anwendungen, bei denen Text und Bild miteinander interagieren.

Quelle: Meta

Offene und lokale KI: Mehr Flexibilität für Entwickler

Ein weiteres Highlight von Llama 3.2 ist die Verfügbarkeit offener und leicht modifizierbarer Modelle. Sowohl die leichten Textmodelle als auch die großen Vision-Modelle sind als vortrainierte und abgestimmte Versionen verfügbar, sodass Entwickler sie einfach für individuelle Anwendungen anpassen können. Mit Tools wie „torchtune“ und „torchchat“ lassen sich die Modelle zudem lokal einsetzen und für spezielle Einsatzbereiche feinabstimmen.

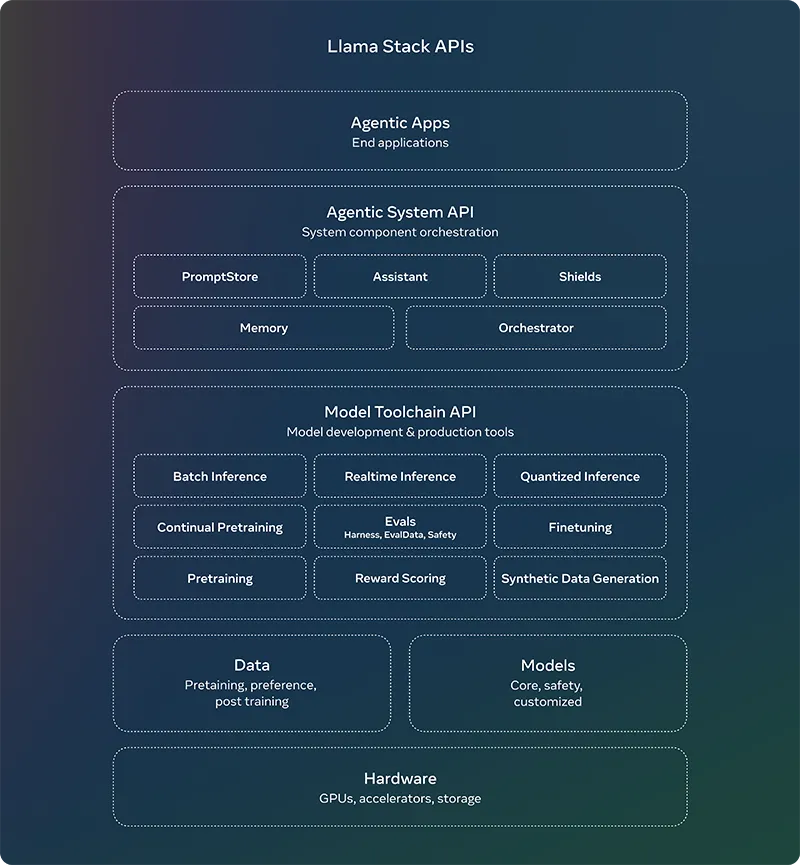

Llama-Stack: Vereinfachte Entwicklung mit KI

Zusammen mit Llama 3.2 hat Meta die „Llama Stack“-Distributionen vorgestellt. Diese sollen die Arbeit mit den Llama-Modellen in verschiedenen Umgebungen wie Cloud, On-Premise oder auf mobilen Geräten vereinfachen. Durch die Zusammenarbeit mit Partnern wie AWS, Databricks und Dell ermöglicht Llama Stack eine schlüsselfertige Bereitstellung von Retrieval-Augmented-Generation-Anwendungen (RAG) sowie die Integration von Tools. Entwicklern wird dadurch ein einheitliches Interface geboten, um KI-gestützte Lösungen effizienter zu entwickeln.

Quelle: Meta

Metas Motivation: Offenheit und Innovation

Meta betont, dass die Veröffentlichung der Llama-Modelle auf dem Prinzip der Offenheit basiert. In den letzten Monaten hat sich das Unternehmen zu einem der Vorreiter in der offenen KI-Entwicklung etabliert. Die Llama-Modelle sollen Entwickler weltweit dabei unterstützen, innovative und nützliche Anwendungen zu schaffen, ohne sich auf proprietäre oder kostenintensive Modelle verlassen zu müssen.

Konkurrenz im Open-Source-Bereich

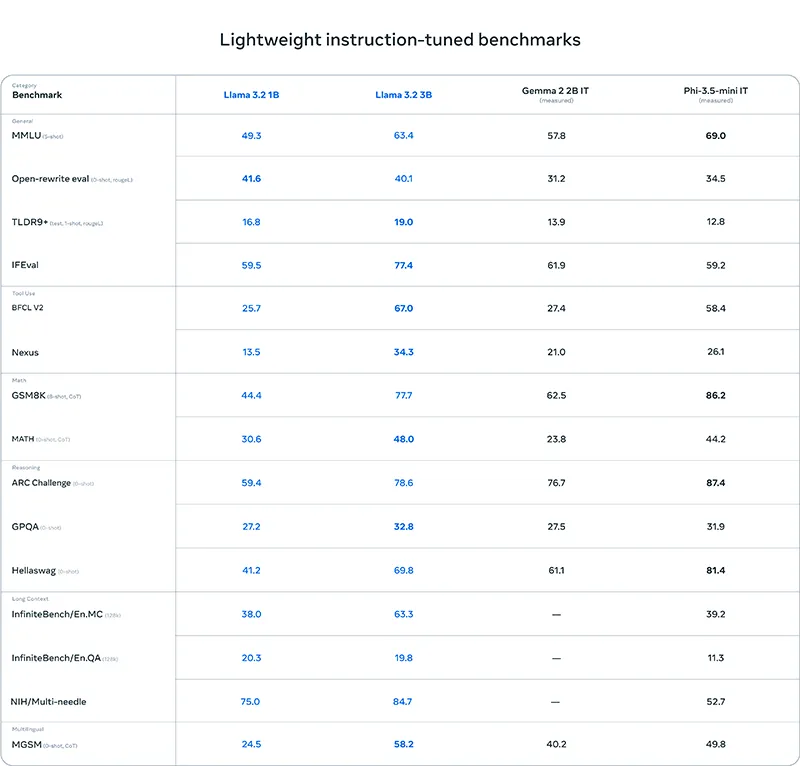

Mit Llama 3.2 tritt Meta in direkte Konkurrenz zu anderen offenen Modellen wie Mistrals Pixtral. Während Pixtral jedoch eine deutlich kleinere Parameteranzahl aufweist, bieten die Llama-3.2-Modelle dank ihrer Größe und Vielseitigkeit mehr Einsatzmöglichkeiten und eine vergleichbare Leistung zu führenden geschlossenen Modellen wie Claude 3 Haiku und GPT-4o-mini.

Datenschutz und Geschwindigkeit: Die Vorteile lokaler Modelle

Ein zentrales Argument für die neuen Llama-Modelle ist der verbesserte Datenschutz und die erhöhte Geschwindigkeit bei der lokalen Verarbeitung. Da die Textmodelle auf dem Gerät laufen, müssen sensible Daten wie Nachrichten und Kalendereinträge nicht an externe Server gesendet werden. Dies kommt besonders in datenschutzsensiblen Umgebungen zum Tragen und ermöglicht es, Anwendungen zu entwickeln, die auf dem Gerät selbst agieren.

Ausblick

Llama 3.2 stellt eine Weiterentwicklung der Llama-Reihe dar und bringt sowohl optimierte Modelle für mobile Geräte als auch leistungsfähige Vision-Modelle auf den Markt. Damit möchte Meta die KI-Entwicklung weiter demokratisieren und Entwicklern weltweit neue Werkzeuge an die Hand geben. Der lokale Einsatz bringt Vorteile in puncto Geschwindigkeit und Datenschutz, was in Zeiten zunehmender Datenschutzbedenken ein entscheidender Vorteil sein könnte. Die Zukunft wird zeigen, ob Llama 3.2 in der Praxis die Erwartungen erfüllt und sich gegenüber etablierten Lösungen durchsetzen kann. Insgesamt zeigt Meta jedoch, dass KI nicht nur für große Rechenzentren gedacht ist, sondern auch auf kleinen Geräten eine immer größere Rolle spielen wird.

Short

- Meta veröffentlicht mit Llama 3.2 neue KI-Modelle für mobile Geräte und Bildverarbeitung.

- Die Textmodelle sind optimiert für lokale Verarbeitung, was Datenschutz und Geschwindigkeit verbessert.

- Die neuen Vision-Modelle können Bilder analysieren und natürliche Sprache verstehen.

- Mit „Llama Stack“ erleichtert Meta die Entwicklung von KI-Anwendungen in verschiedenen Umgebungen.

- Meta setzt auf Offenheit und Zusammenarbeit, um KI-Entwicklung für alle zugänglich zu machen.