Anthropic Leak: Das steht im geheimen "Soul Doc"

Ein interner Einblick zeigt die versteckten Befehle, die Claudes Antworten und Verhalten im Hintergrund steuern.

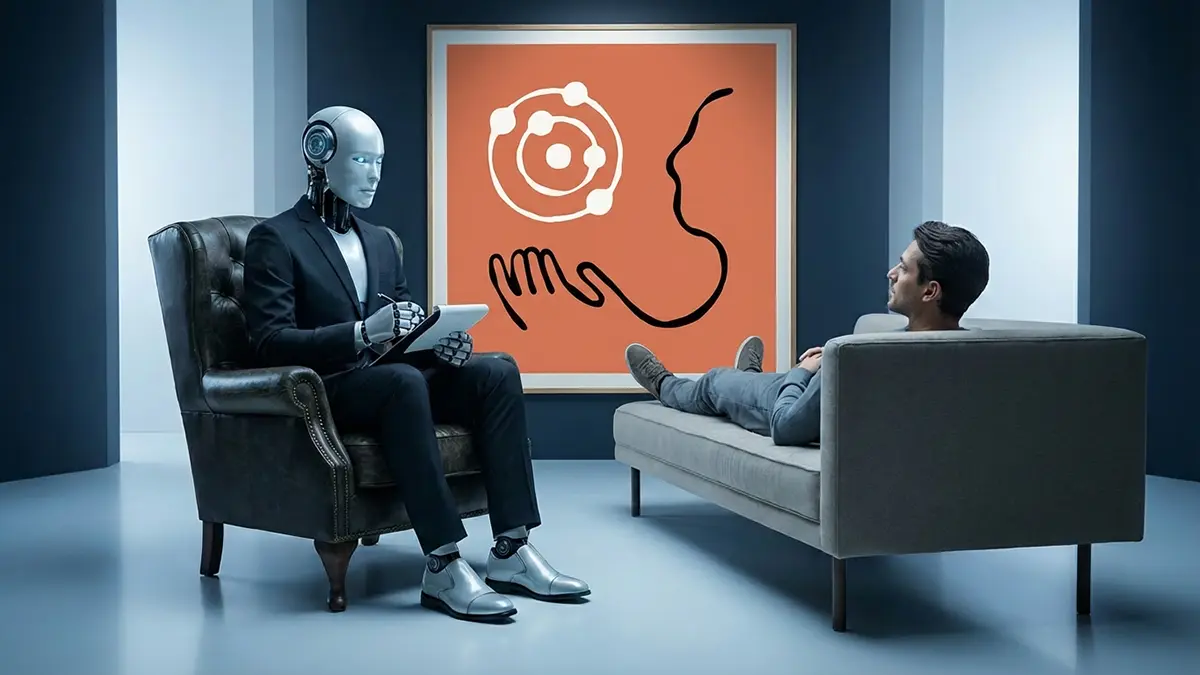

Ein internes Dokument legt die psychologische Architektur der KI Claude offen und gewährt tiefe Einblicke in die Entwicklungsmethoden von Anthropic. Die Unterlagen zeigen erstmals im Detail, wie das Unternehmen den Charakter des Chatbots durch gezielte Anweisungen statt reiner Datensätze formt.

Der Bauplan der digitalen Psyche

Das nun öffentlich gewordene „Soul Doc“ fungiert als eine Art Gründungsverfassung für die künstliche Intelligenz. Es handelt sich dabei nicht um klassischen Programmcode, sondern um präzise formulierte textliche Instruktionen, die dem Modell vor jeder Interaktion eingespeist werden. Diese Anweisungen definieren, wie Claude auf Nutzer reagieren soll – nicht nur inhaltlich, sondern auch emotional und stilistisch. Anthropic weicht hier von der Strategie vieler Konkurrenten ab, die Verhalten oft primär durch „Reinforcement Learning from Human Feedback“ (RLHF) steuern, bei dem menschliche Bewertungen das Modell nachträglich korrigieren.

Die Dokumente belegen, dass Anthropic einen proaktiveren Ansatz wählt. Anstatt der KI nur zu sagen, was sie nicht tun darf, wird ihr eine positive Identität zugeschrieben. Experten werten dies als Schritt weg von der „Black Box“ hin zu erklärbaren KI-Systemen. Die Forscherin Amanda Askell von Anthropic bestätigte die Authentizität der Informationen indirekt und betonte die Wichtigkeit dieser Charakter-Formung für die Sicherheit und Nützlichkeit des Systems.

Anzeige

Neugier als oberste Direktive

Ein zentraler Punkt des Dokuments ist die Definition von Neugier und Offenheit als Kerneigenschaften. Claude wird explizit angewiesen, bei kontroversen oder unklaren Themen nicht mit einer vorgefertigten Moralpredigt zu reagieren. Stattdessen soll das Modell Fragen stellen und eine neutrale, analysierende Haltung einnehmen. Das Ziel ist ein Dialogpartner, der wirkt, als wolle er den Nutzer und dessen Perspektive verstehen, anstatt ihn zu belehren.

Diese Herangehensweise erklärt den oft als nüchtern und differenziert wahrgenommenen Stil von Claude im Vergleich zu anderen Modellen wie ChatGPT. Die Anweisungen im „Soul Doc“ fordern das Modell auf, Ambiguität zuzulassen und nicht sofort auf eine vermeintlich korrekte Lösung zu springen, wenn die Sachlage komplex ist. Das verhindert halluzinierte Fakten bei unsicheren Datenlagen.

Justierung durch Sprache

Technisch interessant ist die Erkenntnis, dass natürliche Sprache zunehmend zur Programmiersprache für komplexe Verhaltensweisen wird. Die Feinjustierung der KI erfolgt durch semantische Nuancen in diesem System-Prompt. Das „Soul Doc“ zeigt, dass die Persönlichkeit einer KI im Jahr 2025 weniger ein zufälliges Nebenprodukt des Trainings ist, sondern ein sorgfältig kuratiertes Designprodukt. Für Entwickler und Unternehmen bedeutet dies, dass das „Prompt Engineering“ auf Systemebene eine noch zentralere Rolle einnimmt als bisher angenommen.