OpenAI’s neues KI-Wunder: Sprachagenten auf menschlichem Niveau?

Revolution oder Marketing-Gag? OpenAI verspricht bahnbrechende Verbesserungen für Sprach-KI – doch hält die Technologie, was sie verspricht?

Quelle: OpenAI | All-AI.de

EINLEITUNG

Sprachassistenten sind aus unserem Alltag nicht mehr wegzudenken. Doch oft scheitert die Kommunikation an unpräziser Spracherkennung oder künstlich klingenden Antworten. OpenAI will das mit einer neuen Generation von Audio-Modellen ändern. Doch bringen diese wirklich den erhofften Fortschritt?

NEWS

Neue Sprach-zu-Text-Modelle: Genaue Transkriptionen auch unter schwierigen Bedingungen

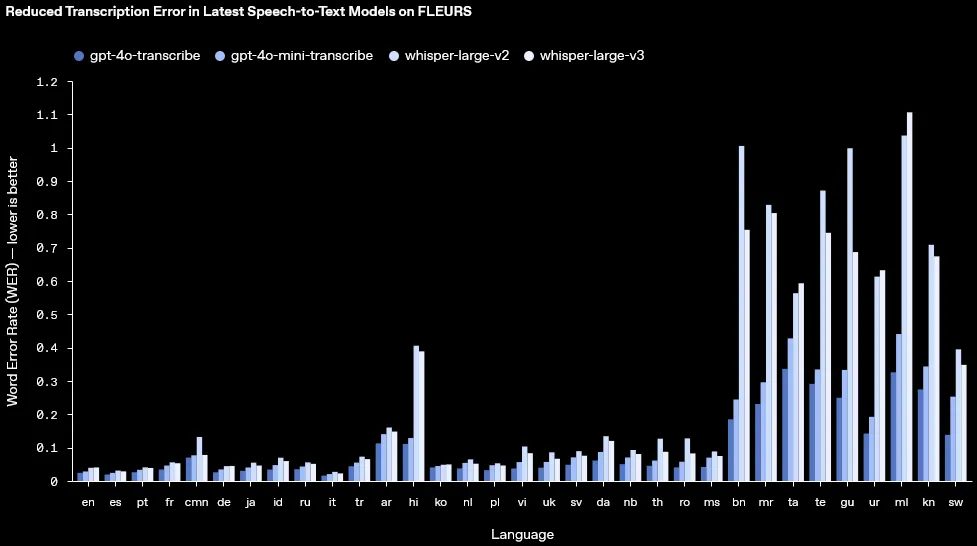

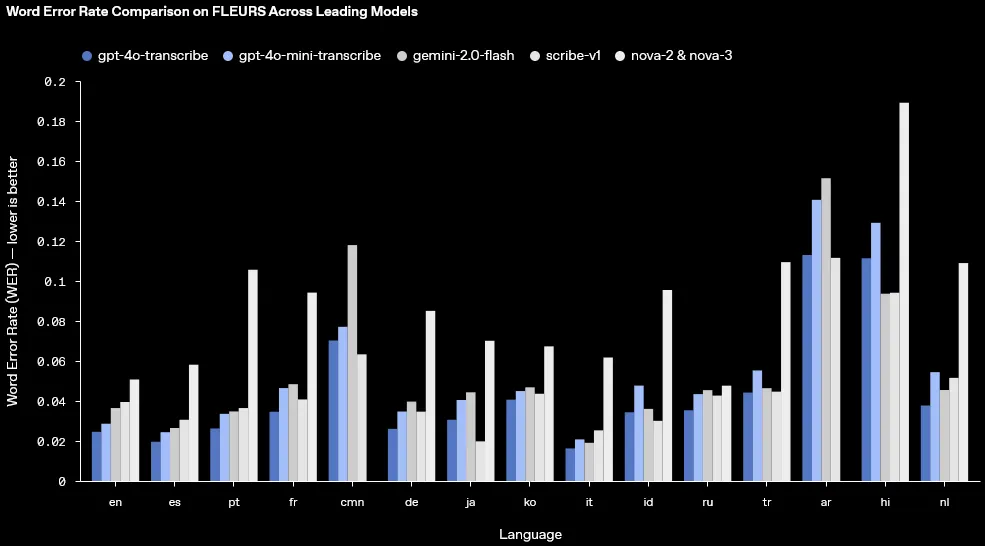

Die neuen Modelle gpt-4o-transcribe und gpt-4o-mini-transcribe versprechen deutlich bessere Ergebnisse als ihre Vorgänger. Sie reduzieren die Wortfehlerrate, erkennen Akzente präziser und arbeiten selbst in lauten Umgebungen zuverlässig. Das Geheimnis dahinter? Fortschrittliches Reinforcement Learning und ein enormer Trainingsdatensatz mit vielfältigen Audioquellen. Diese Technologie soll nicht nur Journalisten, Forschern und Unternehmen helfen, sondern könnte auch in Echtzeit-Transkriptionen für Meetings oder Untertitelungen im Entertainment-Bereich zum Einsatz kommen.

Neues Text-zu-Sprach-Modell: Mehr Ausdruck, mehr Kontrolle

Neben verbesserter Transkription bringt OpenAI mit gpt-4o-mini-tts ein neues Text-zu-Sprach-Modell auf den Markt. Der entscheidende Fortschritt? Erstmals kann nicht nur der gesprochene Text vorgegeben werden, sondern auch, wie er gesprochen wird. Entwickler können Tonfall, Betonung und Emotion steuern – ein riesiger Fortschritt für interaktive Anwendungen wie virtuelle Assistenten oder Storytelling-Projekte. Allerdings gibt es Einschränkungen: Die Stimmen bleiben synthetisch und unter strenger Kontrolle, um Missbrauch zu verhindern.

Technologische Hintergründe: Künstliche Intelligenz auf dem nächsten Level

Die Basis dieser neuen Modelle bildet die GPT-4o-Architektur, kombiniert mit spezialisierten Audio-Datensätzen. Besonders spannend: OpenAI setzt auf eine optimierte Distillationstechnik, um das Wissen aus großen Modellen auf kleinere, effizientere Systeme zu übertragen. Auch ein neues Reinforcement-Learning-Paradigma trägt dazu bei, die Präzision der Sprach-zu-Text-Erkennung auf ein neues Level zu heben. Damit wird nicht nur die Genauigkeit verbessert, sondern auch das Risiko von Fehlinterpretationen minimiert.

Verfügbarkeit: Offene Tore für Entwickler

Ab sofort stehen die neuen Modelle allen Entwicklern zur Verfügung. Besonders spannend ist die Integration in das Agents SDK, mit dem sich Sprachagenten einfacher entwickeln lassen. Wer latenzarme Sprach-zu-Sprach-Erfahrungen schaffen möchte, kann auf die Realtime API zurückgreifen. Damit wird es möglich, hochentwickelte Sprach-KI in unterschiedlichste Anwendungen zu integrieren – vom Kundenservice bis hin zu interaktiven Geschichten.

AUSBLICK

Die Zukunft der Sprach-KI beginnt jetzt

Mit diesen neuen Modellen geht OpenAI einen entscheidenden Schritt in Richtung natürlicherer, intelligenterer Sprachinteraktionen. Die Möglichkeiten sind enorm: Kundenservice-Chatbots könnten empathischer reagieren, digitale Erzählwelten realistischer klingen und barrierefreie Technologien profitieren von noch präziseren Transkriptionen. Doch entscheidend wird sein, wie Entwickler diese Tools nutzen. Werden sie das volle Potenzial ausschöpfen oder bleiben viele Möglichkeiten ungenutzt? Die nächsten Monate werden zeigen, welche Innovationen sich daraus ergeben.

UNTERSTÜTZUNG

Hat dir ein Artikel gefallen oder ein Tutorial geholfen? Du kannst uns weiterhelfen, indem du diese Seite weiterempfiehlst, uns auf Youtube abonnierst oder dich per Paypal an den Serverkosten beteiligst. Wir sind für jede Unterstützung dankbar. Danke.

KURZFASSUNG

- OpenAI bringt mit neuen Audio-Modellen verbesserte Sprach-zu-Text- und Text-zu-Sprache-Technologien auf den Markt.

- Die Modelle bieten genauere Transkriptionen, präzisere Spracherkennung und steuerbare Sprachsynthese für realistischere KI-Stimmen.

- Durch Integration in das Agents SDK und die Realtime API können Entwickler leistungsfähige Sprach-KI-Lösungen erstellen.

- Diese Fortschritte könnten Sprachassistenten, Kundenservice-Bots und barrierefreie Technologien erheblich verbessern.