Mistral Small 3: Effiziente KI-Power für alle

Das neue Open-Source-Modell von Mistral AI bietet beeindruckende Leistung mit nur 24 Milliarden Parametern – jetzt verfügbar.

Flux Schnell | All-AI.de

EINLEITUNG

Das europäische KI-Startup Mistral AI hat mit der Veröffentlichung von Mistral Small 3 ein neues Sprachmodell vorgestellt, das trotz seiner kompakten Größe von 24 Milliarden Parametern eine Leistung erbringt, die mit deutlich größeren Modellen vergleichbar ist. Dieses Modell zielt darauf ab, die Effizienz und Geschwindigkeit in generativen KI-Anwendungen zu maximieren und dabei die Einsatzkosten erheblich zu senken.

NEWS

Hintergrund und Entwicklung

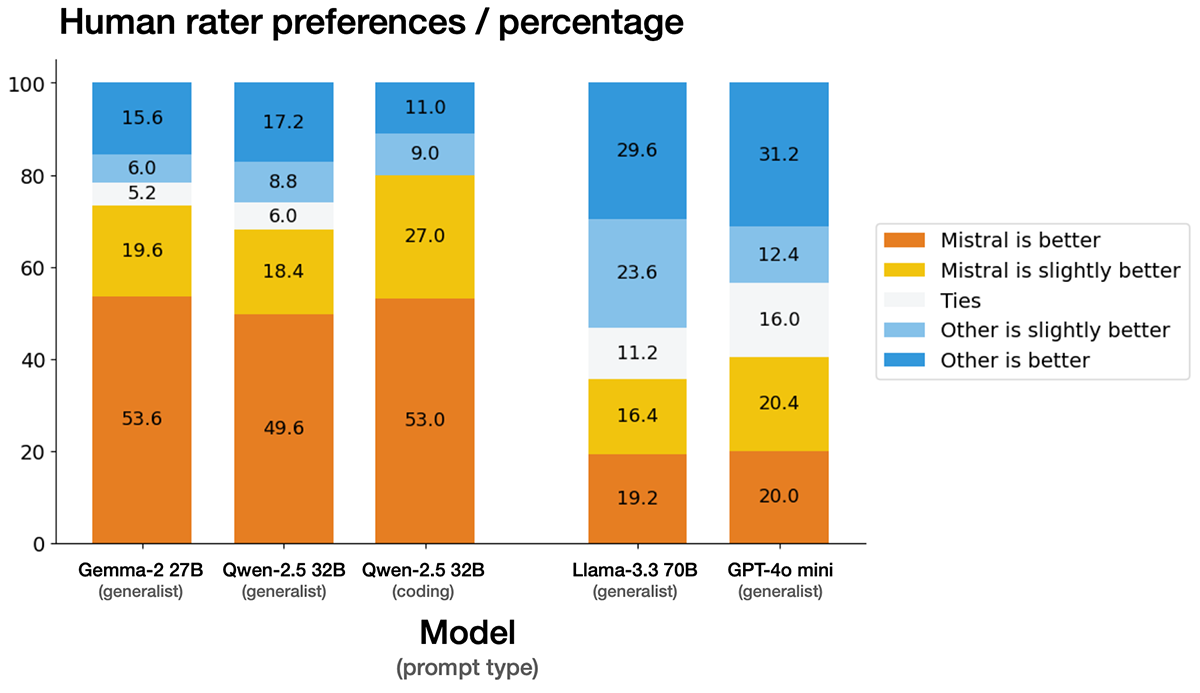

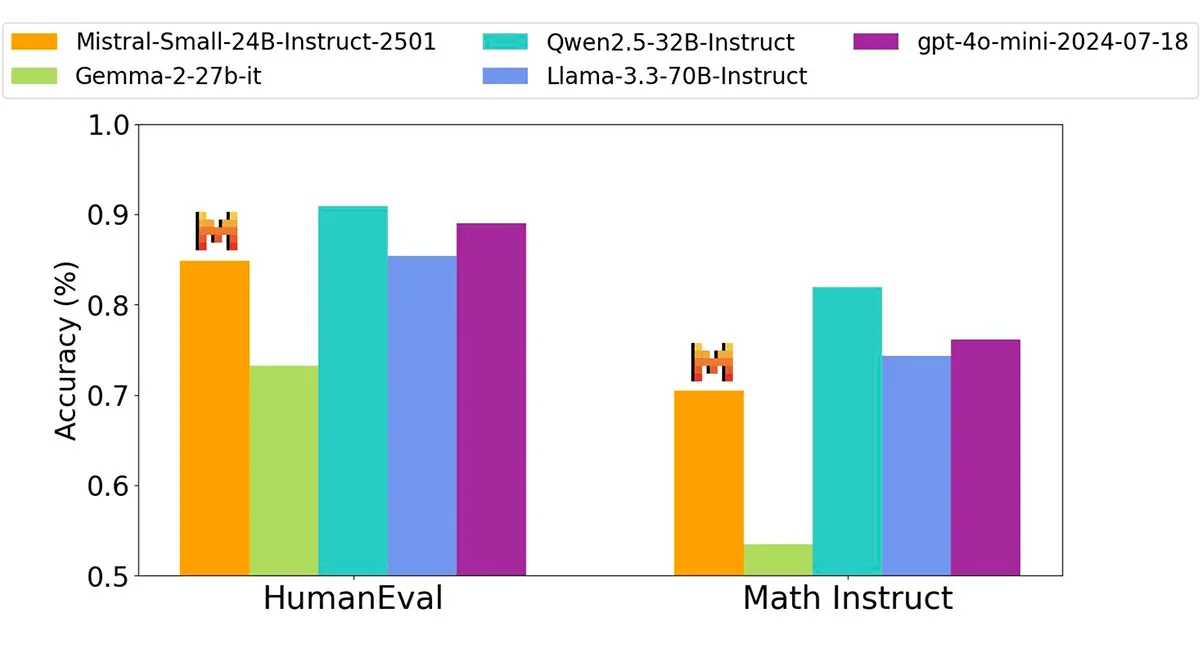

Mistral AI, gegründet von ehemaligen Ingenieuren von Google DeepMind und Meta Platforms, hat sich auf die Entwicklung offener Sprachmodelle spezialisiert. Mit Mistral Small 3 verfolgt das Unternehmen einen Ansatz, der nicht auf die bloße Erhöhung der Modellgröße setzt, sondern auf optimierte Trainingsmethoden, um Effizienz und Leistung zu steigern. Das Modell wurde mit 8 Billionen Tokens trainiert und erreicht eine Genauigkeit von 81 % bei Standard-Benchmarks, während es 150 Tokens pro Sekunde verarbeitet.

Quelle: Mistral

Leistungsfähigkeit und Effizienz

Trotz seiner geringeren Größe konkurriert Mistral Small 3 mit Modellen wie Llama 3.3 70B, die dreimal so groß sind. Diese Effizienz ermöglicht es, fortschrittliche KI-Funktionen mit reduzierten Rechenressourcen bereitzustellen, was insbesondere für Unternehmen mit begrenzten IT-Budgets von Vorteil ist. Das Modell wurde ohne den Einsatz von Reinforcement Learning oder synthetischen Trainingsdaten entwickelt, was dazu beiträgt, unerwünschte Verzerrungen zu minimieren.

Quelle: Mistral

Anwendungsbereiche und Einsatzmöglichkeiten

Mistral Small 3 eignet sich für eine Vielzahl von Anwendungen, darunter:

Schnelle Konversationsassistenten: Einsatz in Chatbots und virtuellen Assistenten, die schnelle und präzise Antworten liefern müssen.

Echtzeit-Funktionsaufrufe: Integration in automatisierte Workflows, die niedrige Latenzzeiten erfordern.

Fachspezifische Feinabstimmung: Anpassung des Modells für spezifische Domänen wie Rechtsberatung, medizinische Diagnostik oder technischen Support.

Lokale Inferenz: Möglichkeit des Einsatzes auf lokalen Geräten, was für datensensible Anwendungen von Vorteil ist.

Unternehmen aus verschiedenen Branchen, darunter Finanzdienstleistungen, Gesundheitswesen und Fertigung, evaluieren derzeit den Einsatz von Mistral Small 3 für Aufgaben wie Betrugserkennung, Kunden-Triage und On-Device-Steuerung.

Verfügbarkeit und Lizenzierung

Das Modell wird unter der Apache 2.0-Lizenz veröffentlicht, was eine freie Modifikation und Integration ermöglicht. Es ist auf verschiedenen Plattformen verfügbar, darunter Hugging Face, Ollama und Together AI, und kann sowohl lokal als auch in der Cloud eingesetzt werden.

AUSBLICK

Meine EU Hoffnung!

Mistral AI plant, in den kommenden Wochen weitere Modelle mit erweiterten Fähigkeiten im Bereich des logischen Denkens und der Argumentation zu veröffentlichen. Das Unternehmen setzt dabei auf eine offene Entwicklungsphilosophie und lädt die Open-Source-Community zur Mitwirkung ein. Mit Mistral Small 3 wird ein bedeutender Schritt in Richtung effizienter und zugänglicher KI-Modelle gemacht, die eine breite Anwendung in verschiedenen Industrien finden können.

UNTERSTÜTZUNG

Hat dir ein Artikel gefallen oder ein Tutorial geholfen? Du kannst uns weiterhelfen, indem du diese Seite weiterempfiehlst, uns auf Youtube abonnierst oder dich per Paypal an den Serverkosten beteiligst. Wir sind für jede Unterstützung dankbar. Danke.

KURZFASSUNG

- Mistral AI hat mit Mistral Small 3 ein leistungsstarkes, aber kompaktes KI-Modell mit 24 Milliarden Parametern veröffentlicht.

- Das Modell bietet eine beeindruckende Effizienz und erreicht Ergebnisse, die mit deutlich größeren Sprachmodellen vergleichbar sind.

- Mistral Small 3 wurde mit 8 Billionen Tokens trainiert und erreicht eine hohe Verarbeitungsgeschwindigkeit von 150 Tokens pro Sekunde.

- Es eignet sich für vielfältige Anwendungen wie Chatbots, Echtzeit-Funktionsaufrufe und fachspezifische Feinabstimmungen.

- Das Modell ist Open-Source (Apache 2.0-Lizenz) und auf Plattformen wie Hugging Face, Together AI und Ollama verfügbar.