KI-Zensur nach Wunsch?

Mit gpt-oss-safeguard kann jetzt jeder seine eigenen KI-Filter bauen – ist das gut oder gefährlich?

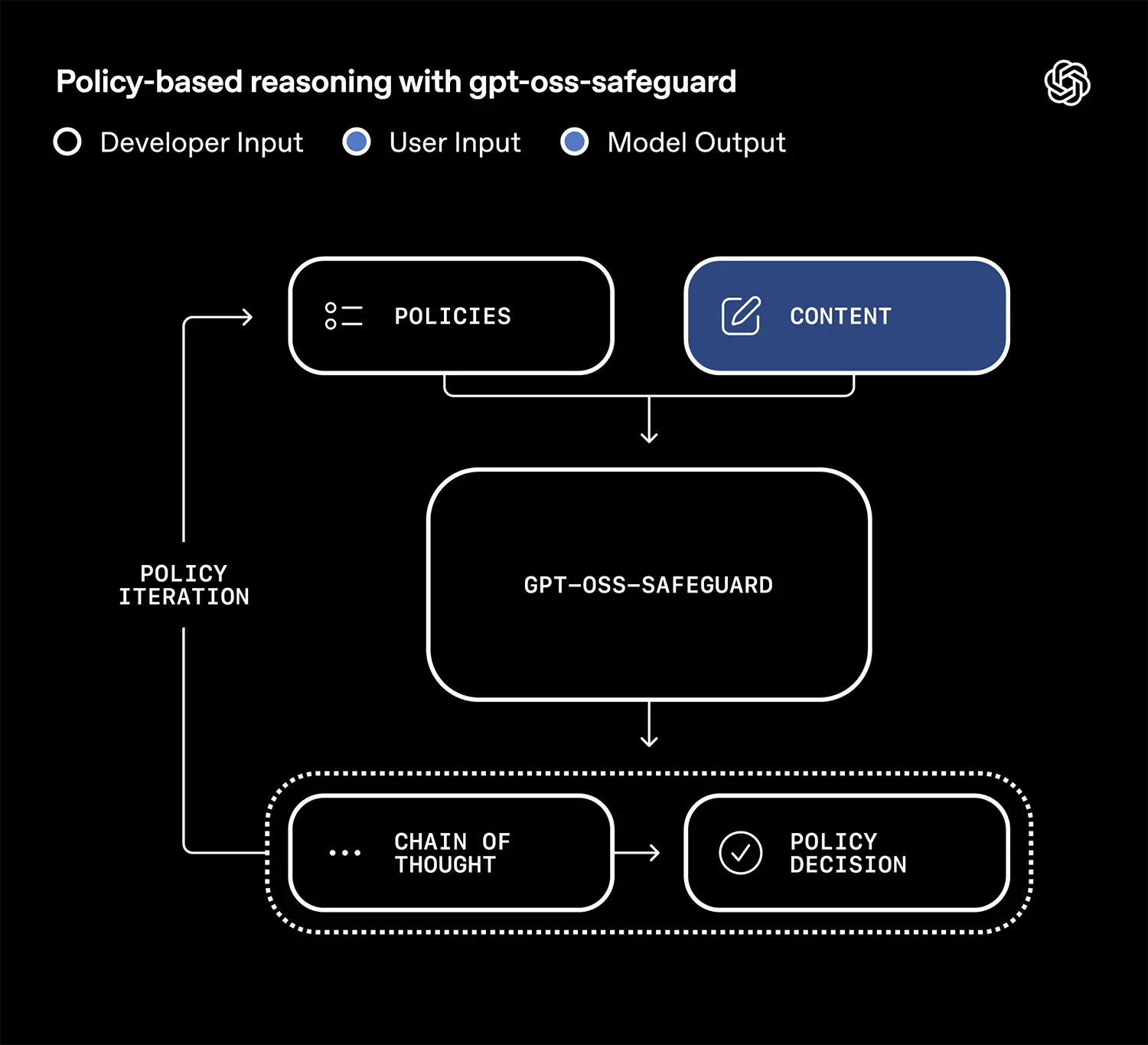

OpenAI hat zwei neue Open-Source-Modelle namens gpt-oss-safeguard vorgestellt. Sie sollen die Sicherheitsklassifizierung von KI-Inhalten grundlegend verändern. Statt starrer, eintrainierter Regeln erlauben die Werkzeuge eine flexible Anpassung von Sicherheitsrichtlinien direkt im laufenden Betrieb.

Anpassung in Echtzeit statt Training

Bisherige Sicherheitssysteme für KI-Modelle funktionierten meist statisch. Ein Klassifikator wurde auf bestimmte unerwünschte Inhalte trainiert und musste für jede Änderung der Richtlinien aufwendig neu justiert werden. Dieser Prozess ist langsam und passt sich nur schwer an neue Bedrohungen oder unterschiedliche Kontexte an.

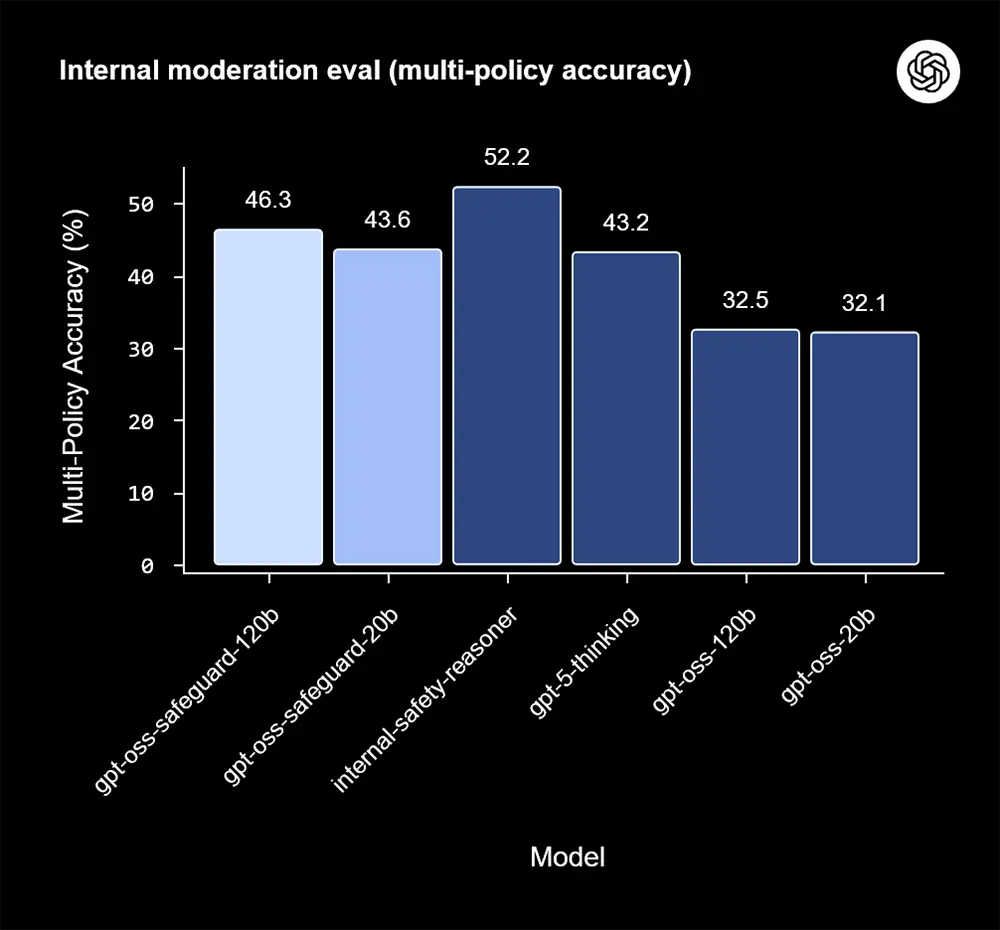

OpenAI will diesen starren Ansatz nun aufbrechen. Die neuen Modelle gpt-oss-safeguard, die in einer 120-Milliarden- und einer 20-Milliarden-Parameter-Version erscheinen, interpretieren Sicherheitsrichtlinien zur Laufzeit. Das bedeutet, ein Entwickler kann die Regeln für die Moderation von Inhalten ändern, ohne das Modell selbst neu trainieren zu müssen. Die neuen Richtlinien werden sofort aktiv.

Quelle: OpenAI

Transparenz als neues Ziel

Die Modelle basieren auf der gpt-oss-Architektur und werden unter der freizügigen Apache 2.0-Lizenz veröffentlicht. Dieser Schritt hin zu Open Source ist bemerkenswert. Er signalisiert den Wunsch nach mehr Transparenz in einem Bereich, der oft als "Black Box" kritisiert wird. Entwickler können nun genau nachvollziehen, wie die Sicherheitsfilterung funktioniert.

Entwickelt wurden die Werkzeuge in Zusammenarbeit mit ROOST, einer Organisation, die sich für eine offene und sichere KI-Infrastruktur einsetzt. Die Veröffentlichung ist als "Research Preview" deklariert. Sie lädt die Community ein, die Modelle zu testen und eine gemeinsame, flexible Sicherheitsinfrastruktur aufzubauen.

Quelle: OpenAI

Mehr Kontrolle für Entwickler

Für Entwickler bedeutet dieser Ansatz vor allem eines: mehr Kontrolle. Sie sind nicht länger an die vordefinierten Sicherheitsstandards eines großen Anbieters gebunden. Stattdessen können sie eigene, nuancierte Richtlinien definieren, die exakt auf ihre Anwendung zugeschnitten sind. Ein Forum für Fachdiskussionen benötigt andere Filter als ein soziales Netzwerk für Jugendliche.

Mit gpt-oss-safeguard lässt sich diese Unterscheidung nun technisch abbilden. Die KI lernt, die geschriebenen Regeln zu verstehen und anzuwenden, anstatt nur Muster zu erkennen. Diese Entwicklung gibt der KI-Community ein mächtiges Werkzeug an die Hand, um die Debatte um KI-Sicherheit offener und anpassungsfähiger zu gestalten.