Builder.ai: Der menschliche Chatbot, der Milliarden kostete

Ein Skandal erschüttert die KI-Branche – steckt hinter den glänzenden Versprechen oft nur Handarbeit?

gpt-image-1 | All-AI.de

EINLEITUNG

Das britische KI-Startup Builder.ai, das einst mit 1,5 Milliarden US-Dollar bewertet wurde und prominente Investoren wie Microsoft anzog, hat Insolvenz angemeldet. Entgegen der beworbenen innovativen KI-Technologie wurden die vermeintlich automatisierten Arbeiten von rund 700 indischen Programmierern manuell ausgeführt. Wie konnte ein Unternehmen mit solch hochkarätiger Unterstützung in diesen Skandal geraten?

NEWS

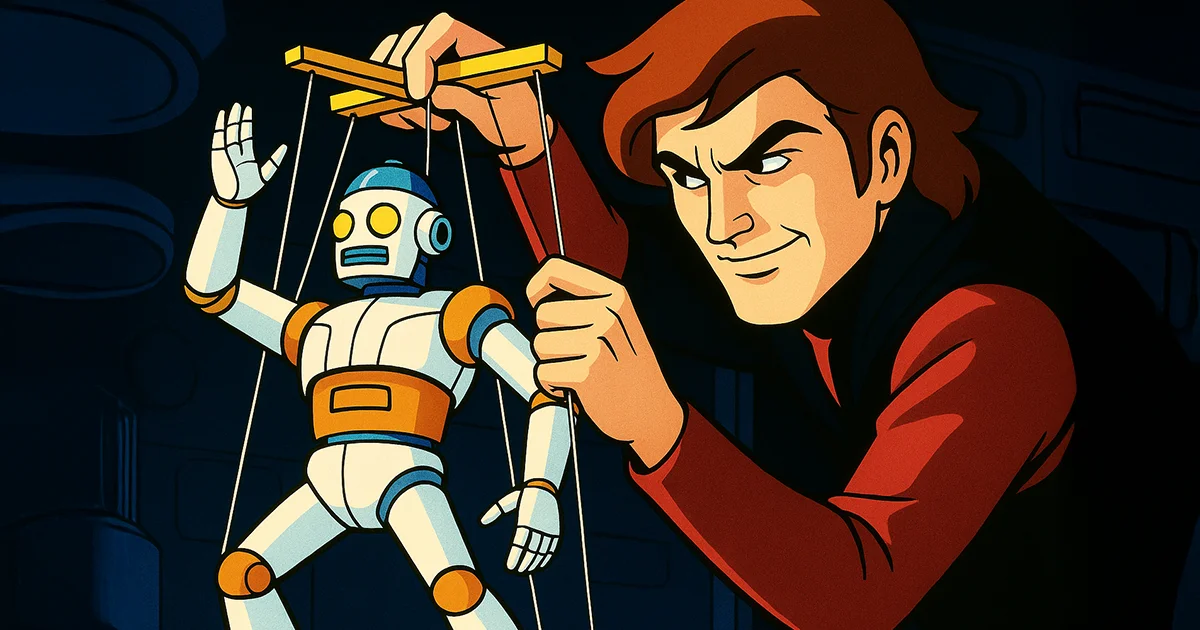

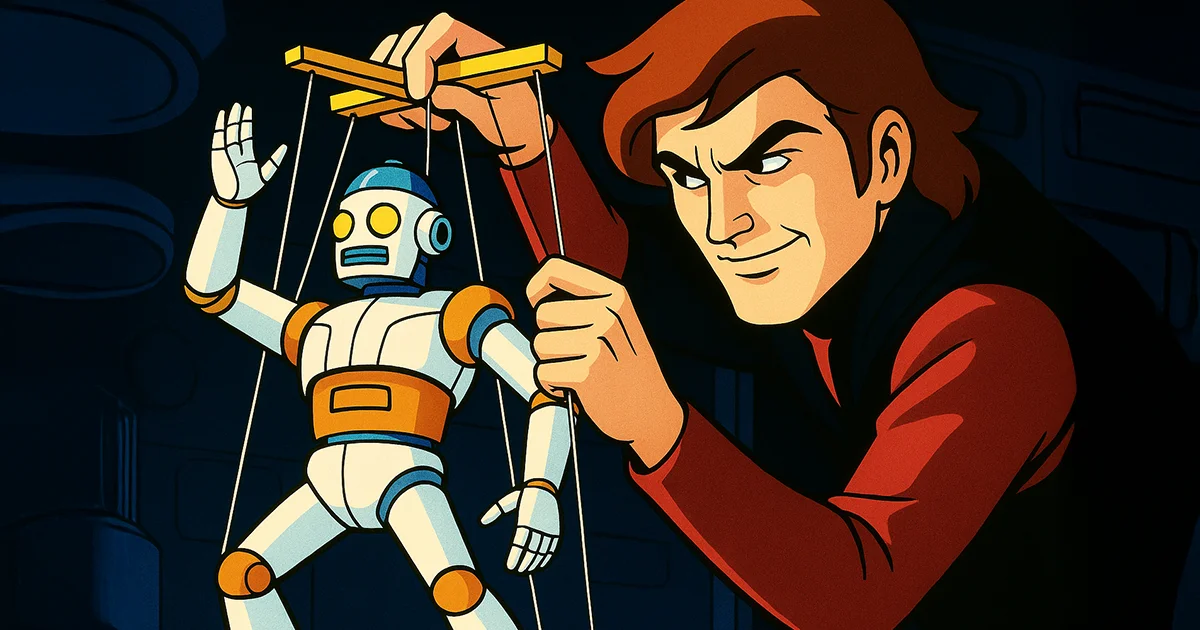

Falsche KI-Fassade „Natasha“

Builder.ai präsentierte „Natasha“ als intelligenten KI-Chatbot, der Kunden ermöglichen sollte, mobile Apps ohne Programmierkenntnisse zu erstellen. In Wahrheit erledigten jedoch etwa 700 menschliche Programmierer in Indien diese Aufgaben manuell. Erste Zweifel an der Echtheit dieser KI-Technologie wurden bereits 2019 laut, doch erst jetzt wurde das gesamte Ausmaß der Täuschung bekannt.

Finanzielle Manipulation durch „Round-Tripping“

Neben der vorgetäuschten KI-Fähigkeit geriet Builder.ai durch sogenannte „Round-Tripping“-Geschäfte in Verdacht. Dabei wurden zwischen 2021 und 2024 angeblich fiktive Rechnungen zwischen Builder.ai und dem indischen Unternehmen VerSe Innovation ausgetauscht, um den Umsatz künstlich zu erhöhen und so Investoren zu täuschen. VerSe Innovation bestreitet diese Vorwürfe und betont die Ordnungsmäßigkeit aller Transaktionen.

Folgen der Insolvenz

Die finanziellen Manipulationen führten letztlich zur Insolvenz des Unternehmens. Nachdem ein Kreditgeber 37 Millionen US-Dollar beschlagnahmte, wurde Builder.ai zahlungsunfähig. Gründer Sachin Dev Duggal trat bereits im Februar 2025 zurück, sein Nachfolger Manpreet Ratia konnte das Unternehmen jedoch nicht retten.

Auswirkungen auf die Tech-Branche

Der Builder.ai-Skandal wirft grundlegende Fragen nach Transparenz und Ehrlichkeit im Umgang mit KI-Technologien auf. Investoren und Kunden dürften zukünftig genauer prüfen, was ihnen als bahnbrechende Technologie verkauft wird. Dieser Fall verdeutlicht die Risiken übertriebener KI-Versprechen und unterstreicht die Bedeutung klarer und nachvollziehbarer Standards in der Branche.

AUSBLICK

Vertrauen in KI-Technologien auf dem Prüfstand

Der Zusammenbruch von Builder.ai unterstreicht die Notwendigkeit ethischer Standards und größerer Transparenz im Bereich der KI-Technologie. Unternehmen müssen sicherstellen, dass ihre Produkte tatsächlich halten, was versprochen wird, um langfristig Vertrauen bei Kunden und Investoren zu sichern. Der Fall könnte als Weckruf dienen und die Branche dazu motivieren, strengere Kontrollmechanismen zu etablieren.

UNSER ZIEL

KURZFASSUNG

- Builder.ai täuschte mit der angeblichen KI „Natasha“, hinter der in Wahrheit hunderte Programmierer standen.

- Das Unternehmen steht unter Verdacht, durch fingierte Umsätze Investoren betrogen zu haben.

- Nach Rücktritt des Gründers und beschlagnahmten Geldern meldete Builder.ai Insolvenz an.

- Der Fall wirft ein kritisches Licht auf die Glaubwürdigkeit von KI-Startups und fordert mehr Transparenz.