GLM-Image startet als ernstzunehmender Open-Source-Herausforderer

Huawei-Hardware statt Nvidia-Chips: Dieses neue Bildmodell verspricht überlegene Textdarstellung bei guter Qualität.

Chinas KI-Ambitionen erreichen eine neue Stufe der Autarkie. Mit GLM-Image erscheint erstmals ein leistungsfähiges Open-Source-Bildmodell, das vollständig auf Huawei-Hardware trainiert wurde und westliche Technologie-Sanktionen praktisch umgeht.

Der Bruch mit der westlichen Hardware-Dominanz

Lange Zeit galt es als ungeschriebenes Gesetz, dass Spitzenmodelle im Bereich der generativen KI zwingend auf Nvidias CUDA-Ökosystem und H100-Clustern trainiert werden müssen. Zhipu AI, eines der führenden chinesischen KI-Startups, widerlegt diese These nun eindrucksvoll. In einer strategischen Partnerschaft mit Huawei wurde das neue Modell "GLM-Image" ausschließlich auf Huaweis Ascend-Chips trainiert.

Dieser Schritt demonstriert eine funktionierende technologische Unabhängigkeit. Während US-Sanktionen den Zugang zu westlichen High-End-Chips beschränken, beweist die Veröffentlichung, dass die heimische Hardware-Infrastruktur mittlerweile leistungsfähig genug ist, um industrielle "Large Scale"-Modelle zu berechnen. Für den europäischen Markt bedeutet dies, dass ein neuer, ernstzunehmender Player das Spielfeld betritt, der nicht den Restriktionen des Silicon Valley unterliegt.

Hybride Architektur für präzisere Ergebnisse

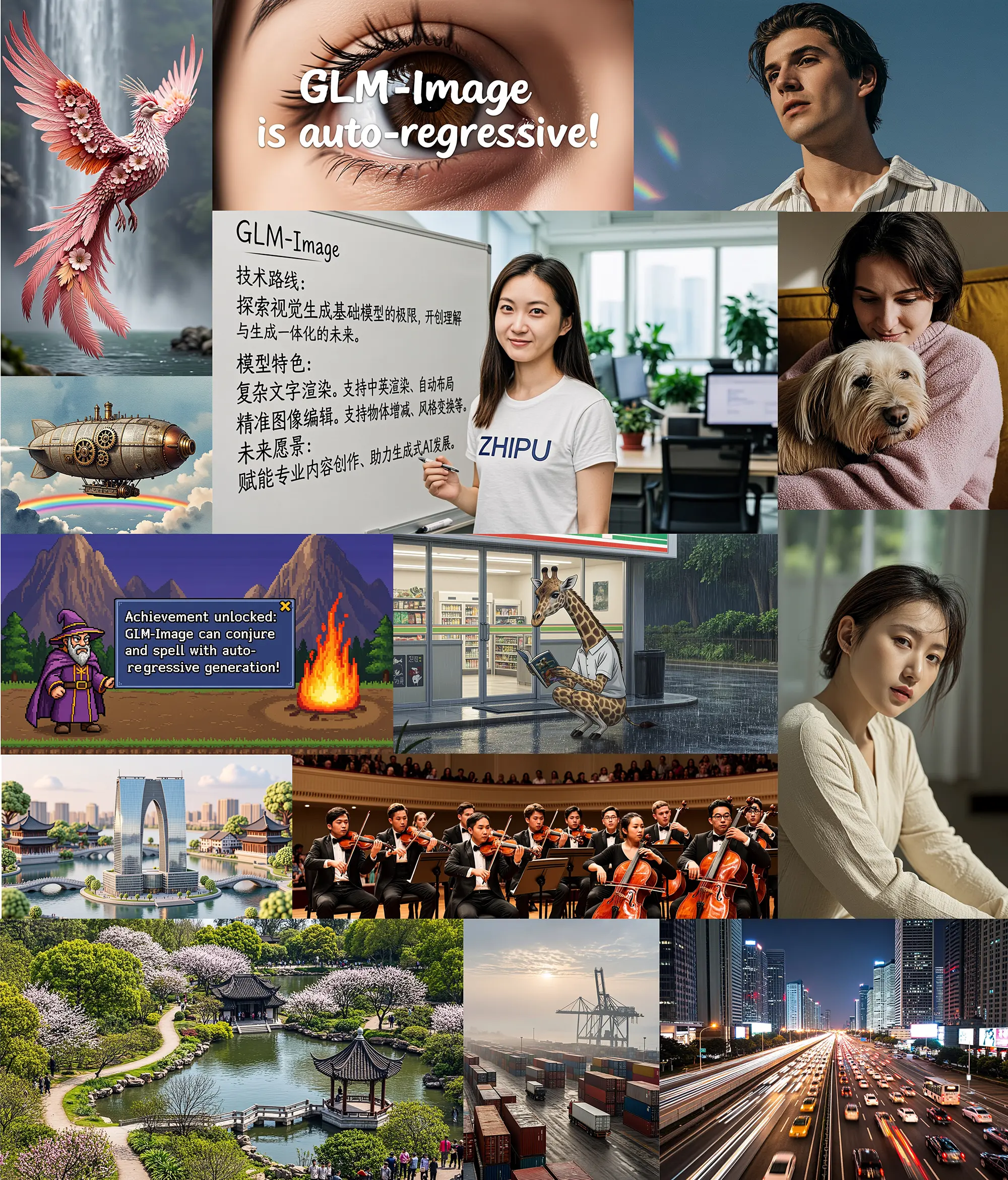

Technisch wagt Zhipu AI einen interessanten Vorstoß, der sich von den derzeit dominierenden Diffusionsmodellen (wie Stable Diffusion oder Flux) unterscheidet. GLM-Image setzt auf eine autoregressive hybride Architektur. Vereinfacht ausgedrückt: Das Modell "versteht" und generiert Bilder ähnlich wie ein Sprachmodell und kombiniert das mit modernen bildgebenden Verfahren.

Benchmark-Analyse: Mittelmaß bei Ästhetik, Weltklasse bei Text

Ein Blick auf die nackten Zahlen bestätigt die architektonische Ausrichtung des Modells. In allgemeinen Benchmarks (OnelG_EN), die Kriterien wie Ästhetik und Bildqualität messen, positioniert sich GLM-Image im soliden Mittelfeld. Mit einem Overall-Score von 0,528 übertrifft es zwar populäre Open-Source-Modelle wie FLUX.1 [Dev] (0,434) und SD3.5 Large (0,462) deutlich, muss sich aber spezialisierten, teils geschlossenen Systemen wie "Nano Banana 2.0" (0,578) geschlagen geben. Für ein Modell, das nicht auf Nvidia-Hardware trainiert wurde, ist diese Leistung jedoch beachtlich und absolut konkurrenzfähig.

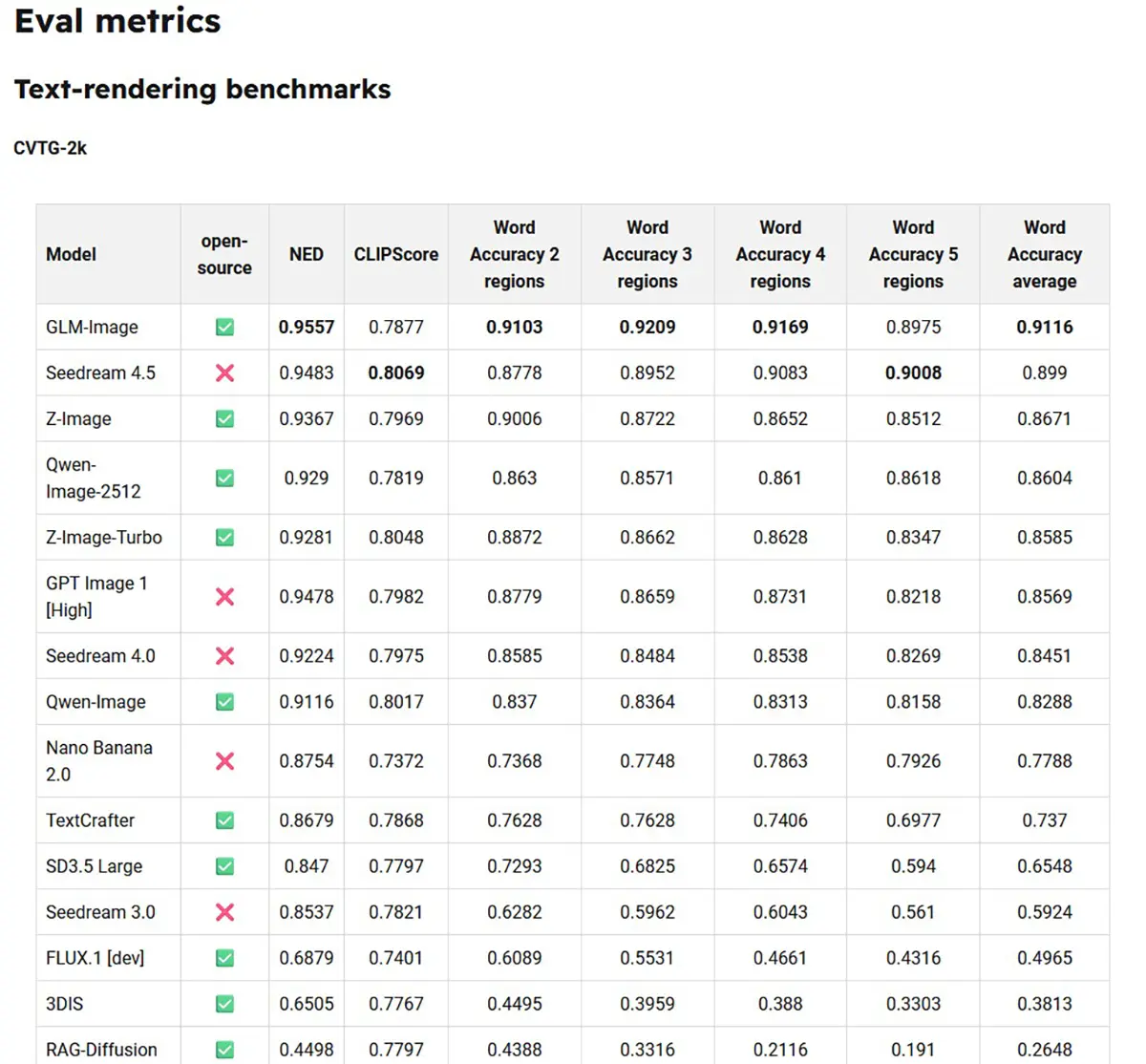

Die wahre Stärke zeigt sich jedoch beim "Text-Rendering Benchmark" (CVTG-2k). Hier deklassiert GLM-Image die Konkurrenz. Mit einer Wort-Genauigkeit von 91,16 % belegt das Modell den ersten Platz und schlägt sogar kommerzielle Schwergewichte und Closed-Source-Modelle wie Seedream 4.5 oder GPT Image 1.

Der Vorsprung zur direkten Konkurrenz ist dabei massiv: Während GLM-Image Texte fast fehlerfrei rendert, erreichen weit verbreitete Modelle wie FLUX.1 nur 49,65 % und SD3.5 Large lediglich 65,48 % Genauigkeit. Diese Daten untermauern die These, dass die autoregressive Architektur für Aufgaben, die logisches Textverständnis und präzise Darstellung erfordern, den reinen Diffusionsmodellen weit überlegen ist.

Quelle: z.ai

Anzeige

Open Source als Industriestandard

Zhipu AI positioniert GLM-Image nicht als geschlossene Blackbox, sondern stellt es der Entwicklergemeinde als Open Source zur Verfügung. Das Modell ist ab sofort auf Plattformen wie Hugging Face und GitHub verfügbar. Damit greift das Unternehmen direkt die Marktanteile etablierter westlicher Open-Source-Alternativen an.

Die Veröffentlichung richtet sich primär an industrielle Anwender. Durch die offene Lizenzierung und die Optimierung auf alternative Hardware-Stacks bietet sich das Modell für Unternehmen an, die unabhängige On-Premise-Lösungen suchen und sich nicht an die API-Kosten oder Datenschutzrichtlinien amerikanischer Anbieter binden wollen. Die kommenden Wochen werden zeigen, ob die Community die Huawei-basierte Architektur auch auf westlicher Consumer-Hardware effizient zum Laufen bekommt.