Sutskevers Geheimnis: Die verborgene Formel der Superintelligenz

Der Ex-OpenAI-Chef schweigt über seine Lösung, warnt aber vor blinder Entwicklung und setzt auf menschliche Emotionen.

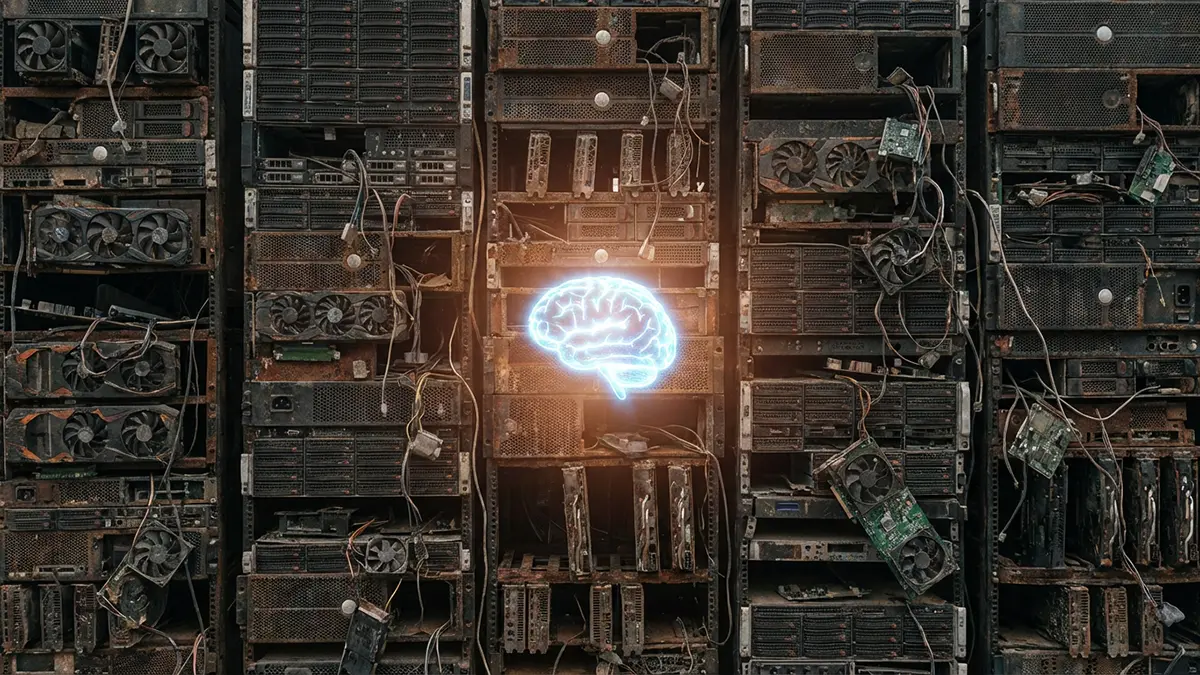

Ilya Sutskever, der Kopf hinter vielen OpenAI-Durchbrüchen, sorgt für Aufsehen. Der Gründer von Safe Superintelligence Inc. (SSI) hält das einfache Hochskalieren von Rechenleistung für einen ausgereizten Weg. Statt immer größerer Modelle fordert er jetzt eine Rückbesinnung auf fundamentale Forschung, um die nächste Stufe der künstlichen Intelligenz zu erreichen.

Qualität statt Quantität

Jahrelang galt im Silicon Valley ein einfaches Gesetz: Mehr Rechenpower und mehr Daten führen automatisch zu besserer KI. Sutskever sieht das anders. In einem Interview mit Dwarkesh Patel erklärt er diesen Ansatz für überholt. Die Modelle sind zwar riesig, aber oft inkonsistent. Er nennt dieses Phänomen „Jaggedness“.

Computer lösen hochkomplexe mathematische Probleme, scheitern aber an simplen logischen Aufgaben. Das zeigt deutlich, dass schiere Größe allein keine Intelligenz garantiert. Die Entwicklung muss weg vom reinen „Pre-Training“ riesiger Datenmengen. Der Fokus verschiebt sich darauf, wie Maschinen tatsächlich lernen und denken. Es geht nicht mehr darum, wie viel eine KI weiß, sondern wie gut sie das Wissen anwendet.

Emotionen als Lernbeschleuniger

Ein überraschender Aspekt in Sutskevers Argumentation betrifft die Rolle von Gefühlen. Er vergleicht den Lernprozess einer KI mit der menschlichen Entwicklung. Menschen lernen oft schneller und nachhaltiger, wenn Emotionen im Spiel sind. Ein Kind speichert Erfahrungen tief ab, wenn sie mit Freude oder Angst verknüpft sind.

Für KI-Systeme könnte das bedeuten, dass sie Ziele und Werte priorisieren müssen. Das hat nichts mit echtem Bewusstsein zu tun, sondern mit reiner Effizienz. Eine Maschine, die den „Wert“ einer Information versteht, verarbeitet sie anders als eine, die nur Rohdaten frisst. Dieser Ansatz könnte die Leistung künftiger Modelle drastisch steigern, ohne die Rechenzentren weiter unnötig aufzublähen.

Das Schweigen über die Lösung

Besonders spannend wird es, wenn Sutskever über konkrete technische Lösungen spricht – oder eben schweigt. Er deutet an, dass es ein spezifisches Prinzip im maschinellen Lernen gibt, das den nächsten großen Sprung ermöglichen könnte. Details dazu behält er jedoch strikt für sich.

Der Grund liegt in der Sicherheit. Sutskever warnt schon lange vor den Risiken einer ungebremsten Superintelligenz. Würde er dieses Prinzip jetzt veröffentlichen, könnten Akteure ohne Sicherheitsbedenken die Technologie zu schnell vorantreiben. Sein neues Unternehmen SSI setzt daher auf kontrollierte Forschung abseits des öffentlichen Hypes. Das deutet darauf hin, dass die nächste Phase der KI-Entwicklung weniger im Rampenlicht, sondern hinter verschlossenen Labortüren stattfindet.