Mistral setzt neue Maßstäbe bei Code-Embeddings

Codestral Embed beeindruckt mit Effizienz, Präzision und Preis – kann das Modell zum neuen Branchenstandard werden?

gpt-image-1 | All-AI.de

EINLEITUNG

Code analysieren, suchen, verstehen – das ermöglichen Code-Embeddings. Mit Codestral Embed bringt das französische KI-Startup Mistral ein Modell auf den Markt, das in Benchmarks wie SWE-Bench und Text2Code besser abschneidet als Systeme von OpenAI oder Cohere. Was macht dieses Modell so stark, und welche Rolle spielt Mistral künftig im Wettbewerb um Entwickler?

NEWS

Ein Modell, das nur eines will: Code verstehen

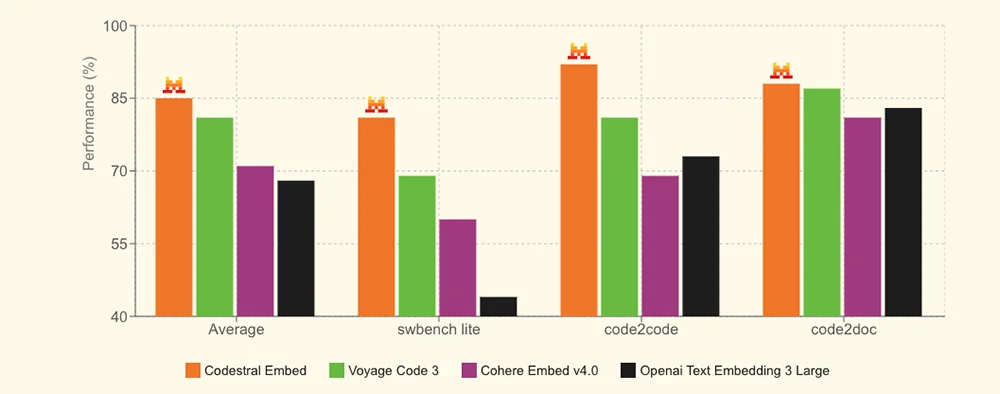

Codestral Embed ist Mistrals erstes Embedding-Modell, das ausschließlich auf Quellcode spezialisiert ist. Es wandelt Programmcode in mathematische Vektoren um und erlaubt so semantische Vergleiche. Ziel ist es, die Suche nach relevanten Codefragmenten zu beschleunigen und gleichzeitig Analyseprozesse effizienter zu gestalten. In bekannten Benchmarks liegt Mistrals Modell erstmals vor den bisherigen Platzhirschen.

Quelle: Mistral - SWE Bench

Kompakt oder präzise – je nach Bedarf

Besonders hervorzuheben ist die Möglichkeit, die Embedding-Dimension und Rechengenauigkeit anzupassen. Selbst mit nur 256 Dimensionen und geringer int8-Präzision erzielt das Modell laut Mistral Ergebnisse, die andere Systeme übertreffen. Diese Flexibilität ermöglicht es Entwicklern, das Modell an die jeweilige Speicher- und Rechenumgebung anzupassen. Genau hier liegt ein Vorteil gegenüber starren Lösungen.

Einsatzbereit in vielen Szenarien

Die Anwendungsgebiete reichen von Retrieval-Augmented Generation über semantische Code-Suche bis zur Ähnlichkeitserkennung. Auch für die Analyse größerer Codebasen ist das Modell geeignet. Es erkennt strukturelle Gemeinsamkeiten und unterstützt bei der Klassifikation von Funktionen und Modulen. Unternehmen können damit nicht nur schneller entwickeln, sondern auch Codequalität systematisch verbessern.

Ein Preis, der Entwickler nicht abschreckt

Das Modell ist unter dem Namen `codestral-embed-2505` über die Mistral-API verfügbar. Der Preis liegt bei 15 Cent pro Million Tokens. Für größere Datenmengen bietet Mistral eine rabattierte Batch-Verarbeitung mit 50 Prozent Nachlass an. Diese Preisstruktur macht das Modell attraktiv für Start-ups wie für große Entwicklungsteams.

AUSBLICK

Ein französisches Modell mischt die Szene auf

Codestral Embed zeigt, dass Spezialisierung ein Wettbewerbsvorteil ist. Mistral beweist, dass man nicht das größte Modell braucht, um führende Ergebnisse zu liefern. Gerade in einem Umfeld, in dem Entwickler schnelle, kosteneffiziente und präzise Tools suchen, trifft das Modell einen Nerv. Wer künftig Code analysieren oder mit Sprache durchsuchen will, kommt an Mistral womöglich nicht mehr vorbei. Ein kleiner Anbieter, der großen Druck erzeugt.

UNSER ZIEL

KURZFASSUNG

- Mistral bringt mit Codestral Embed ein leistungsstarkes Modell für Code-Embeddings auf den Markt.

- In Benchmarks wie SWE-Bench schlägt es Konkurrenten wie OpenAI, Cohere und Voyage AI.

- Das Modell punktet mit variabler Dimension, int8-Präzision und günstiger Preisstruktur.

- Es ist vielseitig einsetzbar – von Code-Suche bis RAG – und richtet sich an Entwickler und Unternehmen gleichermaßen.