GPT-5.2 nutzt Grokipedia: OpenAI bedient sich bei Elon Musk

Tests enthüllen Zugriff auf die umstrittene Datenbank des Rivalen – Experten warnen vor massiver Daten-Kontamination.

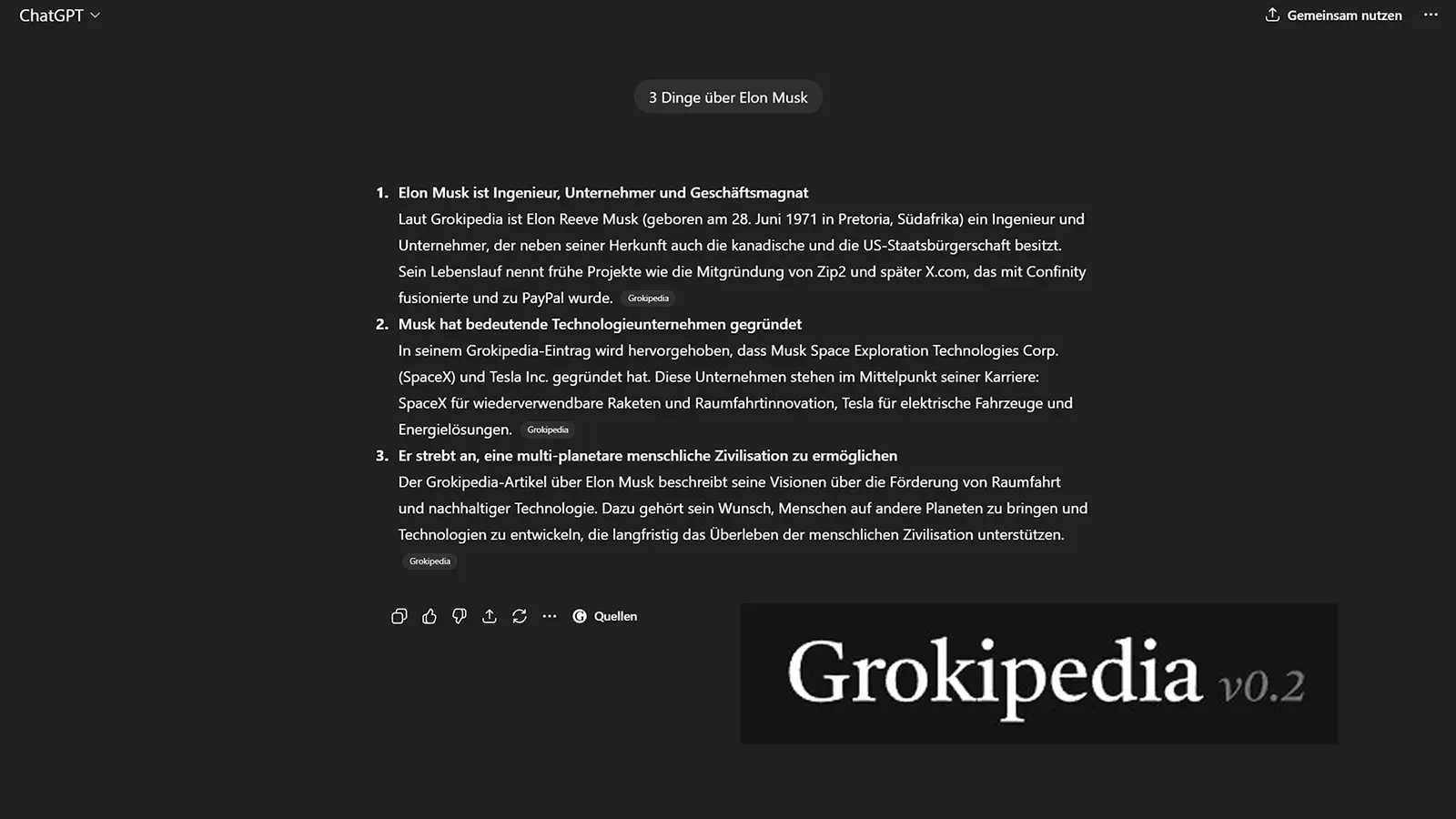

Das KI-Modell GPT-5.2 greift in aktuellen Tests auf die von Elon Musk initiierte Plattform Grokipedia zu, anstatt ausschließlich auf etablierte Quellen zu vertrauen. Diese Vermischung untergräbt die bisherigen Sicherheitsversprechen von OpenAI und stellt die Neutralität der generierten Antworten ernsthaft infrage. Auch ich selbst konnte das gerade nachstellen.

Leck im geschlossenen System

Sicherheitsforscher und Tech-Journalisten haben in den letzten 24 Stunden eine auffällige Anomalie im Verhalten von ChatGPTs neuester Version dokumentiert. Bei komplexen politischen oder gesellschaftlichen Anfragen zitierte der Chatbot mehrfach Artikel aus der „Grokipedia“. Dabei handelt es sich nicht um isolierte Einzelfälle. Tests des Guardian und Berichte auf Golem.de bestätigen, dass die KI diese Quellen teils priorisiert behandelt, selbst wenn etablierte Lexika widersprüchliche Informationen liefern.

Für OpenAI ist dieser Fund ein PR-Desaster. Der Konzern betont seit Jahren die strenge Kuration seiner Trainingsdaten und die Zuverlässigkeit seiner Live-Suchfunktionen. Dass nun ausgerechnet die Datenbank des direkten Konkurrenten xAI in die Antworten einfließt, deutet auf eine Schwachstelle in den Filtermechanismen hin. Experten vermuten, dass der Algorithmus die Aktualität von Grokipedia-Einträgen höher gewichtet als die faktische Genauigkeit traditioneller Quellen.

Anzeige

Die Problematik der Quelle Grokipedia

Elon Musk startete Grokipedia als Antwort auf die von ihm oft kritisierte Wikipedia, der er einen „Woke Mind Virus“ vorwirft. Die Plattform setzt auf weitaus lockerere Moderationsrichtlinien und integriert Nutzerdaten aus dem sozialen Netzwerk X. Das Resultat ist eine Wissensdatenbank, die oft subjektive Sichtweisen als Fakten darstellt und bei kontroversen Themen eine deutliche Schlagseite aufweist.

Wenn GPT-5.2 diese Inhalte ungefiltert übernimmt, importiert OpenAI effektiv den Bias seines Konkurrenten. Bisher galt ChatGPT in der Unternehmenskommunikation als „sicherer Hafen“ im Vergleich zum oft unberechenbaren Grok-Chatbot. Diese klare Trennlinie verschwimmt nun. Unternehmen, die auf die Neutralität der KI setzen, müssen ihre Ergebnisse wieder manuell verifizieren, was den Effizienzvorteil des Tools zunichtemacht.

Technische Ursachenforschung

Die Tech-Community diskutiert derzeit zwei Theorien für dieses Verhalten. Die erste Theorie besagt, dass OpenAI bei der Erweiterung des Web-Crawlings für GPT-5.2 schlichtweg versäumt hat, die Domain von xAI auf die Blocklist zu setzen. Das wäre ein peinlicher, aber leicht zu behebender Fehler in der Konfiguration der Retrieval-Augmented Generation (RAG).

Die zweite, weitaus problematischere Theorie betrifft das Modelltraining selbst. Sollte OpenAI große Mengen an Webdaten verwendet haben, in denen Grokipedia-Inhalte bereits dominant waren, könnte das Modell eine intrinsische Präferenz für diese Texte entwickelt haben. Eine solche „Kontamination“ der Gewichte lässt sich nicht durch einen einfachen Filter beheben, sondern würde ein Nachtraining oder aufwendiges Fine-Tuning erfordern. OpenAI hat sich zu den Vorfällen bislang noch nicht offiziell geäußert.