Der "GPT-Moment" für Roboter ist da

Vergiss alles, was du über Roboter wusstest. Google DeepMind hat eine KI geschaffen, die so revolutionär ist wie ChatGPT für die physische Welt.

Google | All-AI.de

EINLEITUNG

Bisher folgten Roboter starren Befehlen. Google DeepMind will das nun ändern und stellt zwei neue KI-Modelle vor, die Maschinen erstmals echtes, eigenständiges Denken ermöglichen sollen. Die Modelle Gemini Robotics 1.5 und ER 1.5 arbeiten im Team und erlauben Robotern, komplexe Aufgaben zu analysieren, Pläne zu schmieden und sogar im Internet zu recherchieren. Dies könnte den entscheidenden Schritt in eine neue Ära der Robotik bedeuten, in der Maschinen nicht mehr nur ausführen, sondern verstehen.

NEWS

Das Gehirn und die Hände der Maschine

Die neue Architektur von Google DeepMind teilt die Arbeit auf zwei spezialisierte Modelle auf. Gemini Robotics-ER 1.5 agiert als das „denkende Gehirn“. Es analysiert eine Aufgabe und die physische Umgebung durch visuelle und textuelle Informationen. Darauf basierend entwickelt es einen mehrstufigen Plan. Wenn Informationen fehlen, kann das Modell selbstständig eine Google-Suche durchführen, um beispielsweise lokale Recycling-Vorschriften nachzulesen, bevor es einen Plan zum Müllsortieren erstellt.

Für die physische Umsetzung ist Gemini Robotics 1.5 zuständig, das als die „Hände“ des Systems fungiert. Dieses Modell empfängt die Anweisungen vom Gehirn-Modell und übersetzt sie in konkrete Handlungen. Eine besondere Fähigkeit ist die Selbstreflexion: Vor jeder Bewegung hält der Roboter kurz inne und überdenkt den nächsten Schritt, um seine Aktionen an die reale Welt anzupassen. Dieser Prozess ersetzt die monatelange Programmierung, die bisher für einzelne Aufgaben notwendig war.

Vom Labor in die reale Welt

Die Fähigkeiten des Systems demonstrierte Google an alltagsnahen Beispielen. Ein Roboter packte einen Koffer, nachdem er die Wettervorhersage für London geprüft und passende Kleidung ausgewählt hatte. Ein anderes Beispiel zeigte das Sortieren von Wäsche nach Farben. Diese Aufgaben erfordern kontextuelles Verständnis und die Fähigkeit, mit unbekannten Objekten umzugehen – eine Hürde für bisherige Robotik-Systeme.

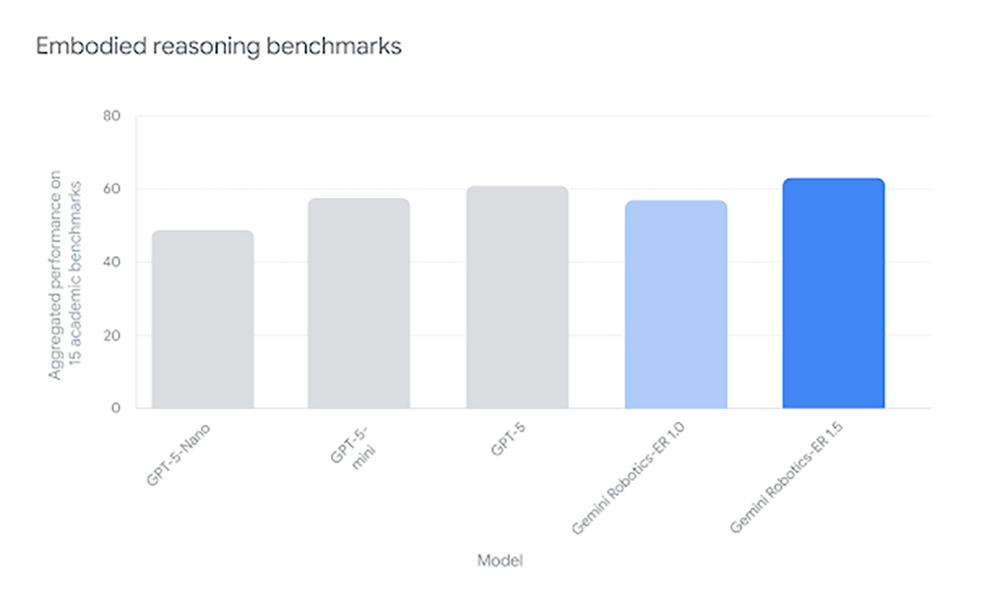

Entscheidend für den Fortschritt ist die Übertragbarkeit der Modelle. Die entwickelte KI-Software kann ohne spezielle Anpassungen auf unterschiedlichen Roboter-Plattformen laufen, vom zweiarmigen Aloha 2 bis zum humanoiden Apollo. Fähigkeiten, die ein System erlernt, können so auf ein anderes übertragen werden, ohne dass ein komplett neuer Trainingszyklus erforderlich ist. Laut DeepMind verdoppelt das neue System die Leistung führender Konkurrenzmodelle bei Generalisierungsaufgaben.

Ein Wendepunkt für die Robotik?

Experten sprechen bereits von einem möglichen „GPT-Moment“ für die Robotik. Ähnlich wie große Sprachmodelle die Texterstellung revolutionierten, könnte die Verbindung von räumlichem Verständnis, Sprachverarbeitung und physischer Aktion einen vergleichbaren Durchbruch für die Interaktion mit der realen Welt bedeuten. Google macht das Gehirn-Modell Gemini Robotics-ER 1.5 über das AI Studio bereits für alle Entwickler zugänglich, während das Aktions-Modell zunächst nur für ausgewählte Partner verfügbar ist. Während traditionelle Roboter auf ihre Programmierung beschränkt blieben, leiten diese denkenden Systeme eine neue Generation autonomer Maschinen ein, die sich flexibel an unsere Welt anpassen.