OpenAI "Harness Engineering" beendet manuelles Programmieren für Softwareentwickler

Statt Code schreiben Ingenieure jetzt Testumgebungen und Dokumentationen, damit KI-Agenten die Software autonom entwickeln.

OpenAI stellt mit „Harness Engineering“ ein Konzept vor, das die Entwicklerrolle deutlich wandelt. Der Ingenieur schreibt keinen Code mehr, sondern konstruiert eine messbare Umgebung, in der KI-Agenten autonom arbeiten.

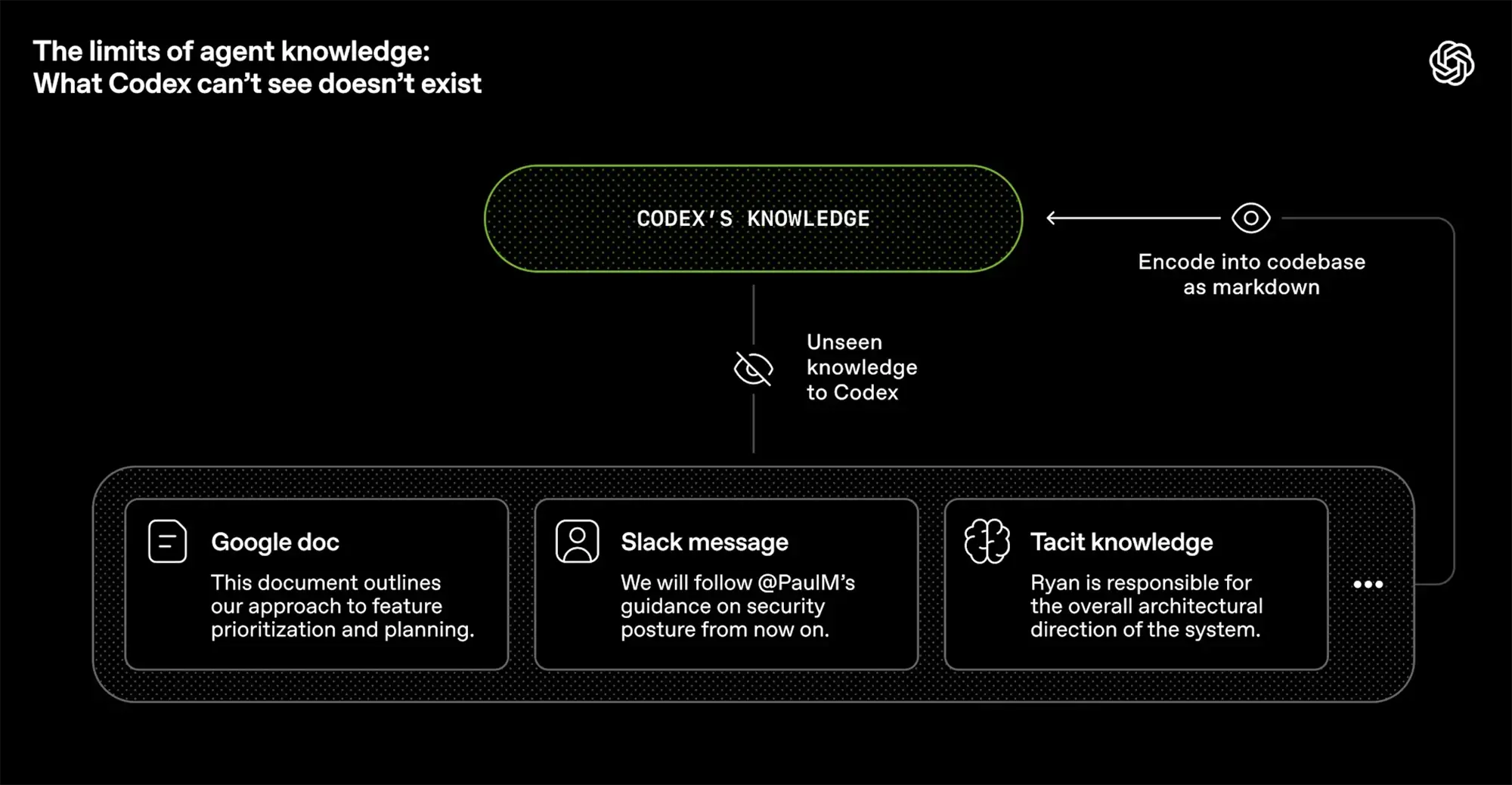

Das Kernproblem aktueller KI-Entwicklung ist oft nicht das Modell selbst, sondern fehlendes Kontextwissen. Informationen, die nur in Slack-Chats oder in den Köpfen der Mitarbeiter existieren, sind für den Agenten unsichtbar. „Was Codex nicht sehen kann, existiert nicht“, lautet die simple Erkenntnis von OpenAI.

Quelle: OpenAI

Dokumentation als Code

Im Harness Engineering wird die Dokumentation zur primären Schnittstelle. Anweisungen und Architektur-Entscheidungen müssen als Markdown-Dateien direkt im Repository liegen. Der Mensch programmiert also nicht mehr die Logik, sondern die Wissensbasis. Die Disziplin steigt: Was nicht dokumentiert ist, wird vom Agenten ignoriert.

Anzeige

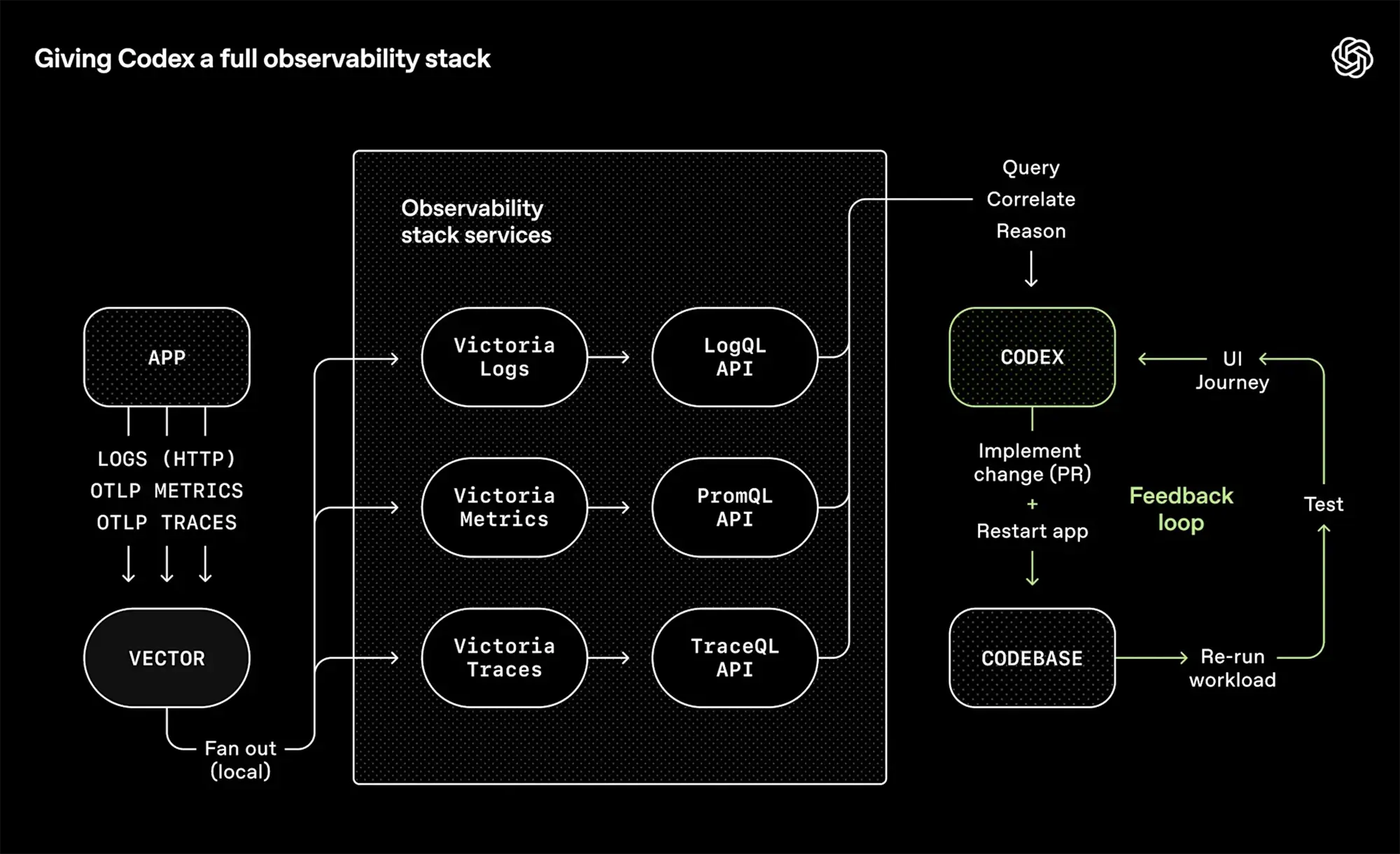

Der autonome Regelkreis

Damit Agenten Fehler selbstständig beheben, reicht der Zugriff auf statischen Code nicht. OpenAI integriert daher einen vollen „Observability Stack“. Der Agent erhält Zugriff auf Logs, Metriken und Traces.

Der neue Workflow: Der Agent implementiert eine Änderung, startet die App neu und analysiert die Rückmeldungen. Treten Fehler auf, liest er die Logs und korrigiert seinen eigenen Code. Dieser Feedback-Loop läuft ohne menschliches Zutun, bis das System stabil ist.

Quelle: OpenAI

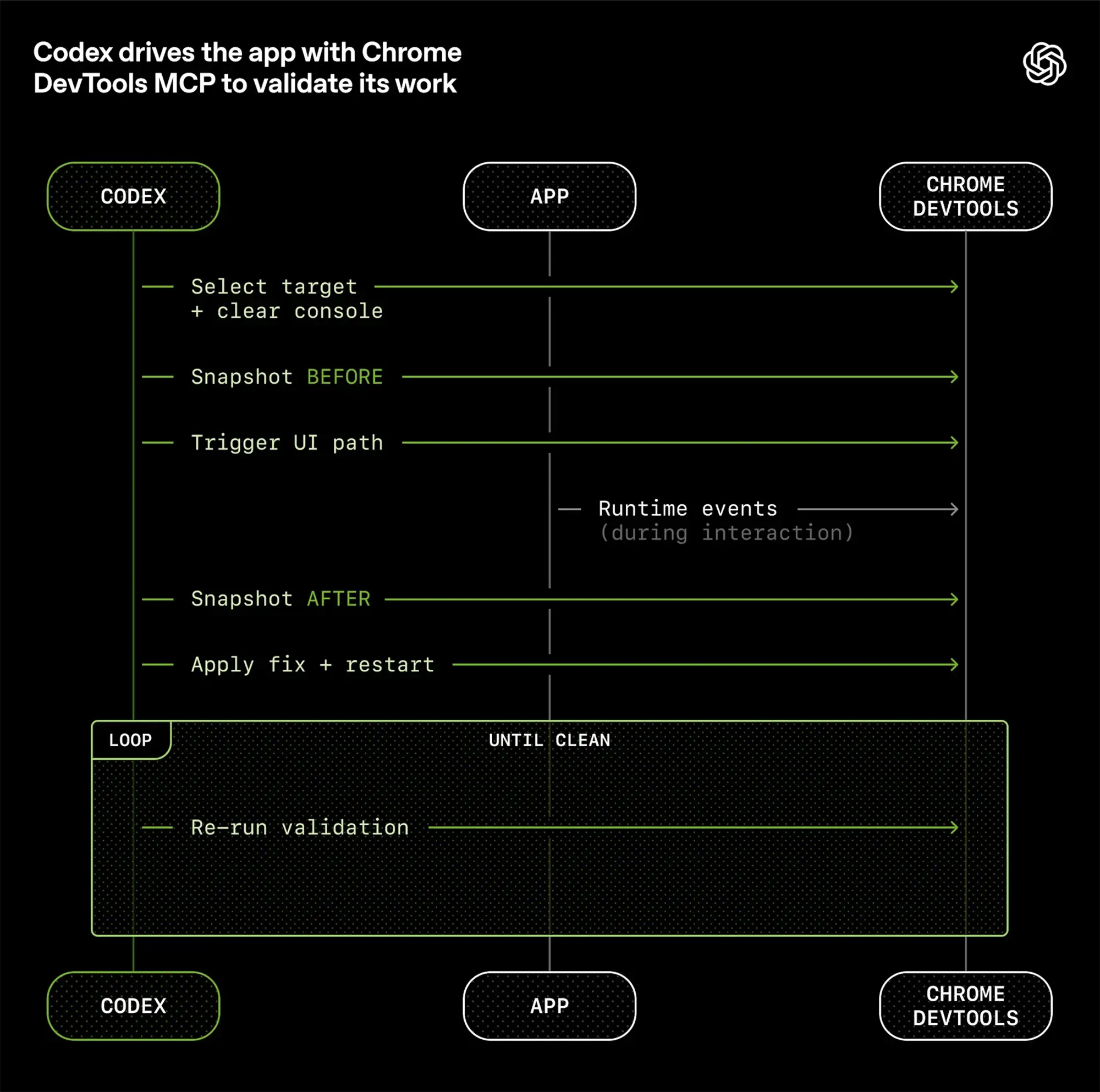

Visuelle Kontrolle im Browser

Ein technischer Sprung ist die Nutzung des „Model Context Protocol“ (MCP). Der Codex-Agent steuert direkt die Chrome Developer Tools. Er erstellt Screenshots vor und nach einer Änderung und prüft die Benutzeroberfläche visuell. Das System verlässt sich nicht nur auf abstrakte Unit-Tests, sondern „sieht“, ob die UI wie gewünscht funktioniert.

Quelle: OpenAI

Eine neue Desktop-App für macOS dient dabei als Leitzentrale, um mehrere dieser Agenten parallel zu steuern. Ob sich dieser Ansatz in komplexen Alt-Systemen (Brownfield) bewährt, muss die Praxis zeigen. Die Hürde ist hoch: Ohne lückenlose Dokumentation scheitert der autonome Agent.