Moderne KI-Modelle scheitern kollektiv an simplen Logikaufgaben

Eine neue Übersichtsstudie zeigt schonungslos auf, warum selbst die besten Sprachmodelle bei einfachen Denkaufgaben oftmals völlig versagen.

Moderne KI-Modelle weisen trotz aktueller Fortschritte eklatante Schwächen beim logischen Denken auf. Eine neue Übersichtsstudie belegt, dass selbst die fortschrittlichsten Systeme bei einfachen Deduktionsaufgaben systematisch Fehler produzieren. Forscher fassen diese grundlegenden Mängel nun in einer detaillierten Analyse zusammen.

Anzeige

Mustererkennung statt echter Deduktion

Entwickler trainieren große Sprachmodelle darauf, statistische Wahrscheinlichkeiten von Wortfolgen vorherzusagen. Diese grundlegende Architektur führt dazu, dass die Systeme komplexe Sachverhalte oft flüssig und überzeugend formulieren. Bei genauerer Betrachtung simulieren sie logische Schlussfolgerungen jedoch häufig nur, anstatt sie durch einen verlässlichen Regelkreis tatsächlich zu berechnen.

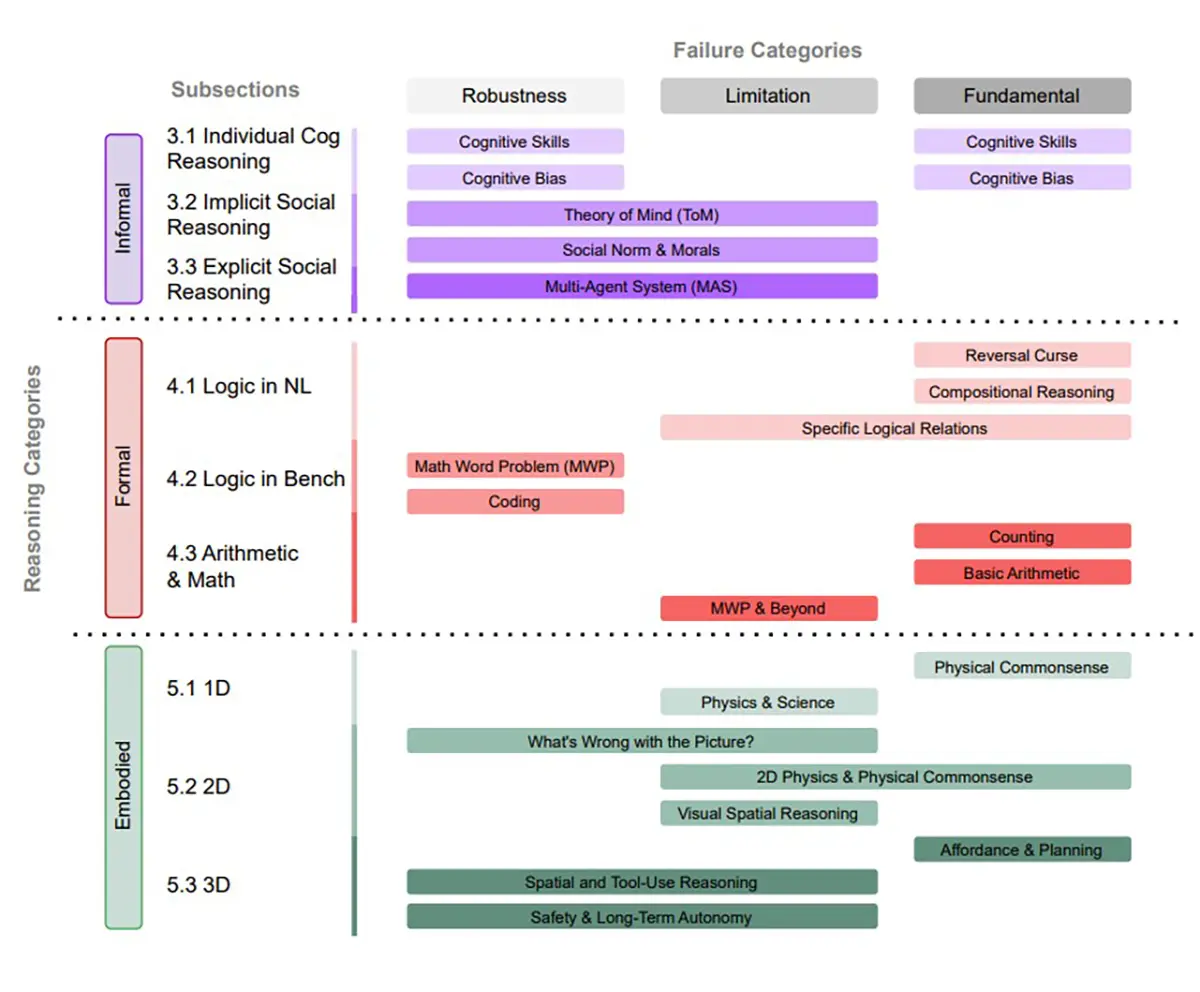

Das zeigt das aktuelle Papier "Large Language Model Reasoning Failures", das Forscher nun veröffentlicht haben. Die Autoren demonstrieren darin, dass etablierte LLMs bei einfachen mathematischen oder räumlichen Logiktests schnell an ihre Grenzen stoßen.

Sobald Forscher die Parameter einer bekannten Standardaufgabe auch nur minimal abändern, bricht die scheinbare Logik der Modelle oft komplett zusammen. Sie reproduzieren dann lediglich auswendig gelernte Muster aus ihren riesigen Trainingsdaten, ohne die zugrundeliegende Fragestellung wirklich zu erfassen. Dieses Verhalten entlarvt die aktuellen Reasoning-Fähigkeiten als sehr oberflächlich.

Quelle: arXiv:2602.06176

Ein Katalog der strukturellen Aussetzer

Um das Ausmaß der Problematik greifbar zu machen, bündelt ein begleitendes Open-Source-Repository auf GitHub zahlreiche dokumentierte Fehlschläge.

Diese Sammlung mit dem Titel "Awesome-LLM-Reasoning-Failures" verdeutlicht auf einen Blick, dass die Aussetzer keineswegs zufällig auftreten. Es handelt sich um tiefgreifende, strukturelle Defizite der zugrundeliegenden Technologie. Die fortlaufend aktualisierte Liste zeigt präzise auf, an welchen Stellen selbst die teuersten Modelle bei banalen Fragestellungen oder einfachen Text-Rätseln scheitern.

Viele Anwender verlassen sich im professionellen Alltag zunehmend auf die analytischen Fähigkeiten dieser Systeme. Die Studie mahnt hier zu einer nüchternen Betrachtung. Ein Algorithmus, der fehlerfreien Code generiert oder fließend übersetzt, besitzt nicht zwingend die Fähigkeit zur echten Logik. Ein leicht verändertes Prompt reicht in der Praxis oft aus, um das System vollständig aus dem Tritt zu bringen und falsche Schlüsse zu provozieren.

Forscher und Entwickler arbeiten aktuell intensiv an neuen mathematischen Ansätzen, um das Reasoning der Netzwerke fundamental zu verbessern. Bis diese strukturellen Anpassungen greifen, bleiben logische Aussetzer ein berechenbares Risiko bei der Nutzung von Sprachmodellen.